【导读】近年来,Transformer方兴未艾,但是其内在的二次复杂度阻碍了它在长序列和大模型上的进一步发展。清华大学软件学院机器学习实验室从网络流理论出发,提出任务通用的线性复杂度主干网络Flowformer,在长序列、视觉、自然语言、时间序列、强化学习五大任务上取得优秀效果。

任务通用是基础模型研究的核心目标之一,同时也是深度学习研究通向高级智能的必经之路。

近年来,得益于注意力机制的通用关键建模能力,Transformer在众多领域中表现优异,逐渐呈现出通用架构的趋势。但是随着序列长度的增长,标准注意力机制的计算呈现二次复杂度,严重阻碍了其在长序列建模与大模型中的应用。

为此,来自清华大学软件学院的团队深入探索了这一关键问题,提出了任务通用的线性复杂度主干网络Flowformer,在保持标准Transformer的通用性的同时,将其复杂度降至线性,论文被ICML 2022接受。

作者列表:吴海旭,吴佳龙,徐介晖,王建民,龙明盛

链接:https://arxiv.org/abs/2202.06258

代码:https://github.com/thuml/Flowformer相比于标准Transformer,本文提出的Flowformer模型,具有以下特点:

- 线性复杂度,可以处理数千长度的输入序列;

- 没有引入新的归纳偏好,保持了原有注意力机制的通用建模能力;

- 任务通用,在长序列、视觉、自然语言、时间序列、强化学习五大任务上取得优秀效果。

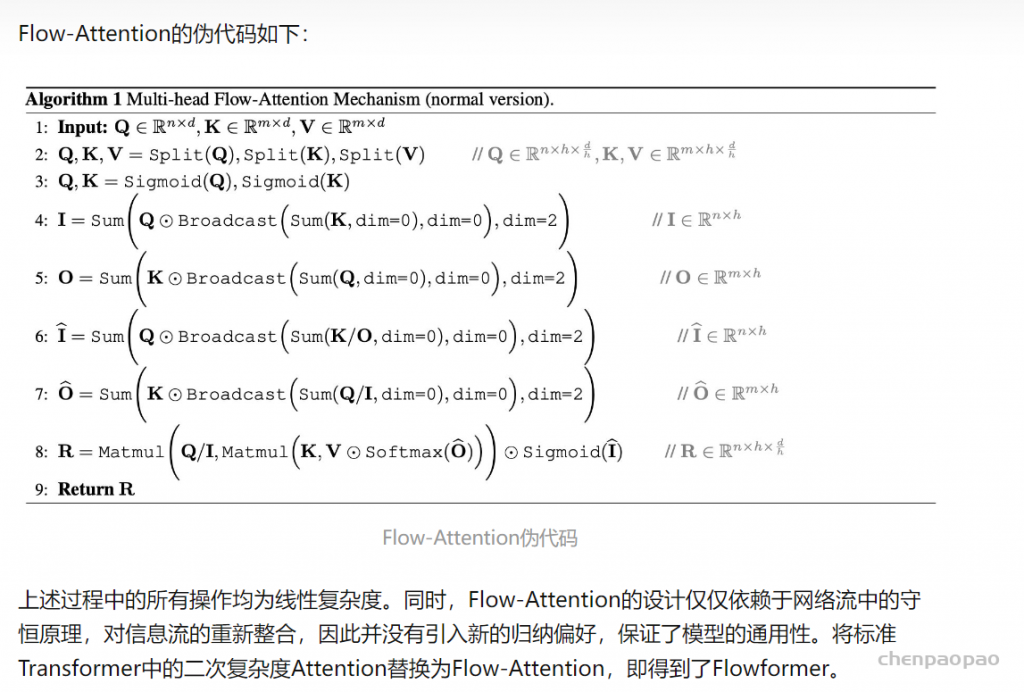

本文深入研究了注意力机制存在的二次复杂度问题,通过将网络流中的守恒原理引入设计,自然地将竞争机制引入到注意力计算中,有效避免了平凡注意力问题。

我们提出的任务通用的骨干网络Flowformer,实现了线性复杂度,同时在长序列、视觉、自然语言、时间序列、强化学习五大任务上取得优秀效果。

在长序列建模应用上,如蛋白质结构预测、长文本理解等,Flowformer具有良好的应用潜力。此外,Flowformer中“无特殊归纳偏好”的设计理念也对通用基础架构的研究具有良好的启发意义。