n 位格雷码序列 是一个由 2n 个整数组成的序列,其中:

- 每个整数都在范围

[0, 2n - 1]内(含0和2n - 1) - 第一个整数是

0 - 一个整数在序列中出现 不超过一次

- 每对 相邻 整数的二进制表示 恰好一位不同 ,且

- 第一个 和 最后一个 整数的二进制表示 恰好一位不同

给你一个整数 n ,返回任一有效的 n 位格雷码序列 。

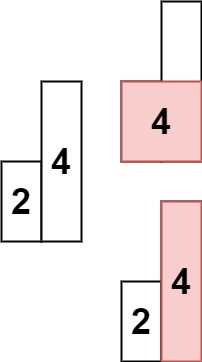

示例 1:

输入:n = 2

输出:[0,1,3,2]

解释:

[0,1,3,2] 的二进制表示是 [00,01,11,10] 。

- 00 和 01 有一位不同

- 01 和 11 有一位不同

- 11 和 10 有一位不同

- 10 和 00 有一位不同

[0,2,3,1] 也是一个有效的格雷码序列,其二进制表示是 [00,10,11,01] 。

- 00 和 10 有一位不同

- 10 和 11 有一位不同

- 11 和 01 有一位不同

- 01 和 00 有一位不同代码实现:

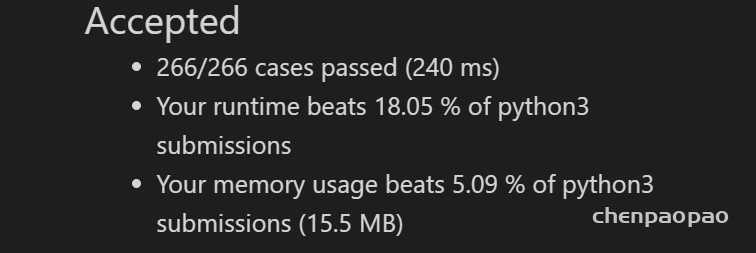

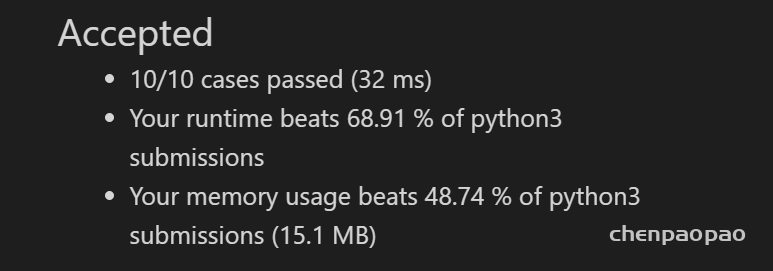

# @lc app=leetcode.cn id=89 lang=python3

#

# [89] 格雷编码

#

# @lc code=start

class Solution:

def grayCode(self, n: int) -> List[int]:

def subgrayCode(n):

mid=list()

if n==1:

return ["0","1"]

else:

res=subgrayCode(n-1)

lens=len(res)

for i in range(lens):

mid.append("0"+res[i])

for i in range(lens-1,-1,-1):

mid.append("1"+res[i])

return mid

x=subgrayCode(n)

for i in range(len(x)):

x[i]=int(x[i],2)

return x

# @lc code=end