这两个是互逆的操作。

先来看为什么需要pad和pack操作:

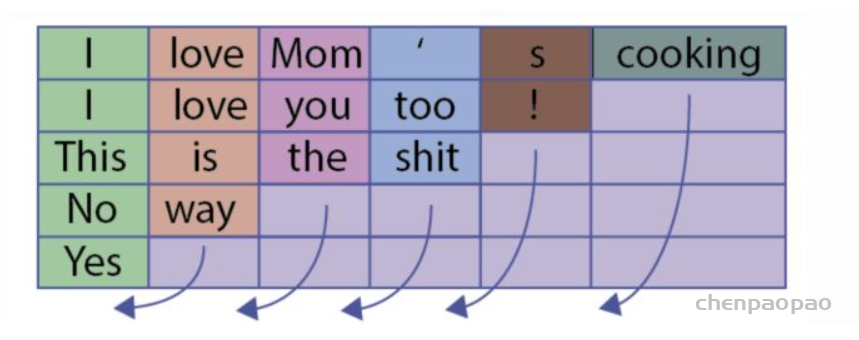

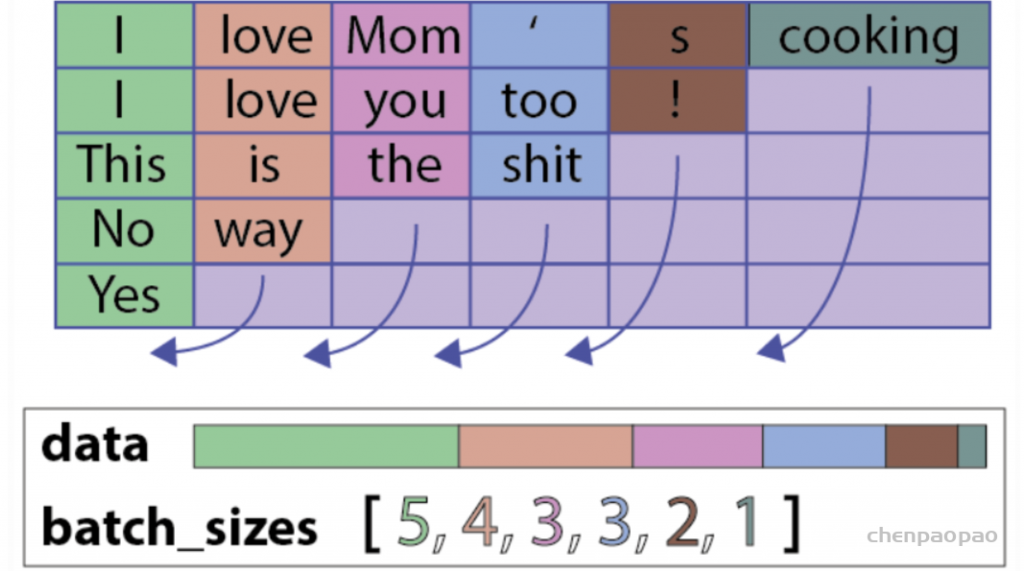

先看一个例子,这个batch中有5个sample

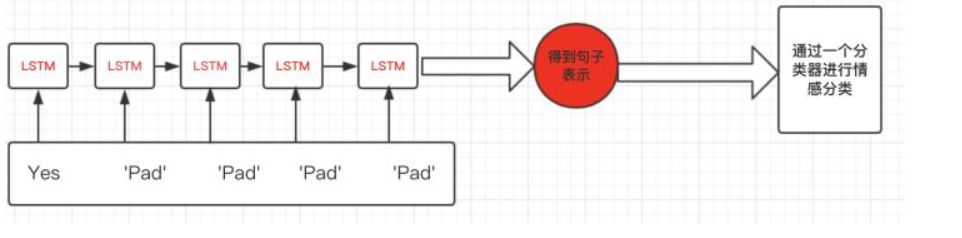

如果不用pack和pad操作会有一个问题,什么问题呢?比如上图,句子“Yes”只有一个单词,但是padding了多余的pad符号,这样会导致LSTM对它的表示通过了非常多无用的字符,这样得到的句子表示就会有误差,更直观的如下图:

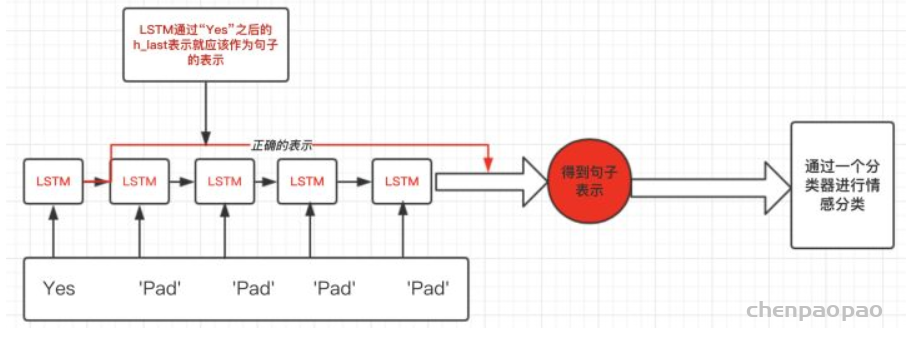

那么我们正确的做法应该是怎么样呢?

在上面这个例子,我们想要得到的表示仅仅是LSTM过完单词”Yes”之后的表示,而不是通过了多个无用的“Pad”得到的表示:如下图:

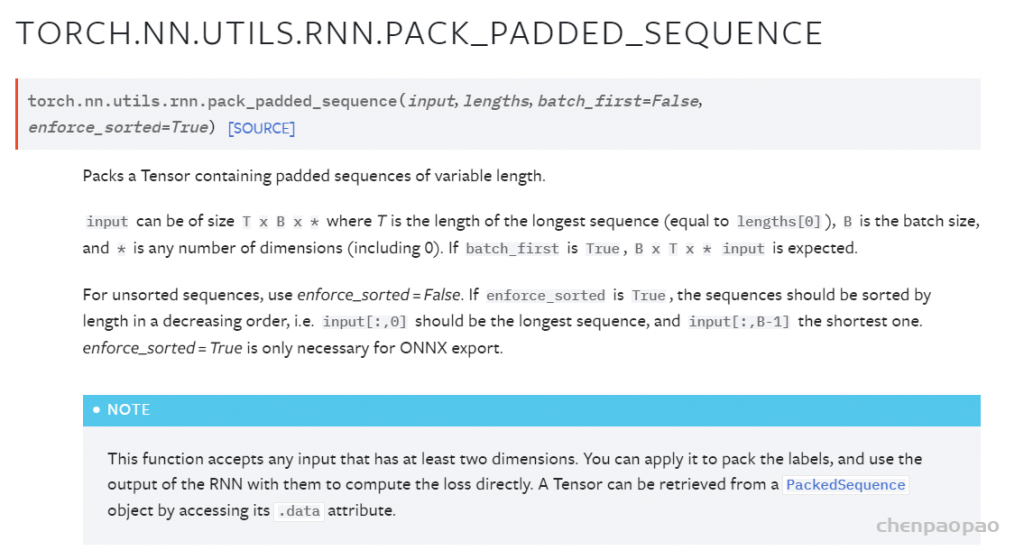

torch.nn.utils.rnn.pack_padded_sequence()

这里的pack,理解成压紧比较好。 将一个 填充过的变长序列 压紧。(填充时候,会有冗余,所以压紧一下)

其中pack的过程为:(注意pack的形式,不是按行压,而是按列压)

pack之后,原来填充的 PAD(一般初始化为0)占位符被删掉了。

输入的形状可以是(T×B×* )。T是最长序列长度,B是batch size,*代表任意维度(可以是0)。如果batch_first=True的话,那么相应的 input size 就是 (B×T×*)。

Variable中保存的序列,应该按序列长度的长短排序,长的在前,短的在后。即input[:,0]代表的是最长的序列,input[:, B-1]保存的是最短的序列。

NOTE: 只要是维度大于等于2的input都可以作为这个函数的参数。你可以用它来打包labels,然后用RNN的输出和打包后的labels来计算loss。通过PackedSequence对象的.data属性可以获取 Variable。

参数说明:

- input (Variable) – 变长序列 被填充后的 batch

- lengths (list[int]) –

Variable中 每个序列的长度。 - batch_first (bool, optional) – 如果是

True,input的形状应该是B*T*size。 - 参数 enforce_sorted ,如果是 True ,则输入应该是按长度降序排序的序列。如果是 False ,会在函数内部进行排序。默认值为 True 。也就是说在输入 pack_padded_sequence 前,我们也可以不对数据进行排序。

返回值:

一个PackedSequence 对象。

torch.nn.utils.rnn.pad_packed_sequence()

填充packed_sequence。

上面提到的函数的功能是将一个填充后的变长序列压紧。 这个操作和pack_padded_sequence()是相反的。把压紧的序列再填充回来。填充时会初始化为0。

返回的Varaible的值的size是 T×B×*, T 是最长序列的长度,B 是 batch_size,如果 batch_first=True,那么返回值是B×T×*。

Batch中的元素将会以它们长度的逆序排列。

参数说明:

- sequence (PackedSequence) – 将要被填充的 batch

- batch_first (bool, optional) – 如果为True,返回的数据的格式为

B×T×*。

返回值: 一个tuple,包含被填充后的序列,和batch中序列的长度列表

实例 代码:

>>> from torch.nn.utils.rnn import pack_padded_sequence, pad_packed_sequence

>>> seq = torch.tensor([[1,2,0], [3,0,0], [4,5,6]])

#seq的维度是3*3,第一个 维度表示T,is the length of the longest sequence

#第二维表示B,批次大小,也就是说有3个长度为3的向量,其中每列表示一个序列,序列都是等长的,因为短的序列已经用0补齐了

>>> lens = [2, 1, 3]

>>> packed = pack_padded_sequence(seq, lens, batch_first=True, enforce_sorted=False)

#将补齐的序列压紧成一个序列,将0去掉

>>> packed

PackedSequence(data=tensor([4, 1, 3, 5, 2, 6]), batch_sizes=tensor([3, 2, 1]),

sorted_indices=tensor([2, 0, 1]), unsorted_indices=tensor([1, 2, 0]))

>>> seq_unpacked, lens_unpacked = pad_packed_sequence(packed, batch_first=True)

>>> seq_unpacked

tensor([[1, 2, 0],

[3, 0, 0],

[4, 5, 6]])

>>> lens_unpacked

tensor([2, 1, 3])pad_sequence

参数

sequences:表示输入样本序列,为 list 类型,list 中的元素为 tensor 类型。 tensor 的 size 为 L * F 。其中,L 为单个序列的长度,F 为序列中每个时间步(time step)特征的个数,根据任务的不同 F 的维度会有所不同。

batch_first:为 True 对应 [batch_size, seq_len, feature];False 对应[seq_len, batch_size, feature],从习惯上来讲一般设置为 True 比较符合我们的认知。

padding_value:填充值,默认值为 0 。

说明

主要用来对样本进行填充,填充值一般为 0 。我们在训练网络时,一般会采用一个一个 mini-batch 的方式,将训练样本数据喂给网络。在 PyTorch 里面数据都是以 tensor 的形式存在,一个 mini-batch 实际上就是一个高维的 tensor ,每个序列数据的长度必须相同才能组成一个 tensor 。为了使网络可以处理 mini-batch 形式的数据,就必须对序列样本进行填充,保证一个 mini-batch 里面的数据长度是相同的。

在 PyTorch 里面一般是使用 DataLoader 进行数据加载,返回 mini-batch 形式的数据,再将此数据喂给网络进行训练。我们一般会自定义一个 collate_fn 函数,完成对数据的填充。

import torch

from torch.utils.data import Dataset, DataLoader

from torch.nn.utils.rnn import pad_sequence,pack_padded_sequence,pack_sequence,pad_packed_sequence

class MyData(Dataset):

def __init__(self, data):

self.data = data

def __len__(self):

return len(self.data)

def __getitem__(self, idx):

return self.data[idx]

def collate_fn(data):

data.sort(key=lambda x: len(x), reverse=True)

data = pad_sequence(data, batch_first=True, padding_value=0)

return data

a = torch.tensor([1,2,3,4])

b = torch.tensor([5,6,7])

c = torch.tensor([7,8])

d = torch.tensor([9])

train_x = [a, b, c, d]

data = MyData(train_x)

data_loader = DataLoader(data, batch_size=2, shuffle=True, collate_fn=collate_fn)

# 采用默认的 collate_fn 会报错

#data_loader = DataLoader(data, batch_size=2, shuffle=True)

batch_x = iter(data_loader).next()运行程序,得到 batch_x 的值:

# batch_x

tensor([[1, 2, 3, 4],

[9, 0, 0, 0]])从 batch_x 的值可以看出,第二行填充了三个 0 ,使其长度和第一行保持一致。

需要说明的是,对于长度不同的序列,使用默认的 collate_fn 函数,不自定义 collate_fn 函数完成对序列的填充,上面的程序就会报错。