Diganta Misra的一篇题为“Mish: A Self Regularized Non-Monotonic Neural Activation Function”的新论文介绍了一个新的深度学习激活函数,该函数在最终准确度上比Swish(+.494%)和ReLU(+ 1.671%)都有提高。

ReLU和Mish的对比,Mish的梯度更平滑

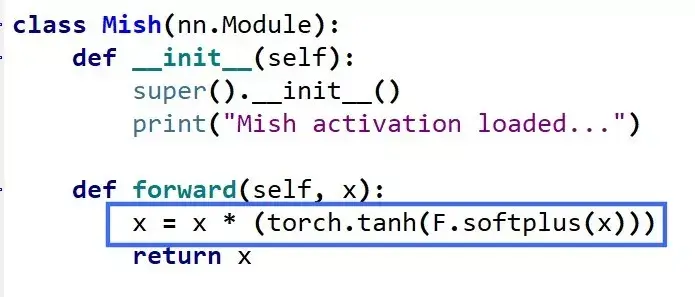

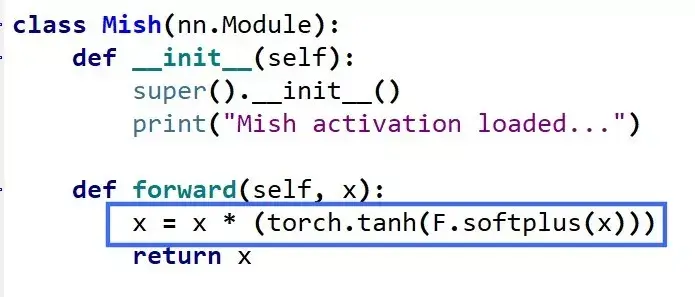

Mish=x * tanh(ln(1+e^x))

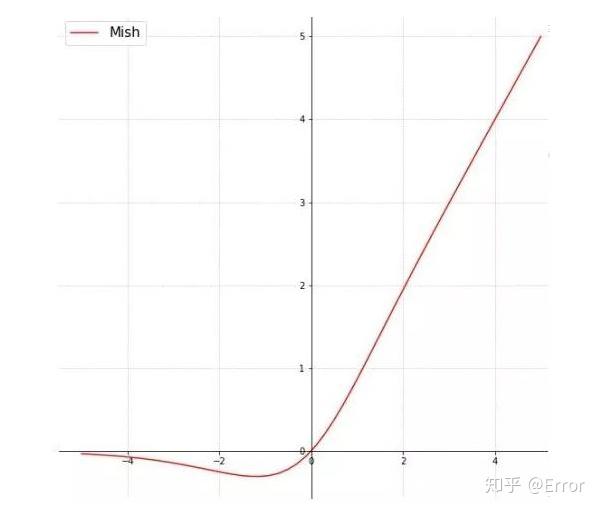

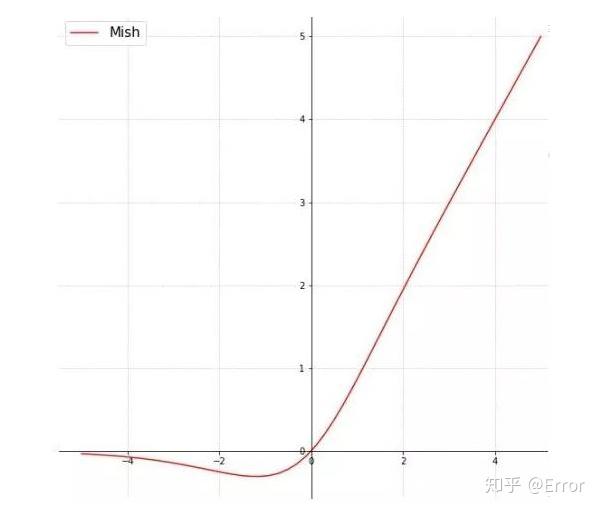

函数图像:

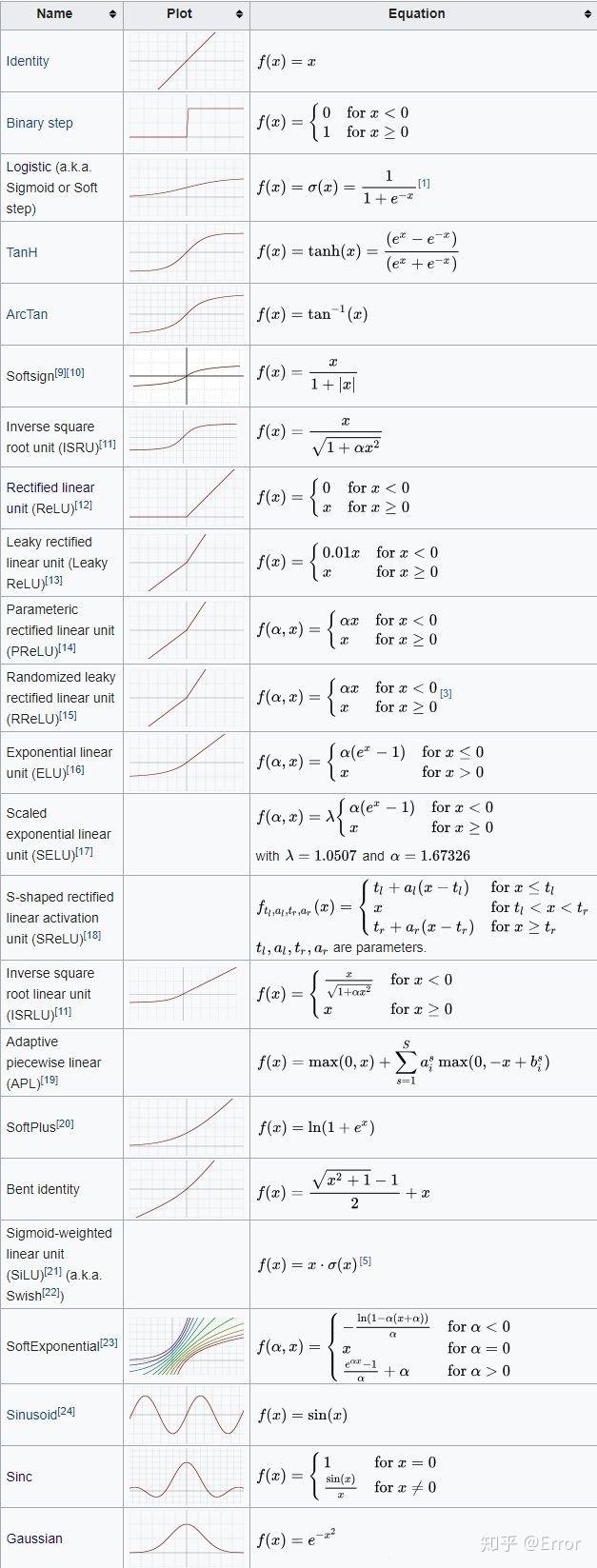

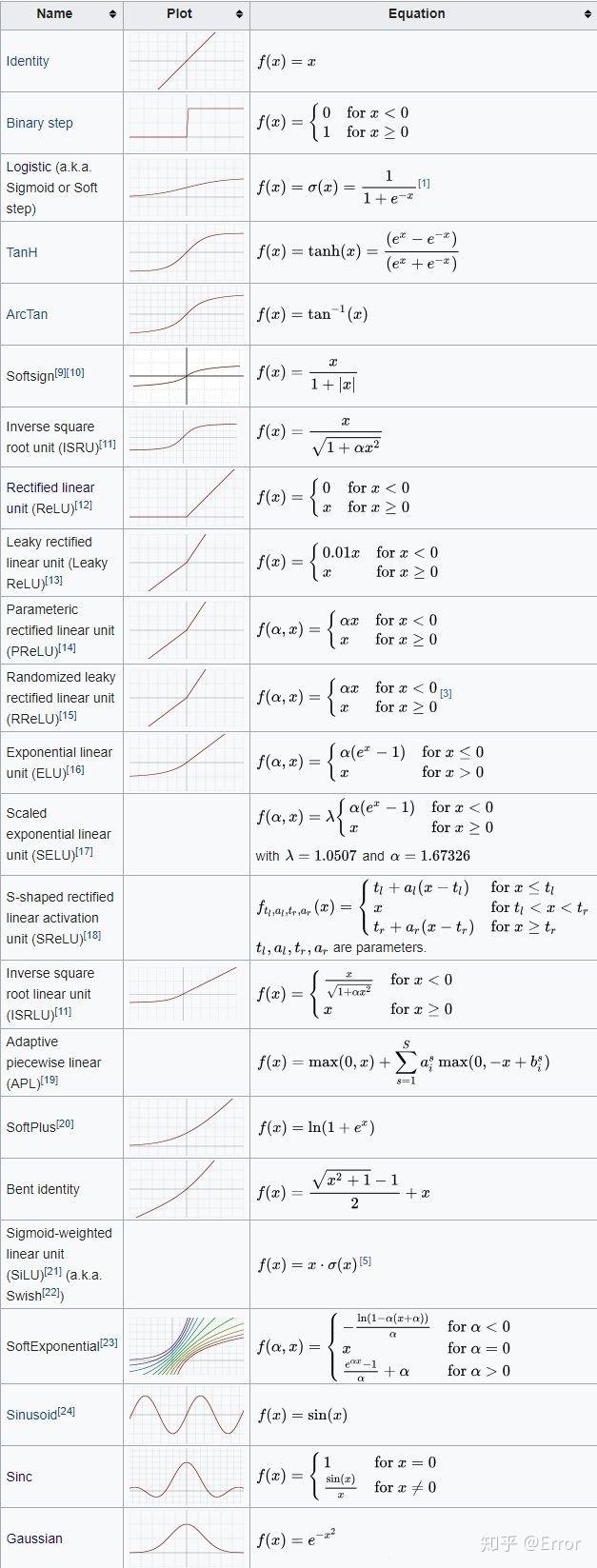

常见激活函数:

Diganta Misra的一篇题为“Mish: A Self Regularized Non-Monotonic Neural Activation Function”的新论文介绍了一个新的深度学习激活函数,该函数在最终准确度上比Swish(+.494%)和ReLU(+ 1.671%)都有提高。

ReLU和Mish的对比,Mish的梯度更平滑

Mish=x * tanh(ln(1+e^x))

函数图像:

常见激活函数: