Fun-Audio-Chat 是为自然、低延迟语音交互构建的大型音频语言模型。它引入了双分辨率语音表示(一个高效的 5Hz 共享主干 + 一个 25Hz 的精炼头)以在降低计算的同时保持高语音质量,并采用 Core-Cocktail 训练以保留强大的文本 LLM 能力。它在语音问答、音频理解、语音函数调用以及语音指令遵循和情感共鸣基准上都取得了顶级成果。

现有模型面临的挑战:语音 Token(通常约 25Hz)与文本 Token(约 3Hz)在时间分辨率上的不匹配会削弱语义信息 ,同时带来高计算成本、限制实际部署,并在多模态训练过程中导致文本 LLM 知识的灾难性遗忘。

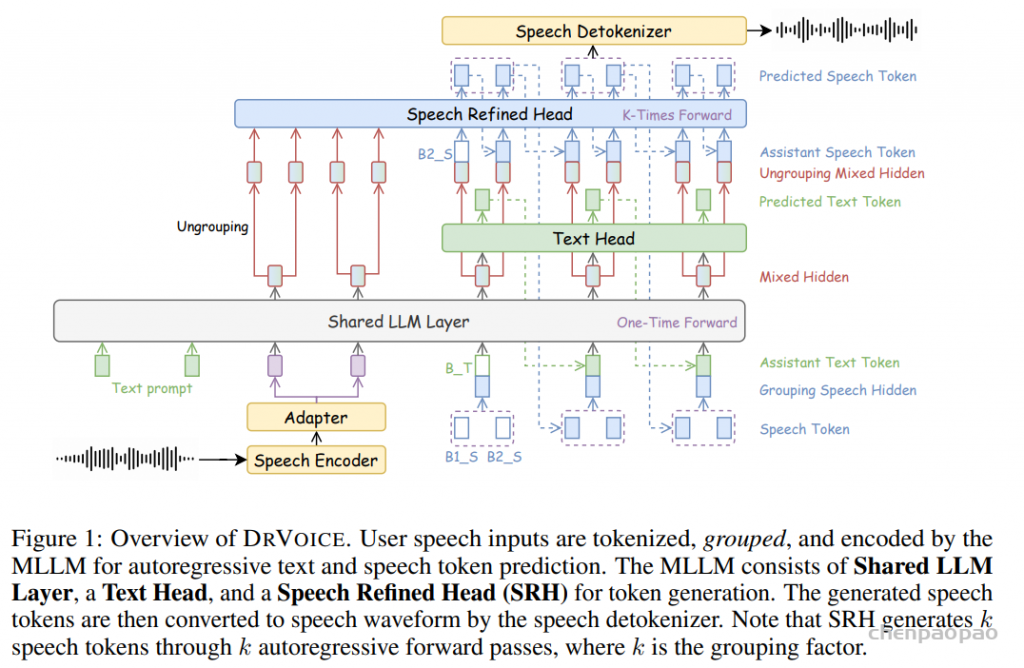

Fun-Audio-Chat 采用 双分辨率语音表征(Dual-Resolution Speech Representations, DRSR) 架构:共享的 LLM 主干以高效的 5Hz 帧率 处理音频(通过语音 Token 分组实现),而 Speech Refined Head(SRH) 则以 25Hz 分辨率 生成高质量语音 Token。该双分辨率设计在计算效率与语音生成质量之间实现了有效平衡,使 GPU 训练时长降低近 50% 。

不同于某些语音模型的大规模音频-文本预训练与后训练方法,Fun-Audio-Chat基于预训练模型,全量监督微调阶段采用 Core-Cocktail Training 策略缓解灾难性遗忘问题,后训练使用多任务 DPO 训练 以增强模型在鲁棒性、音频理解、指令遵循及情感化语音共情能力方面的表现。Fun-Audio-Chat 在有效保留原始文本 LLM 知识的同时,获得了强大的音频理解、推理与生成能力。

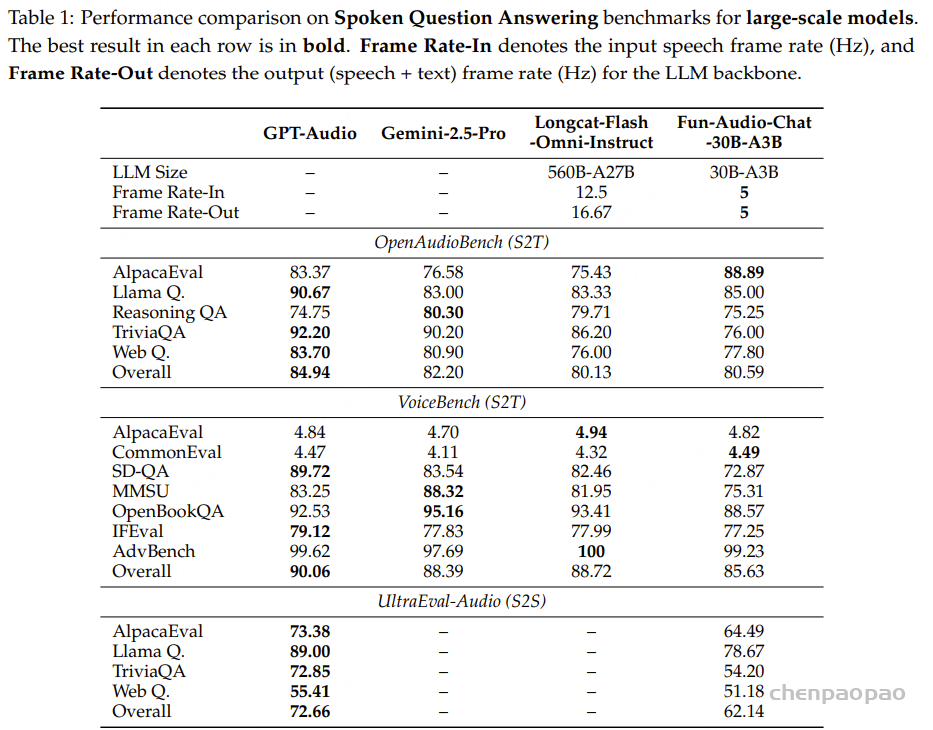

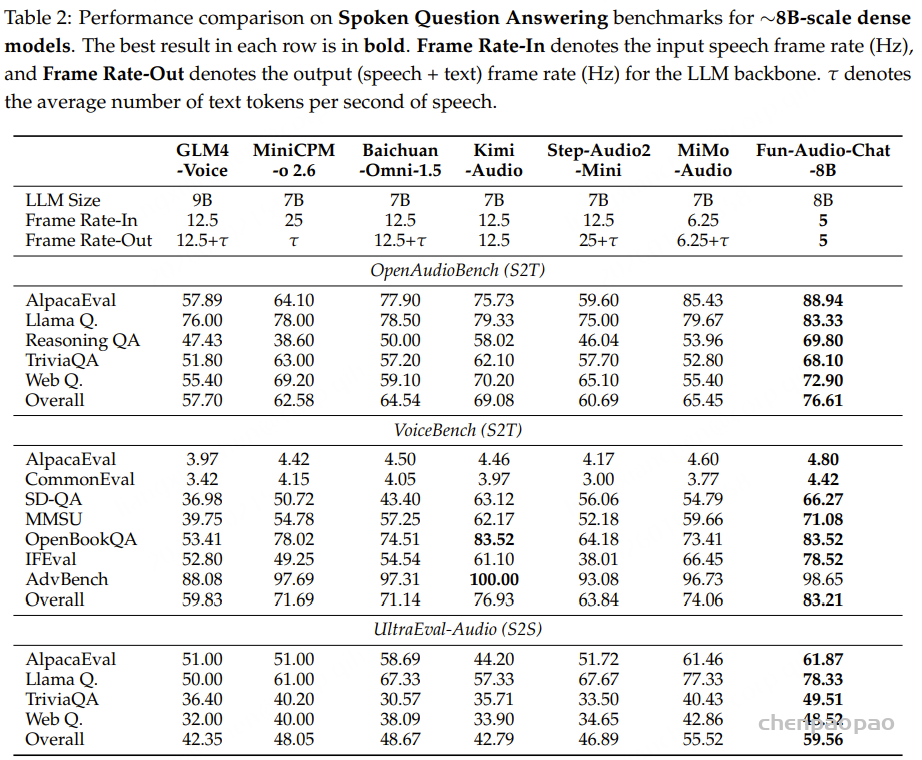

模型在语音转文本与语音-语音生成任务上取得了具有竞争力的性能,并在多项口语问答基准测试中位列同规模模型的领先水平。同时,其在音频理解、语音函数调用、语音指令遵循以及语音共情等任务上亦展现出媲美甚至优于同类模型的表现。构建了 Fun-Audio-Chat-Duplex ,一种全双工变体,在口语问答基准与全双工交互场景中均取得了优异性能。

Spoken QA tasks:其中Mimo-Auido 进行大规模语音预训练 other tasks Introduction

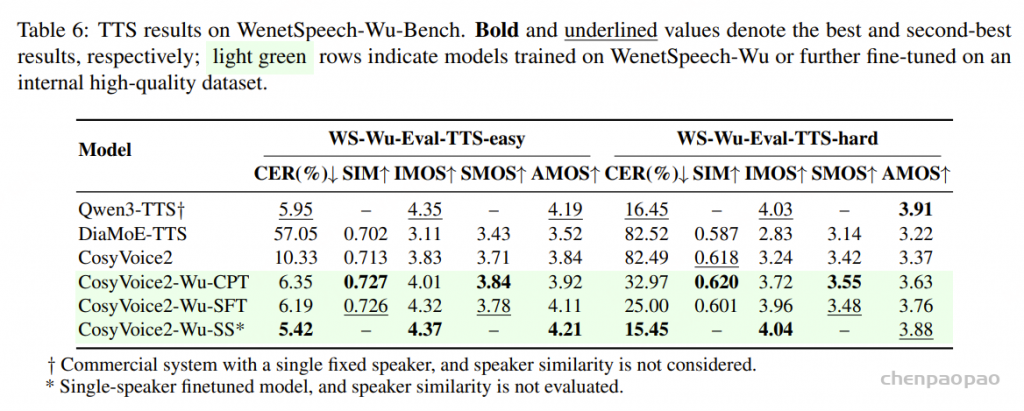

现有语音大模型面临以下挑战:

语音token与文本token速率不匹配,跨模态对齐时多个语音帧映射到单个文本 token 的语义空间 ,会影响语义信息且LLM 难以复用其原生 token-level 推理能力; 多模态的预训练与后训练,会导致其原有知识发生灾难性遗忘; 频帧率通常较高(如 12.5Hz 或 25Hz),整体计算成本偏高,限制了模型在实际场景部署。 针对以上问题,提出 Fun-Audio-Chat :

大规模后训练与模型扩展能力。基于DrVoice 的两项关键创新——双分辨率语音表征(DRSR)架构 与 Core-Cocktail 训练策略 ——基础上,进一步扩展到显著更大的数据与模型规模,包括覆盖 数百万小时的多样化音频数据 ,以及 dense 8B 参数模型与 MoE 30B-A3B 参数模型主干 LLM 的高效 5Hz 处理 与 25Hz 生成头 ,即使在更大规模训练中,仍能保持高计算效率(训练 GPU 时长约 降低 50% );同时,Core-Cocktail 训练策略 通过 两阶段训练、分阶段学习率及中间模型合并机制 ,在 8B 与 30B-A3B 模型 中均有效缓解了灾难性遗忘问题。 多任务 DPO 训练以提升鲁棒性与泛化能力。DPO 训练 增强 Fun-Audio-Chat 的能力,包括:对真实语音数据的鲁棒性、指令遵循能力、音频理解能力以及语音共情能力 。通过多任务 DPO 训练,Fun-Audio-Chat 获得了超越基础语音-文本交互的高级能力 ,包括 语音函数调用、语音指令遵循,以及语音共情(识别并推理用户情绪状态并生成具有共情特质的响应) ,使模型能够以适当的情感智能与功能执行能力,理解并应对复杂语音交互场景。 全双工语音交互能力。Fun-Audio-Chat-Duplex ,一种支持双向同时语音通信的全双工变体 。该模型在口语问答基准任务上表现出具有竞争力的性能,同时在全双工交互指标上亦取得优异结果,展现出在自然对话与轮流发言(turn-taking)方面的强大能力。Methodology

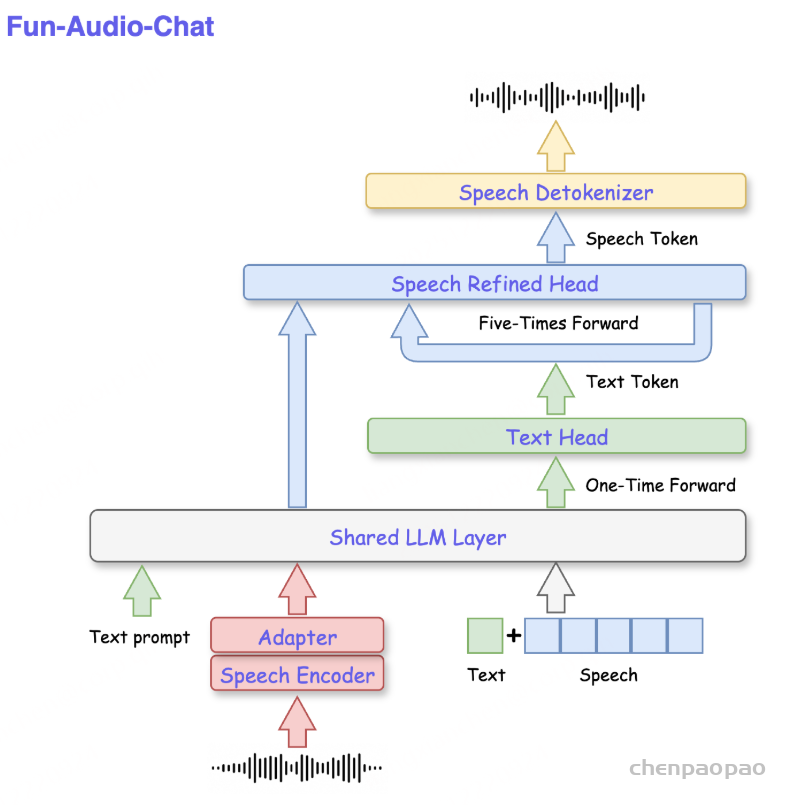

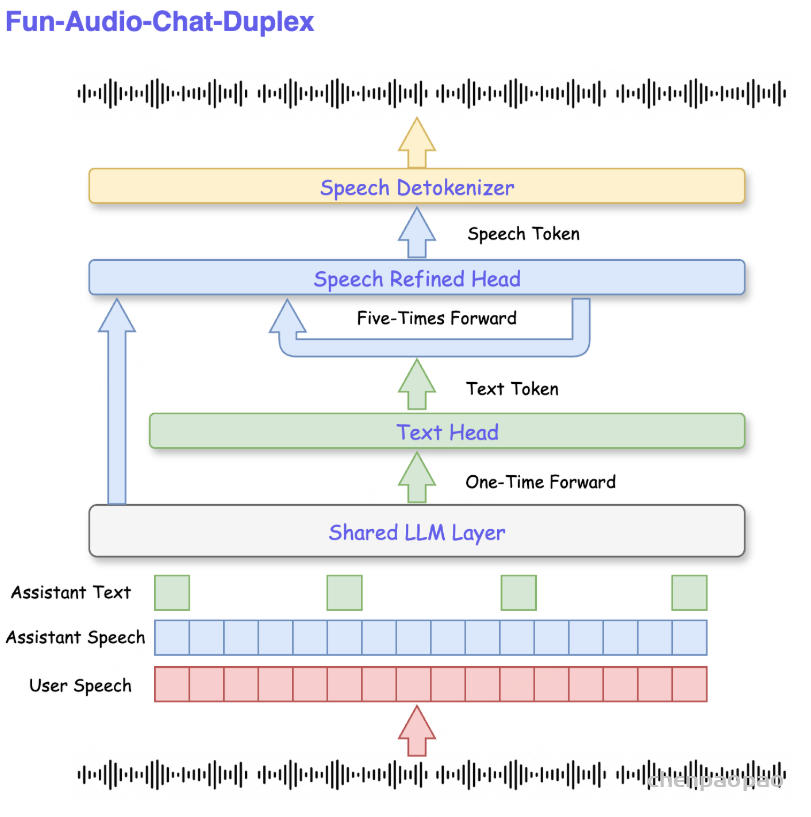

语音输入经过 MLLM(多模态大语言模型) 的 Tokenization 、分组处理 和 编码 ,分别用于两种自回归预测任务:Text Head :预测文本 token,Speech Refined Head(SRH) :预测语音 token。生成的语音 token 随后通过 speech detokenizer 转换为语音波形。需要注意的是:SRH 通过 5 次自回归前向传播 生成 5 个语音 token ,其中 5 为分组因子。 Fun-Audio-Chat 的全双工通信模式 上图展示了 Fun-Audio-Chat 及其全双工变体 Fun-Audio-Chat-Duplex 的架构。

Fun-Audio-Chat 的框架主要由三个模块组成:

语音输入处理模块 :通过 Speech Encoder 与 Speech Tokenizer 将原始音频波形转换为结构化表示,分别用于用户端(User)和助手端(Assistant)。多模态大语言模型 :整合 共享 LLM 主干 与专门的 Text Head 和 Speech Refined Head(SRH) ,用于生成文本 token 与语音 token。Speech Detokenizer :将生成的语音 token 重建为音频波形。该架构实现了统一的音频-文本编码 和同步的语音-文本生成 。在推理阶段,无论输入为文本还是语音,均会被转换到一个统一的语义表示空间 ,由 MLLM 处理,从而通过 SRH 和 Text Head 同时生成语音和文本输出。

Speech Tokenization and Detokenization

Fun-Audio-Chat 采用 Whisper-Large-v3 作为 语音编码器 ,从用户语音输入中提取连续表征。随后, Adapter 模块 对这些特征进行时间分辨率降采样 ,并将其维度匹配到 LLM 的隐藏空间。

鉴于语义 token 在语音表征中的有效性其,尤是其与文本内容的高度对应性,采用 S3Tokenizer 语音分词器 ,将音频波形转换为离散的语义 token 序列。S=[s0,s1,…,sT−1] 其中 T 表示序列长度,用于助手端(Assistant)的输出。

S3Tokenizer 最初是在 CosyVoice [论文] [代码库] 中引入的,它是一个基于预训练的 SenseVoice-Large 模型的监督语义语音分词器,它增强了提取的词元与文本和副语言信息的语义关系,对数据噪声具有鲁棒性,并减少了对干净数据收集的依赖,从而使模型训练可以使用更广泛的数据来源 。 在逆向过程中,Speech Detokenizer [CosyVoice3的模型解码合成音频]利用 speaker-specific embeddings 编码音色等声学特征。随后,Flow Matching 模型 将这些 token 转换为 Mel 频谱表示,再通过 HiFi-GAN 声码器 将 Mel 频谱重建为音频波形。

Dual-Resolution Speech Representations (DRSR)

为了在支持跨模态能力的同时 保持预训练文本 LLM 的文本能力 ,Fun-Audio-Chat 采用了先前工作 DrVoice 中提出的 双分辨率语音表征(Dual-Resolution Speech Representations,DRSR) 架构。该架构有效解决了 语音 token(通常约 25Hz)与文本 token(约 3Hz)之间的时间分辨率不匹配问题 ,同时提升计算效率,并实现高质量语音生成。

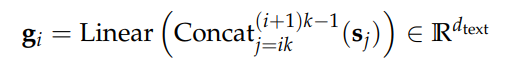

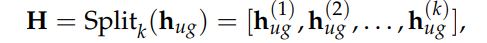

语音 Token 分组 。为弥合时间分辨率差异,采用 DrVoice中的分组技术,将 25Hz 的语音 token 转换为 5Hz 的表示 ,并输入至 共享 LLM 主干 。该分组变换可表示为:

其中 𝐬 j Concat 表示串联,k=5 是基于语音 Token 频率 (25Hz) 与所需 LLM 处理频率 (5Hz) 之比的分组因子。这种机制将序列长度从T 减少到T/k ,允许共享LLM以5Hz帧速率运行,这大大减少了计算开销(训练GPU时间减少了大约50%),同时保留了LLM的语义推理能力。

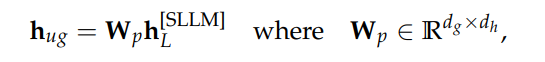

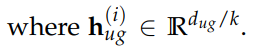

Speech Refined Head (SRH). 分组机制提升了计算效率,但其同时会丢失对自然语音合成至关重要的细粒度声学信息 。为弥补这一不足,Fun-Audio-Chat 引入了一个专用的 SRH ,用于在 完整的 25Hz 分辨率 下生成语音 token。SRH 执行一种反分组(ungrouping)操作 ,来自 共享 LLM 的最终隐藏状态 hL [SLLM] 首先通过线性投影 被转换为与分组大小一致的嵌入表示:

接下来分解为 k 段:

生成的 𝐇 为 SRH 提供条件上下文,SRH 以 25Hz 自回归方式生成语音标记。 训练目标优化语音标记预测:

其中 si 表示第 i 个语音标记。 这种双分辨率框架允许 Fun-Audio-Chat 遵循 DrVoice 中建立的设计原则,同时实现计算效率(共享 LLM 层中的 5Hz 处理)和高保真语音合成(通过 SRH 生成 25Hz)。

Multimodal Large Language Model (MLLM)

MLLM 架构在预训练文本 LLM 的基础上进行扩展,使其具备统一的音频-文本处理能力,从而能够接收语音或文本任一模态输入,并同时生成语音与文本输出。Fun-Audio-Chat 属于并行式联合语音-文本模型。借鉴 Moshi 的做法,我们在模型中引入 显式文本流 ,用于为语音生成提供语义引导。模型设计仅在 助手侧 进行模态对齐,这反映了人机对话中的固有非对称性 :用户通常只提供单一模态输入(文本或语音) ,而助手则能够输出协调一致的多模态响应 (即联合语音-文本输出或仅文本输出)。

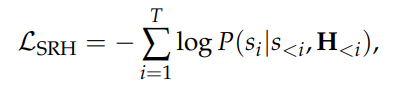

模型利用 LLM 的自回归特性 ,在每一步迭代地将 语音 token st 与 文本 token tt 一并输入至 共享 LLM 层 。两类 token 的嵌入向量通过逐元素相加(addition)进行融合,形成统一的输入表示。第 t步的复合嵌入:

其中,Espeech 与Etext 分别表示语音与文本 token 的嵌入函数。为解决语音序列与文本序列在长度上的不匹配问题,我们对较短的序列进行填充,并在每个话语中使用特殊静音标记 <|SIL|>作为填充值。

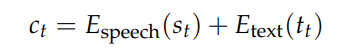

模型的生成过程遵循自回归范式:

其中,x 表示输入,yt =(st ,tt ) 表示在时间步 t 的联合语音–文本输出。该建模方式在同一自回归过程中统一了语音与文本的联合生成。

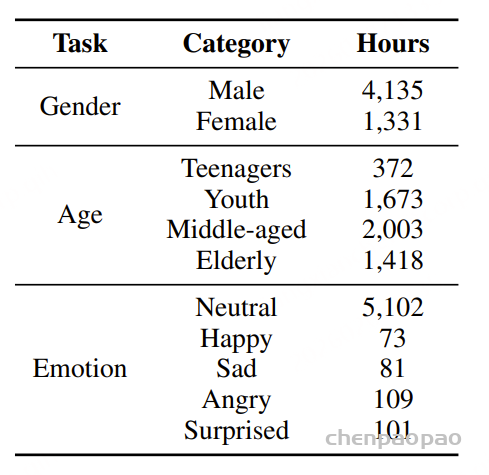

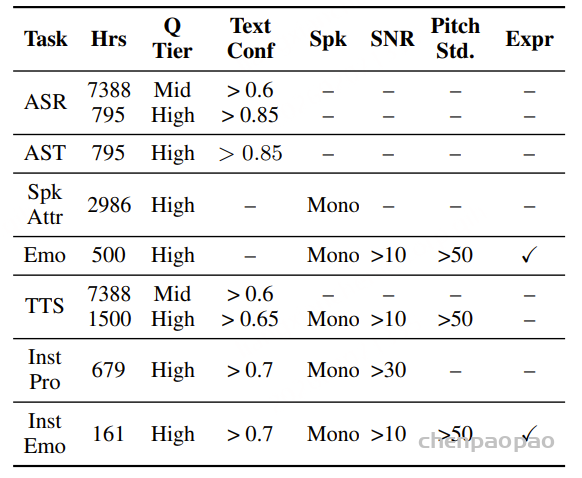

Post-Training

Fun-Audio-Chat 基于已有的预训练模型构建,并采用多阶段后训练流程进行训练,利用覆盖多领域、多任务的数百万小时语音数据,其中包括对话语音与多语言语音,以及面向语音理解任务的音频数据,从而保证对多种应用场景与使用需求的全面覆盖。自建数据则包括文本、ASR、TTS、音频理解、语音指令跟随以及语音共情数据。

整个多阶段训练流程包括以下三个阶段:Pre-alignment :利用大规模语音-文本配对数据,对 Speech Encoder、Adapter 与 Speech Refined Head 进行对齐训练 ;Core-Cocktail 训练阶段 :用于监督式全参数微调 ,采用由 CosyVoice 3基于数十亿文本 token 合成的高质量语音数据,并通过合成语音的词错误率(WER)阈值筛选得到 ;多任务 DPO 训练阶段 :引入多样化真实语音数据以提升鲁棒性,引入音频理解与 ASR 数据以增强理解与感知能力,同时使用指令跟随数据(包含情感、风格与韵律控制)以提升语音指令跟随能力,并结合语音共情数据以强化情感理解与共情式响应生成能力。

预对齐阶段 Speech Encoder 采用 Whisper-Large-v3的权重进行初始化,从而提供稳健的语音理解能力。Shared LLM Layer 使用 Qwen3-30B-A3B进行初始化,或可替代性地采用视觉-语言基础模型 Qwen3-VL-8B,以充分利用预训练文本 LLM 强大的语义理解能力。此外,来自 CosyVoice 3的预训练 Speech Tokenizer 与 Speech Detokenizer 被直接引入,并在 Fun-Audio-Chat 的整个训练过程中保持冻结。

预对齐训练 :使用大规模语音-文本配对数据,对 Speech Encoder、Adapter 与 Speech Refined Head 进行联合对齐学习。在该阶段中,Shared LLM Layer 被保持冻结,以确保其预训练能力不受破坏。

Core-Cocktail 训练阶段 实验观察到,多模态模型训练过程中存在一个基础性的学习率折衷问题:学习率过高将导致 MLLM 性能退化,并加剧基础文本 LLM 知识的灾难性遗忘;而学习率过低则会导致收敛缓慢,甚至训练停滞。 为解决这一优化难题并避免知识流失,采用了此前在 DrVoice中提出的 Core-Cocktail Training 方法论 ,其核心是一种 两阶段训练策略 。

阶段一:高学习率微调。 在该初始阶段,我们对全部 MLLM 参数、Audio Encoder 与 Adapter 进行全量微调,并采用较高的学习率。对于 Fun-Audio-Chat,在阶段一中学习率按照余弦退火策略从 1×10−4 逐步衰减至 1×10−5 。该阶段的目标是使模型参数能够快速迁移至更有利于多模态学习的损失曲面区域,从而实现快速任务适配。

中间模型合并。 为缓解阶段一高强度训练可能带来的 MLLM 性能退化问题,引入中间模型合并操作。将阶段一训练后的 MLLM 参数 M1 与原始预训练 LLM 参数 M0 进行加权插值,得到合并模型: Mr ←αM1 +(1−α)M0

其中 α用于控制插值平衡。该合并过程重新引入基础 LLM 的核心知识,从而保护其原有的文本理解能力。较小的 α值将更有利于保留基础 LLM 的知识。在我们的实现中,α=0.5。

阶段二:低学习率精调。 在阶段二中,我们对合并后的模型 Mr 以更低的学习率进行全量微调。对于 Fun-Audio-Chat,学习率同样按余弦退火策略从 1×10−5 衰减至 1×10−6。该阶段实现了稳定且精细的优化,在避免高学习率相关不稳定性的同时进一步提升模型性能。Core-Cocktail Training 策略在快速适配与知识保持之间实现了有效平衡,显著缓解了灾难性遗忘问题,并促进高效的多模态学习。

多任务 DPO 训练

在完成 Core-Cocktail 训练之后,采用多任务 DPO 训练提升模型在真实语音数据上的鲁棒性、音频理解能力、语音指令遵循能力以及语音共情能力。多任务 DPO 阶段引入了多维度的偏好学习目标:(1)鲁棒性偏好 :更偏好在噪声环境或多样化语音输入下仍能保持输出质量的响应;(2)指令遵循偏好 :更偏好能够准确遵循语音指令(包括情绪、风格与韵律控制)的响应;(3)音频理解偏好 :更偏好体现对音频内容进行准确理解与推理的响应;(4)语音共情偏好 :更偏好能够展现恰当情绪理解与富有共情反馈的响应。DPO 训练损失在这些偏好维度上联合计算,从而使模型能够学习到一个在多种能力之间取得平衡的统一偏好信号。该多任务 DPO 训练阶段使模型能够更好地对齐人类偏好,并在真实世界会话场景中表现出更优性能,从而区别于主要依赖监督微调的既有工作。

全双工交互训练

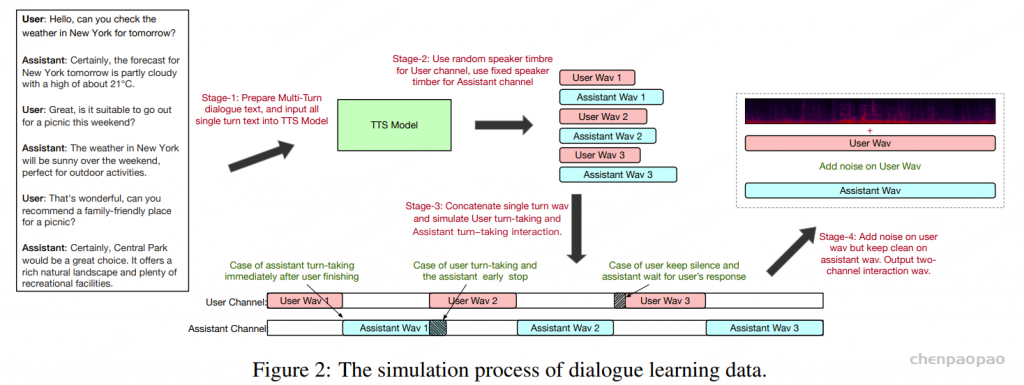

为实现实时全双工语音交互,提出并采用并行语音–文本输入流架构,并将 Fun-Audio-Chat 扩展为全双工变体 Fun-Audio-Chat-Duplex,从而支持自然、类人化的无缝双向通信。具体而言,并行语音–文本输入流允许模型在助手生成语音的同时继续接收用户语音输入,从而有效利用原本空闲的时间片。 该并行输入机制能够同时处理来自用户与助手的语音输入,使模型能够应对重叠语音片段并保持会话语境一致性。全双工交互训练从 Core-Cocktail 阶段得到的检查点继续训练 ,在其已具备的多模态能力基础上进一步强化。该阶段采用通过数据增强方式构造的全双工对话数据进行训练:即基于高质量半双工对话数据,并按照 OmniFlatten中的方法模拟全双工交互行为 ,将传统轮流发言的文本对话转化为并行双流式交互,其中用户与助手均可同时发声。 通过全双工训练,模型能够学习自然的轮次切换、打断处理与跟进反馈等交互行为。

OmniFlatten:https://aclanthology.org/2025.acl-long.709.pdf Experiments

评估任务和指标:

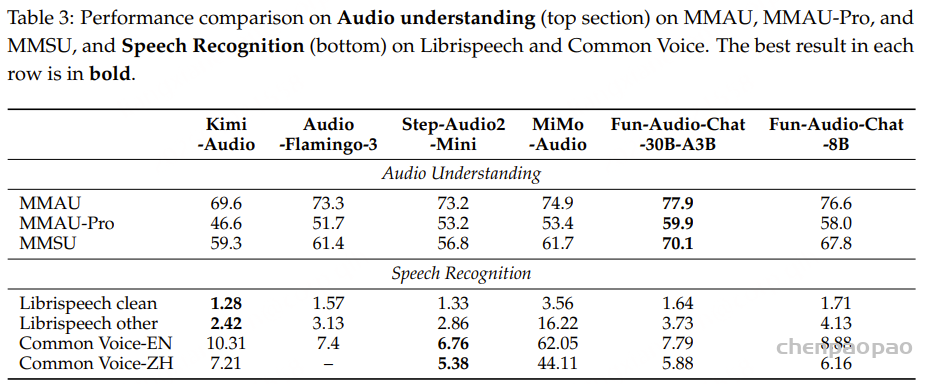

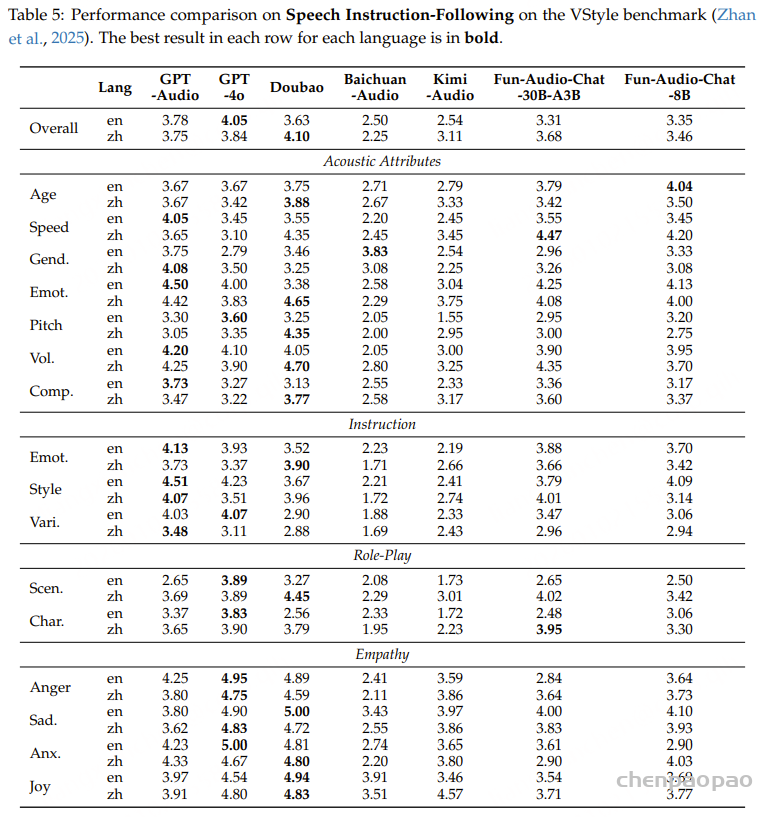

语音转文本 ( S→T) 评估。VoiceBench 、OpenAudioBench 两种类型的口语问答基准语音到语音 ( S→S) 评估。 UltraEval-Audio 用于端到端语音转语音问答评价。音频理解。 MMAU、MMAU-Pro 和 MMSU来评估综合音频理解能力。语音识别。 验证英语和普通话 (ZH) 性能语音功能调用。 Speech-ACEBench、Speech-BFCL 和 Speech-SmartInteract评估模型基于语音指令执行函数调用的能力。语音指令跟随和语音同理心。 VStyle 基准评估模型理解和执行语音指令的能力,以控制语音生成属性,如情绪、说话风格、速度、音调和音量。评估指标 :

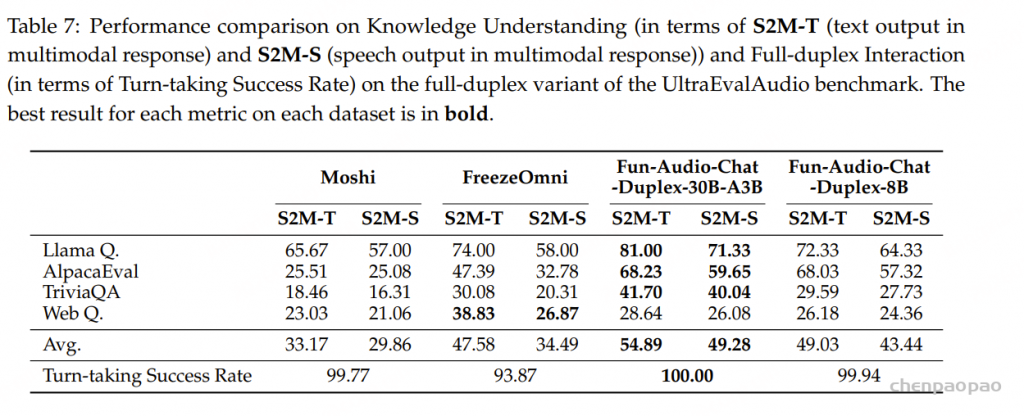

对于全双工交互评估 ,我们使用S2M-T (多模态响应中的文本输出准确性)和S2M-S (多模态响应中的语音输出准确性)来衡量知识理解性能,并使用轮流成功率 来衡量模型在全双工场景下正确处理轮流的交互百分比。

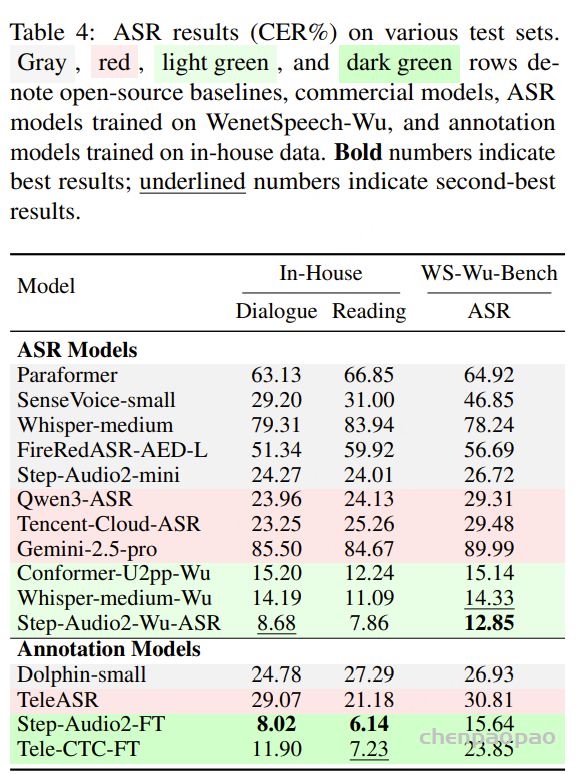

结果

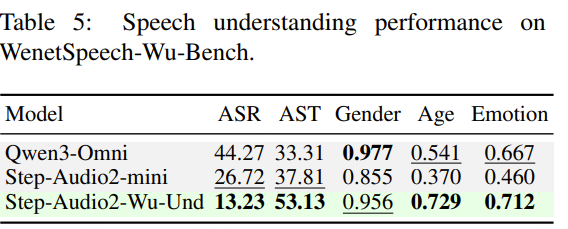

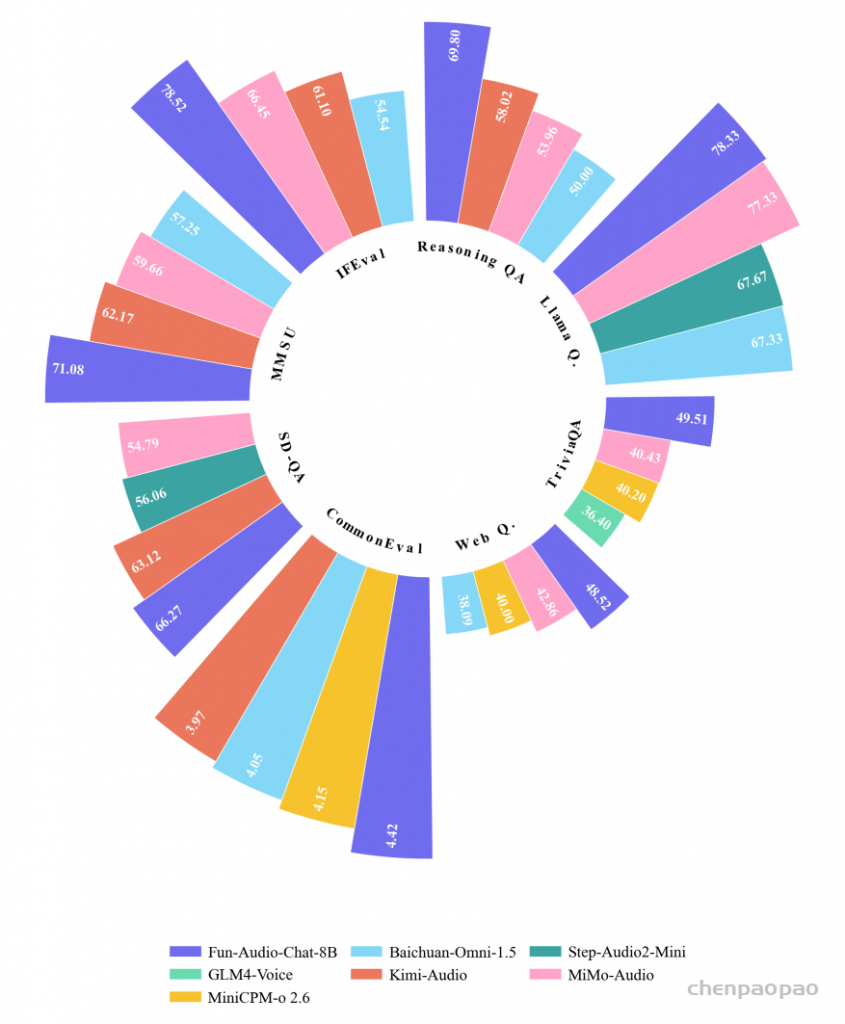

语音问答: Fun-Audio-Chat-8B 在 OpenAudioBench 上取得 76.61% 的整体最佳成绩,在 VoiceBench 上取得 83.21% 的整体最佳成绩,居于约 8B 规模模型中的领先水平;同时,Fun-Audio-Chat-30B-A3B 在与大规模基线模型(含顶级闭源模型)的比较中亦展现出具有竞争力的结果。

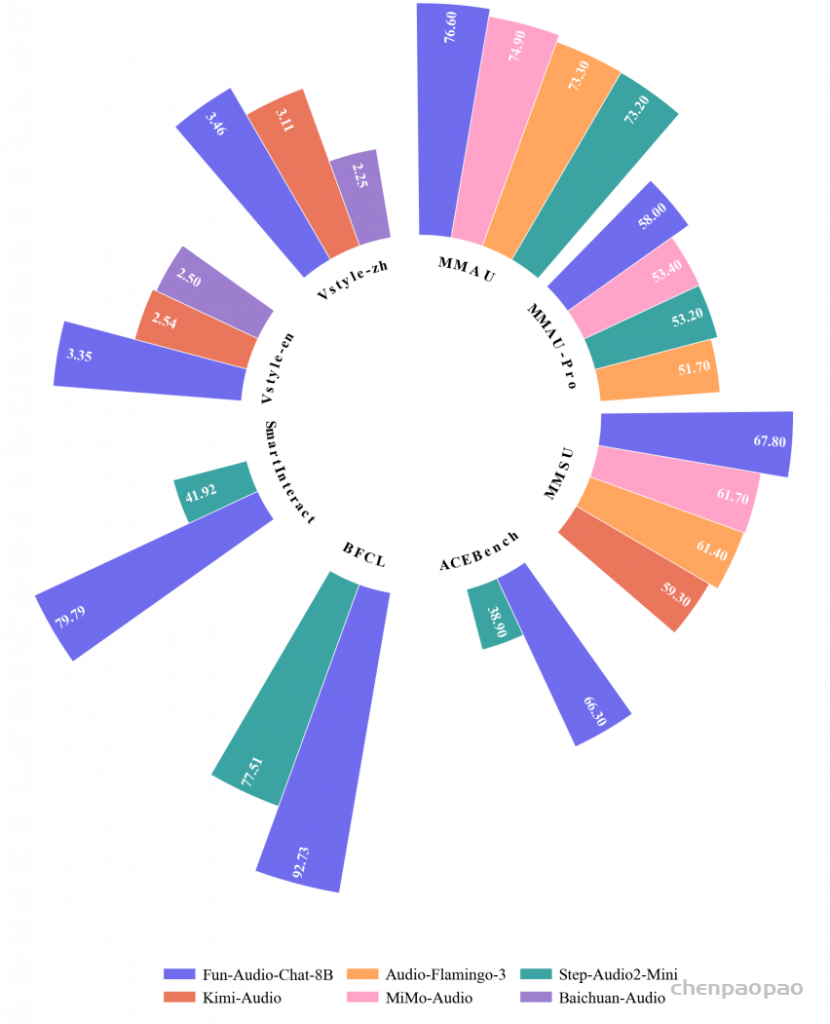

语音理解:Fun-Audio-Chat 在综合音频理解基准(包括 MMAU、MMAU-Pro 和 MMSU)上取得了最优表现,优于多种强大的开源基线模型

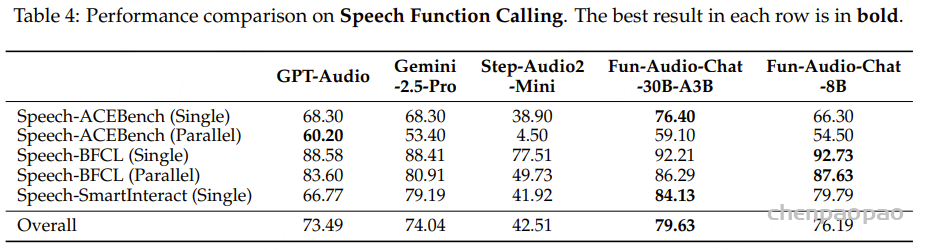

语音功能调用

Fun-Audio-Chat-30B-A3B 在所有评测模型中取得了最高的总体得分(79.63%),并在 Speech-ACEBench(单轮:76.40%)和 Speech-SmartInteract(84.13%)等任务上表现尤为突出。该模型在理解基于语音的函数调用指令并准确执行方面展现出强大能力,这对于构建实际可用的语音控制应用至关重要。 在并行函数调用场景中(Fun-Audio-Chat-8B 在 ACEBench-Parallel 上取得 54.50%,在 BFCL-Parallel 上取得 87.63%),结果进一步凸显了 Fun-Audio-Chat 在语音交互中处理复杂、多步骤指令的能力。

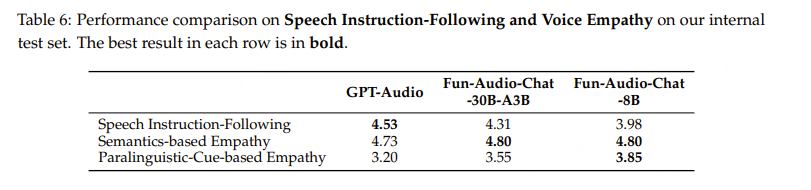

语音指令跟随和语音同理心

全双工交互

全双工知识理解。 表7展示了Fun-Audio-Chat-Duplex的全双工知识理解性能。 结果表明,Fun-Audio-Chat-Duplex 在全双工对话场景中保持了强大的知识理解能力 。全双工架构成功地保留了模型的知识理解能力,同时实现了同步双向通信,使系统即使在处理重叠的语音输入和输出时也能保持上下文和理解。

Fun-Audio-Chat-Duplex-30B-A3B 实现了完美的轮流成功率(100.00%),优于 Moshi(99.77%)和 FreezeOmni (93.87%)。 Fun-Audio-Chat-Duplex-8B 达到了 99.94%,也展现了出色的轮流能力。 这些结果表明,Fun-Audio-Chat-Duplex 成功实现了自然高效的全双工语音交互,该模型能够处理同时语音并保持适当的对话流程,密切反映了人与人对话的动态。

计算效率 :双分辨率设计显着降低了计算要求和潜在延迟,经验测量显示,与以更高帧速率运行的模型相比,训练期间的 GPU 时间减少了约 50% ,且不影响语音质量

限制

多轮对话中的复杂问题回答,该模型有时会表现出上下文记忆丢失,其中先前轮次的信息可能无法一致保留。

语音指令跟随能力在表达方面表现出一些不稳定。

语音共情能力表现出一定的不稳定。