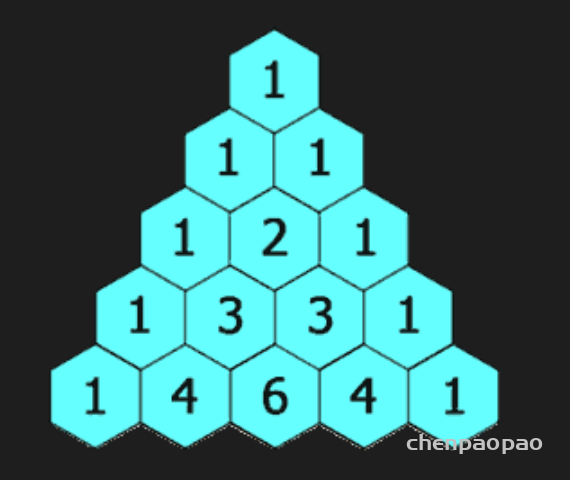

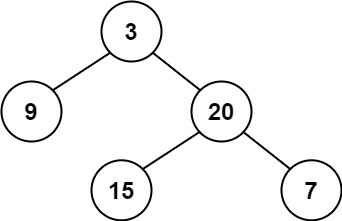

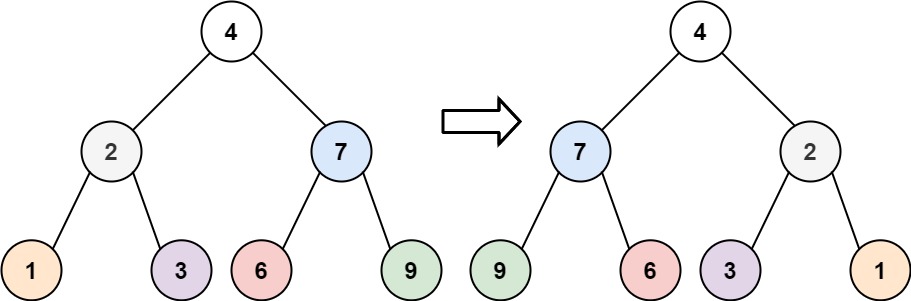

给定一个非负索引 rowIndex,返回「杨辉三角」的第 rowIndex行。

在「杨辉三角」中,每个数是它左上方和右上方的数的和。

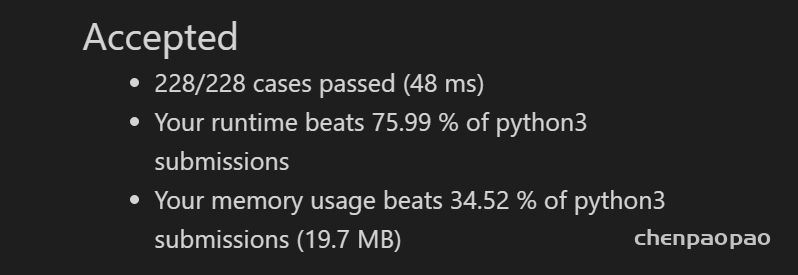

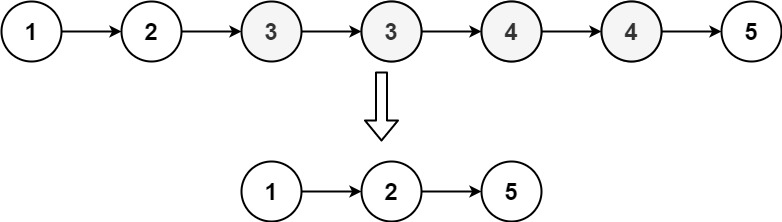

示例 1:

输入: rowIndex = 3

输出: [1,3,3,1]示例 2:

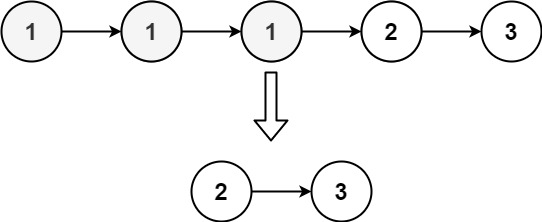

输入: rowIndex = 0

输出: [1]示例 3:

输入: rowIndex = 1

输出: [1,1]# @lc app=leetcode.cn id=119 lang=python3

#

# [119] 杨辉三角 II

#

# @lc code=start

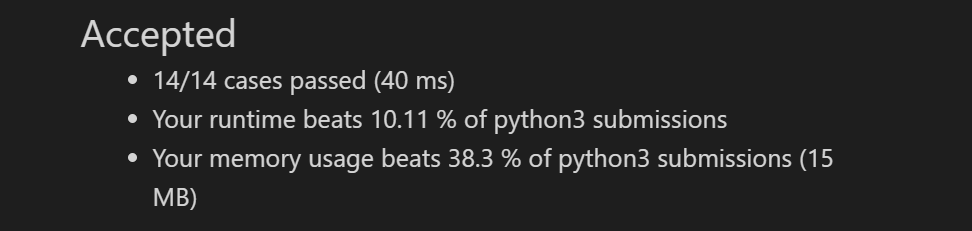

class Solution:

def getRow(self, rowIndex: int) -> List[int]:

nums=[]

for i in range(rowIndex+1):

if i==0:

nums=[1]

elif i==1:

nums=[1,1]

else:

m=list()

for j in range(len(nums)-1):

m.append(nums[j]+nums[j+1])

nums=[1]+m+[1]

return nums

# @lc code=end