- Github: https://github.com/QwenLM/Qwen3-ASR

- HuggingFace: https://huggingface.co/collections/Qwen/qwen3-asr

- ModelScope:https://www.modelscope.cn/collections/Qwen/Qwen3-ASR

- paper:https://github.com/QwenLM/Qwen3-ASR/blob/main/assets/Qwen3_ASR.pdf

Qwen3-ASR 是由Qwen开发的一系列功能强大的语音识别模型,包括两个强大且全面的语音识别模型 Qwen3-ASR-1.7B 与 Qwen3-ASR-0.6B,以及一个创新的语音强制对齐模型 Qwen3-ForcedAligner-0.6B。Qwen3-ASR 系列的语音识别模型支持 52 个语种与方言的语种识别与语音识别。

依托创新的预训练 AuT 语音编码器与 Qwen3-Omni 基座模型的强大多模态能力,Qwen3-ASR 实现了精准与稳定的语音识别,其 1.7B 模型在中文、英文、中文口音与歌唱识别等场景下达到 SOTA,具有复杂文本识别能力以及强噪声下的稳定性;0.6B 模型在性能与效率上实现了均衡,在保证语音识别准确率的情况下,128 并发异步服务推理能够达到 2000 倍吞吐,即 10 秒钟处理五个小时以上的音频。

强制对齐模型 Qwen3-ForcedAligner-0.6B 是基于 NAR LLM 推理的时间戳预测模型,支持 11 个语种的任意位置的灵活精准的强制对齐,其时间戳预测精度超越传统的 WhisperX,Nemo-Forced-Aligner 等模型,单并发推理 RTF 达到了高效的 0.0089。

Introduction

核心特性与贡献可概括如下:

-

实现一体化 ASR 与 LID 的最先进性能。

Qwen3-ASR-1.7B 与 Qwen3-ASR-0.6B 支持 30 种语言、22 种中文方言的自动语音识别,以及覆盖全球不同国家和地区的英语变体。这两款模型在复杂环境下同样具备鲁棒识别能力,包括但不限于歌唱语音与歌曲识别、噪声环境识别以及复杂文本模式(如混合语言、口语化表达等)的识别。 -

提出新型语音强制对齐架构。

首次引入了基于大语言模型的语音强制对齐器,可在灵活时间粒度下生成高精度时间戳,包括词级、句级和段落级。不同于现有工具(如 Montreal Forced Aligner, MFA 和 NeMo Forced Aligner, NFA),我们的 Qwen3-ForcedAligner-0.6B 提供统一的多语言解决方案,弥补了 Qwen3-ASR 系列中缺乏一体化强制对齐系统的不足,补全了综合口语语言处理体系中的关键功能模块。 -

开源模型与完整的推理及微调框架。

除发布三款模型权重外,我们还提供了一个完全开源、易于使用的代码框架,支持多种推理能力(如多粒度对齐、流式转写和多语言处理),并提供可复现的微调方案。我们希望这一统一工具链能够加速自动语音识别领域的研究与应用开发。

Qwen3-ASR

Architecture

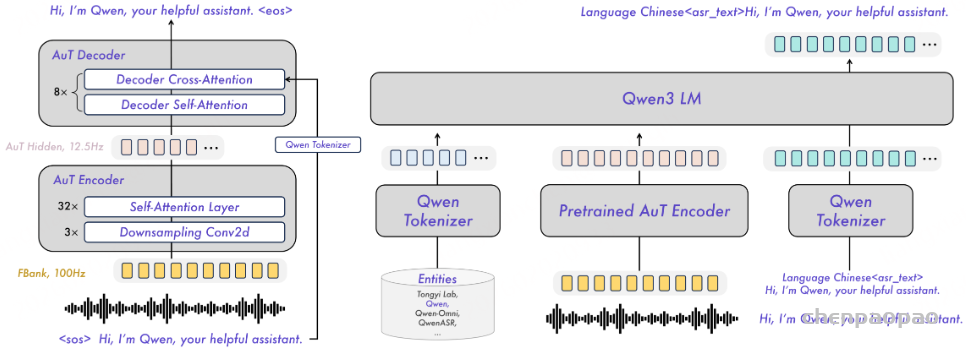

Qwen3-ASR 系列模型以 Qwen3-Omni 作为基础模型,该模型已被验证具备强大的音频理解能力。待识别语音首先输入至 AuT 编码器。AuT 编码器独立于 Qwen3-Omni 和 Qwen3-ASR 进行预训练。

如图 2(左)所示,AuT 是一种基于 Attention Encoder-Decoder (AED) 架构的 ASR 模型。其对 128 维 Fbank 特征进行 8 倍下采样,从而生成 12.5Hz token 率的音频表示。为兼顾流式与离线推理能力,我们采用 动态 Flash Attention 窗口机制,窗口大小在 1 秒至 8 秒之间自适应变化,使 Qwen3-ASR 既可处理短语音块进行流式推理,也可支持长语音的离线推理。

本次发布模型的整体架构如图 2(右)所示,具体如下:

-

Qwen3-ASR-1.7B

由 Qwen3-1.7B 主干模型、一个 projector 模块以及一个参数规模为 3 亿(300M)、隐藏维度为 1024 的 AuT 编码器构成。该模型在多语言及方言语音识别任务上表现突出,同时在复杂声学环境和复杂文本模式下具有较强鲁棒性。 -

Qwen3-ASR-0.6B

由 Qwen3-0.6B 主干模型、一个 projector 模块以及一个参数规模为 1.8 亿(180M)、隐藏维度为 896 的 AuT 编码器构成。该紧凑型模型在识别精度与推理效率之间取得良好平衡,在参数规模低于 10 亿的 ASR 模型中保持较强竞争力。

整体而言,该系列模型通过模块化音频编码器与大规模语言模型的融合,实现了高性能、多语言、可扩展的统一语音识别框架。

训练策略

Qwen3-ASR 的训练过程包括 AuT 预训练、Omni 预训练以及 ASR 后训练 三个阶段,其中前两个阶段与 Qwen3-Omni 完全一致。

(1)AuT 预训练

在该阶段,我们的目标是在 AED(Attention-based Encoder-Decoder)框架下,利用大规模标注数据训练一个预训练编码器。

我们使用了约 4000 万小时的伪标注 ASR 数据,其中大部分为中文和英文数据。实验表明,该预训练编码器在 动态注意力窗口大小 下能够提供通用且稳定的音频表示。

(2)Omni 预训练

我们以预训练好的 Qwen3-Omni 模型作为 ASR 训练的基础模型。

Omni 预训练在 多任务音频、视觉和文本数据 上进行。在该阶段,Qwen3-ASR-0.6B 和 Qwen3-ASR-1.7B 均使用 3 万亿 token 进行训练,从而获得多模态理解能力。

(3)ASR 监督微调(SFT)

在 SFT 阶段,我们对 ASR 的输入/输出格式进行风格迁移训练,所使用的数据规模显著小于预训练阶段,且与预训练语料不重叠。

除标准的中文、英文和多语种 ASR 数据外,SFT 阶段还使用了:

- 非语音数据

- 流式增强数据

- 上下文偏置数据

具体而言,我们将模型训练为一个 仅用于 ASR 的模型,不遵循 prompt 中的自然语言指令,从而缓解指令注入(instruction injection)和指令跟随失败的问题。

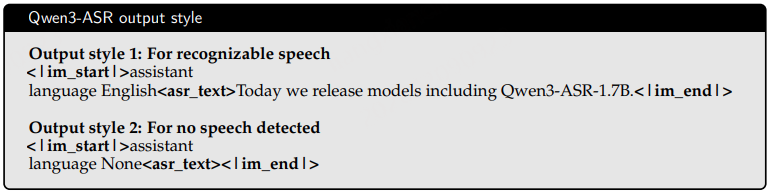

Qwen3-ASR 对给定音频的输出分为两种类型:

(4) ASR 强化学习(RL)

在最后阶段,我们采用 Group Sequence Policy Optimization(GSPO) 进一步提升识别质量。事实证明,强化学习在提升模型的抗噪声能力、转写稳定性以及处理复杂疑难语音的能力方面发挥了关键作用。

在强化学习阶段共使用约 5 万条语音数据,其中包括:

- 35% 的中英文数据

- 35% 的多语言数据

- 30% 的功能性数据

该阶段的目标是在复杂环境下提升转写的稳定性。

特点

基于上述架构与训练策略,Qwen3-ASR 系列模型在以下方面表现突出:

(1)高精度中英文识别。

在各个训练阶段中,中英文数据占据了训练数据的主要比例。与众多竞争系统相比,该模型在多个基准测试中取得了领先的中英文识别性能。

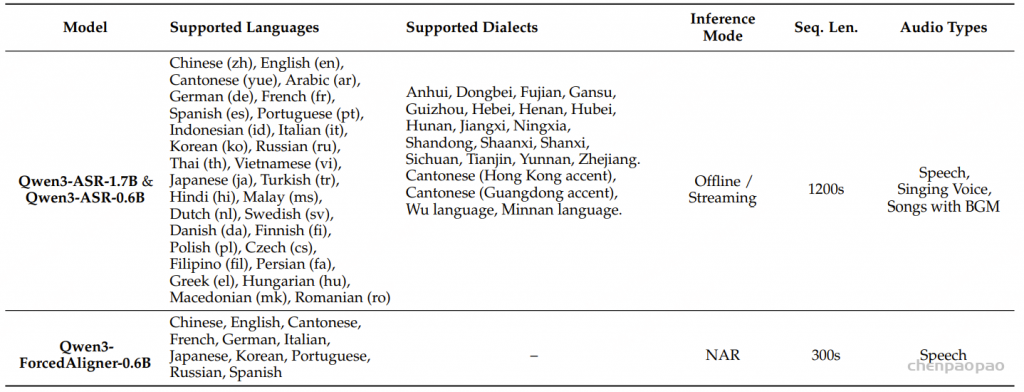

(2)支持多语言与多方言。

Qwen3-ASR-1.7B 和 Qwen3-ASR-0.6B 支持 30 种语言和 22 种方言,详见表 1。

(3)长音频与流式推理能力。

Qwen3-ASR-1.7B 和 Qwen3-ASR-0.6B 原生支持最长不超过 20 分钟的单段语音输入,并支持流式与离线统一推理。

(4)歌声与歌曲识别能力。

Qwen3-ASR-1.7B 和 Qwen3-ASR-0.6B 能够准确识别歌声与歌曲内容。除具备较强的歌声识别能力外,Qwen3-ASR 系列还支持在含有背景音乐(BGM)的情况下直接转写完整歌曲,体现出对伴奏和复杂音乐混合场景的鲁棒性。

推理效率

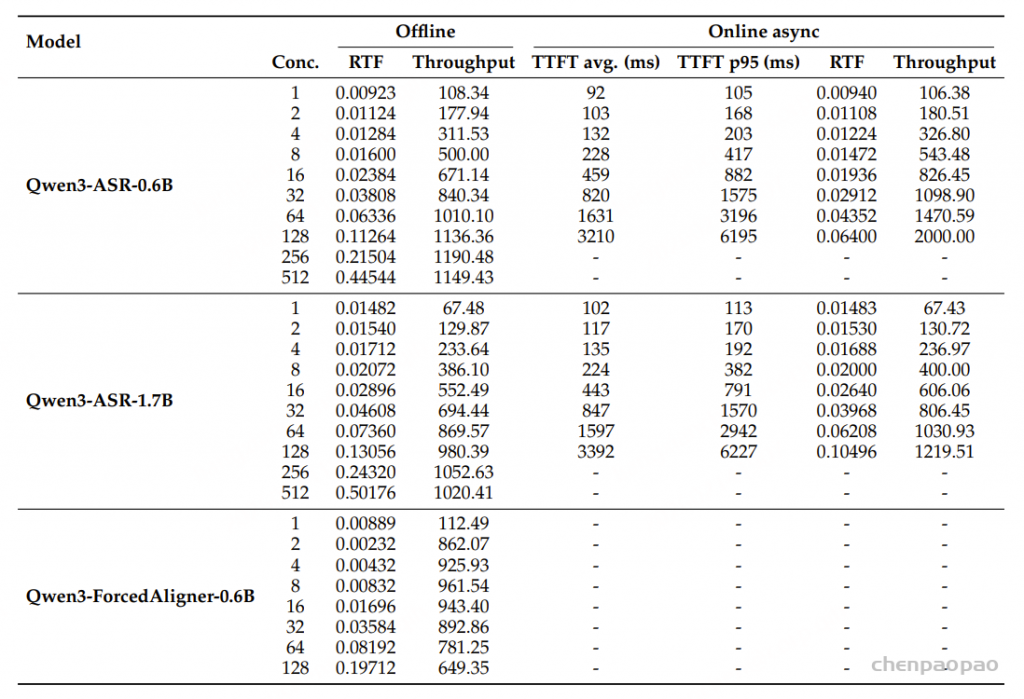

Qwen3-ASR 的速度基准测试在两种场景下进行:离线批量推理和在线异步推理。

- 前者通过 vLLM 的离线批量生成方式进行评估;

- 后者基于 vLLM Serve 的多并发请求设置进行评估,更贴近工业环境中的实际推理效率表现。

所有实验均基于 vLLM v0.14.0 运行,启用了 CUDA Graph,并采用 bfloat16 精度进行推理。表 2 的结果显示,在不同并发水平下,Qwen3-ASR-0.6B 的平均首 Token 延迟(Time-to-First-Token, TTFT)最低可达 92 毫秒。

在并发数为 128 时:

- 实时因子(Real-Time Factor, RTF)最低可达 0.064

- 吞吐量最高可达 2000

这意味着该模型每秒可以处理 2000 秒的音频。

Qwen3-ForcedAligner

Overview

Qwen3-ForcedAligner-0.6B 旨在在已知对应文本转写的情况下,估计语音中每个单词或字符的起始和结束时间戳。该模型将强制对齐(Forced Alignment)任务重构为一种槽位填充(slot-filling)形式。具体而言,在输入语音及其转写文本的基础上,在文本中插入特殊标记 [time],用于表示词级或字符级的起止时间槽位。随后,Qwen3-ForcedAligner-0.6B 直接预测每个槽位对应的离散时间戳索引。

表 2: Qwen3-ASR 系列模型的效率。Qwen3-ASR-0.6B 和 Qwen3-ASR-1.7B 支持基于 vLLM 的离线批处理和在线异步推理模式,而 Qwen3-ForcedAligner-0.6B 仅支持 PyTorch 下的离线批处理推理。表中所有测量结果均基于时长约为 2 分钟(ASR)和 1 分钟(FA)的输入音频,所有推理均在单个典型计算资源上执行。Conc. 表示并发级别。TTFT p95 表示第 95 百分位 TTFT 延迟。

高精度时间戳预测

Qwen3-ForcedAligner-0.6B 在时间戳预测偏移方面显著降低误差。与其他强制对齐方法相比,在人工标注测试数据集上,其累计平均时间偏移实现了 67%~77% 的相对下降。

广泛的应用场景

Qwen3-ForcedAligner-0.6B 支持 11 种语言 的语音输入,最长可达 300 秒,包括跨语言场景。同时,用户可以灵活地对任意单词或字符进行时间戳预测定制。

快速推理速度

Qwen3-ForcedAligner-0.6B 摒弃了传统的“下一个 Token 预测”范式,采用非自回归(NAR)推理方式进行时间戳预测,从而显著提升推理效率。

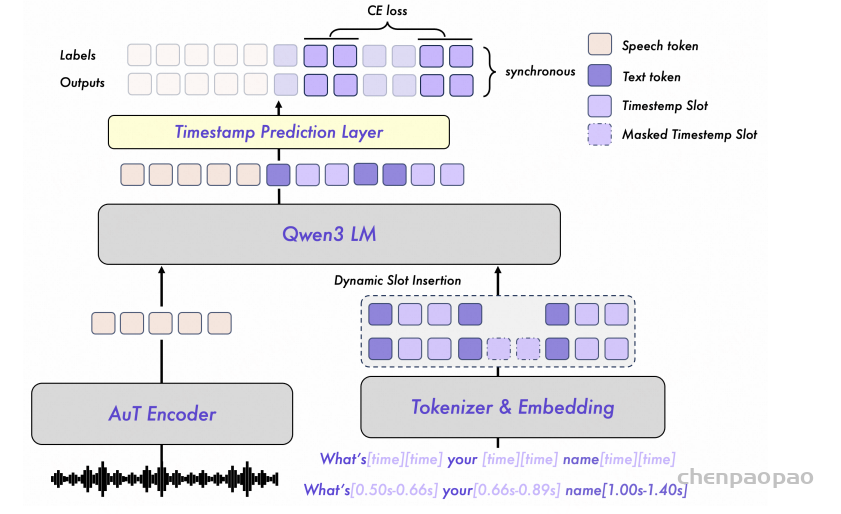

模型设计

如图 3 所示,Qwen3-ForcedAligner-0.6B 采用一个预训练的 AuT 编码器(AuT encoder) 来处理输入语音信号,并生成语音嵌入表示(speech embeddings)。转写文本会被重新格式化:为每个单词或字符添加起始和结束时间戳标签。随后,每个时间戳标签都会被替换为特殊标记 [time],并输入到分词器(tokenizer)中。此外,文本中的时间戳标签会通过将时间戳数值除以 AuT 编码器输出的 80ms 帧时长进行离散化,转换为对应的时间索引。

语音和文本的嵌入序列随后一起输入到 Qwen3-0.6B 大语言模型(LLM) 中处理,之后通过一个时间戳预测线性层,对整个输入序列的时间戳索引进行预测。

在本工作中,时间戳预测的最大类别数为 3750,对应支持最长 300 秒的语音输入。

在训练阶段,会将随机掩蔽的时间戳槽位动态插入到 token 序列中,用以表示单词或字符的边界。随后,将组合后的序列输入到 Qwen3-0.6B 大语言模型(LLM) 中,并通过时间戳预测层为每个槽位预测对应的时间戳索引。在监督训练过程中,对同步对齐的标签序列与模型输出序列之间计算交叉熵损失(cross-entropy loss)。

训练策略

训练 Qwen3-ForcedAligner-0.6B 需要大量带有词级或字符级时间戳标注的语音–文本对。然而,由于人工标注成本极高,本文采用 Montreal Forced Aligner(MFA)生成的伪时间戳标签。MFA 是当前最准确的强制对齐方法之一。

需要注意的是,MFA 生成的伪标签天然包含噪声和系统性偏移。Qwen3-ForcedAligner 并非简单复现 MFA 的输出,而是对这些伪标签进行蒸馏与平滑,从而获得更稳定、时间偏移更小的时间戳预测结果。

传统的大语言模型(LALMs)通常采用一种训练方案:移除输出序列的最后一个 token 以及标签序列的第一个 token,在两者之间引入一个位置偏移,并基于此计算交叉熵损失,从而实现标准的“下一个 token 预测”范式。然而,该范式并不适用于时间戳槽位的填充任务。

Qwen3-ForcedAligner-0.6B 采用因果训练(causal training)方式,保持输出序列与标签序列不做位置偏移。这样,模型在训练过程中可以显式地识别时间戳槽位,并直接预测用于填充这些槽位的时间戳索引。

此外,因果训练使 Qwen3-ForcedAligner-0.6B 在预测当前时间戳槽位时能够利用之前的上下文信息,从而保证整体时间戳预测的全局一致性。交叉熵损失仅在时间戳槽位上计算,使训练目标专注于时间戳槽位填充这一核心任务。

此外,为了增强模型的泛化能力,Qwen3-ForcedAligner-0.6B 在训练过程中采用了动态槽位插入策略。具体而言,对于样本中的每个单词或字符,模型会随机决定是否在其后插入起始和结束时间戳槽位。

推理与可用性

由于训练过程中 token 序列保持未偏移(non-shifted),用户可以在任意单词或字符之后插入起始和结束时间戳槽位。Qwen3-ForcedAligner-0.6B 使用非自回归(NAR)解码,能够一次性同时预测文本中所有时间戳槽位对应的时间索引。

当获得时间索引后,将每个索引乘以 80ms,即可恢复出实际预测的时间戳。

Qwen3-ForcedAligner 的速度基准测试基于 FlashAttention 和 bfloat16 进行。由于该模型是非自回归的,Transformers 与 vLLM 在推理速度上的差异相对较小,因此所有基准测试均使用 Transformers 进行。表 2 的结果表明,即使在高并发场景下,该模型仍能保持接近 0.001 的实时率(RTF),也就是说,它可以每秒处理 1,000 秒的音频。

Experiments

评估细节

基线系统

为验证 Qwen3-ASR 系列模型的性能,我们将其与当前最先进(SOTA)的闭源 ASR API 以及广泛使用的开源模型进行对比评估。具体而言,我们将 Qwen3-ASR 与三种领先的专有服务进行比较:

- OpenAI 的 GPT-4o-Transcribe

- Google DeepMind 的 Gemini 2.5 Pro

- ByteDance 的 Doubao-ASR

此外,我们还纳入了多个多语言开源基线模型:

- Whisper-large-v3

- FunASR-MLT-Nano

- GLM-ASR-Nano

这些基线系统涵盖了强大的商业系统以及具有竞争力的开源替代方案,从而能够在具有代表性的真实场景下对 Qwen3-ASR 进行全面评估。

采用四部分评估协议来衡量 Qwen3-ASR 系列模型的语音识别性能:

- 公共基准测试(英语与中文)

- 内部鲁棒性测试套件:全面的内部测试集,在具有挑战性的真实场景下对模型进行压力测试

- 多语言评估

- 歌声识别:重点关注长音频场景,即将整首歌曲作为单一输入

评估指标

- 识别准确率:CER/WER

- 语种识别准确率

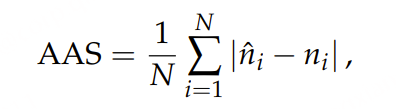

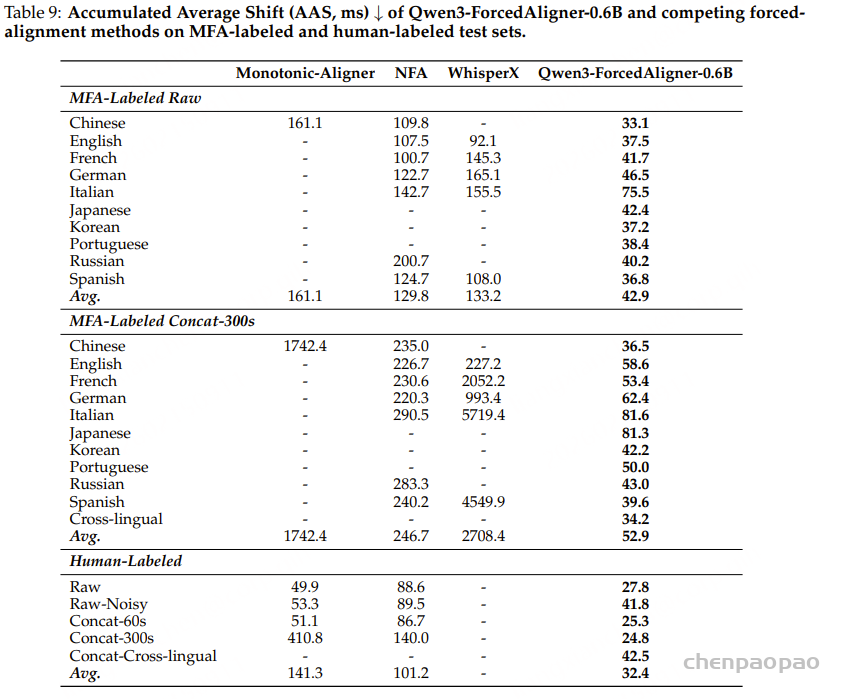

- 时间戳精度:使用 Accumulated Average Shift(AAS)作为评估指标。AAS 数值越低表示时间戳预测越准确。预测时间戳与参考时间戳之间的平均绝对差值:

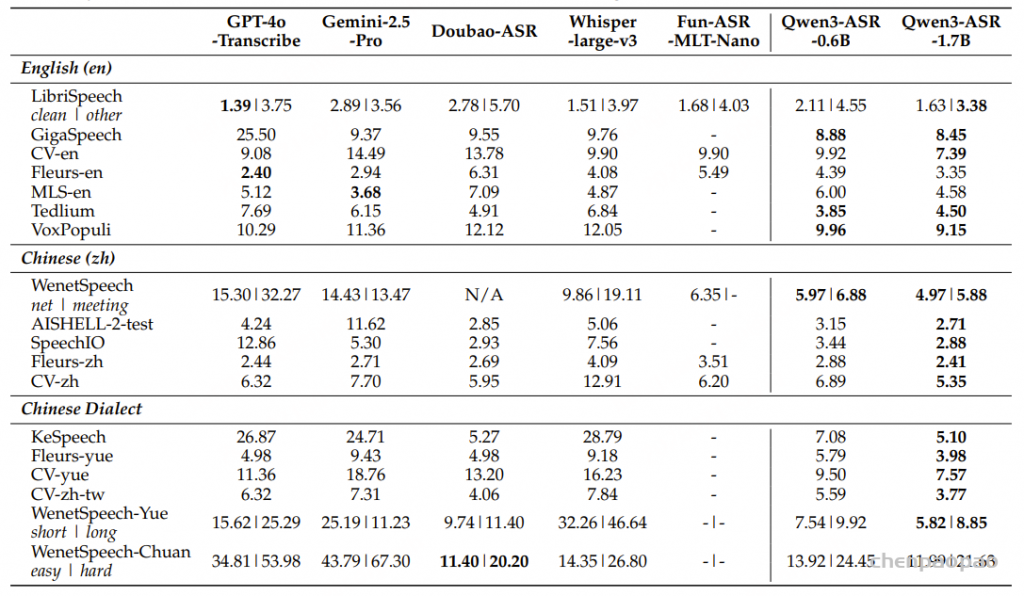

English & Chinese ASR Performance

Opensource ASR Benchmarks

Qwen3-ASR 在英语、普通话和多种汉语方言基准测试中均表现出色。它不仅能与领先的商业 API 相媲美,而且性能远超广泛使用的开源基线模型。从 Qwen3-ASR-0.6B 扩展到 Qwen3-ASR-1.7B,性能提升显著且稳定,表明该模型能够有效受益于容量的增加。

在英语基准测试上,Qwen3-ASR 在多样化的真实场景数据(例如众包或网络采集语音)上表现尤为出色。这类数据相比朗读式语音(read-speech)通常存在更明显的分布偏移。在这些情况下,Qwen3-ASR-1.7B 在多个数据集上取得了整体最佳成绩,同时在诸如 LibriSpeech 等标准学术评测中也保持接近最优系统的表现。相比之下,一些商业 API 的性能在不同数据集之间波动较大,而 Qwen3-ASR 在广泛的英语场景下展现出更为稳定和一致的识别准确率。

在普通话基准上,Qwen3-ASR 展现出明显优势。它在表中大多数普通话评测数据集上取得了最佳整体表现,并在更具挑战性的大规模评测中依然保持稳定性能。尤其是在 WenetSpeech 数据集上(该数据集包含多样化声学环境和会议场景语音),Qwen3-ASR 相比现有基线模型取得了显著领先。

在中文方言基准上,Qwen3-ASR 在存在显著发音和词汇差异的情况下仍保持较强的识别精度。在粤语及其他方言数据集中,它始终位列表现最优的系统之一,并且在更具挑战性的长语句场景下表现尤为突出,体现出超越短句、干净测试条件的鲁棒性。尽管在少数特定方言场景中,一些专门优化的商业 API 略占优势,但总体而言,Qwen3-ASR 依然具有很强竞争力,能够在无需针对每种方言单独定制的情况下提供通用且高性能的解决方案。

总体而言,表 3 总结了 Qwen3-ASR 的三大优势:

- 在英语基准上具备强大的跨领域泛化能力,尤其是在超越精心筛选的朗读语音场景下表现突出;

- 在普通话多个公开数据集(包括大规模、噪声较多的会议语音)上达到当前最先进水平;

- 在中文方言处理方面表现稳健,尤其是在粤语以及长短语句混合的方言语音上具有显著优势。

这些结果表明,Qwen3-ASR 在多样化的公开基准测试中展现出强大且可复现的性能,同时在与顶级闭源商业 API 的对比中也保持了高度竞争力。

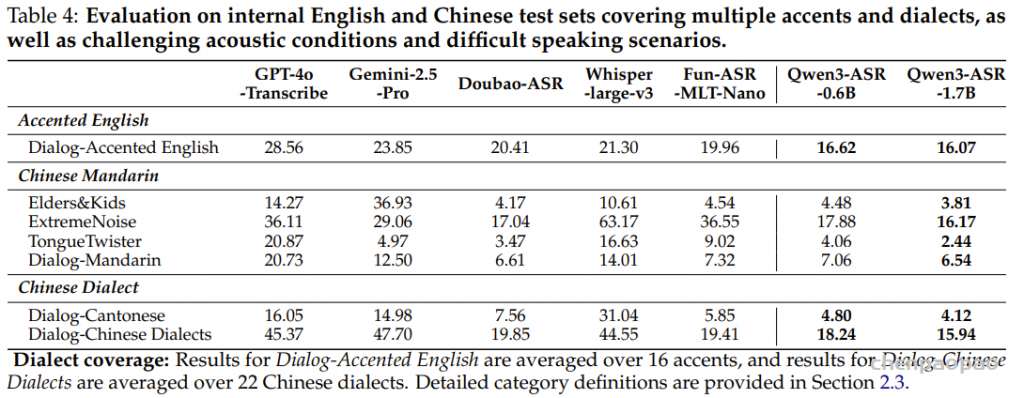

内部 ASR 基准测试

为进一步评估模型在真实部署环境下的鲁棒性,我们在内部鲁棒性测试套件上对 Qwen3-ASR 进行了评测,结果汇总于表 4。Qwen3-ASR 在所有子集上均表现出稳定而强劲的性能,并且从 0.6B 扩展至 1.7B 带来了持续且稳定的性能提升。

在带口音英语评测中,Qwen3-ASR 取得了所有对比系统中最低的词错误率(WER),优于商业 API 和开源基线模型,表明其对口音变化具有更强的泛化能力。在普通话评测中,Qwen3-ASR-1.7B 在所有测试子集上均取得最佳表现,展现出在复杂声学环境和多样说话条件下的鲁棒性。

在中文方言评测中,Qwen3-ASR 同样在粤语对话测试和 22 种方言汇总评测中取得最佳结果;尤其是在多方言混合场景下,性能提升更加显著,表明随着语言多样性的增加,模型的鲁棒性进一步增强。

总体而言,这些内部评测结果与公开基准测试的结论一致,进一步验证了 Qwen3-ASR 在高变异性场景下能够提供稳定且可靠的识别质量。

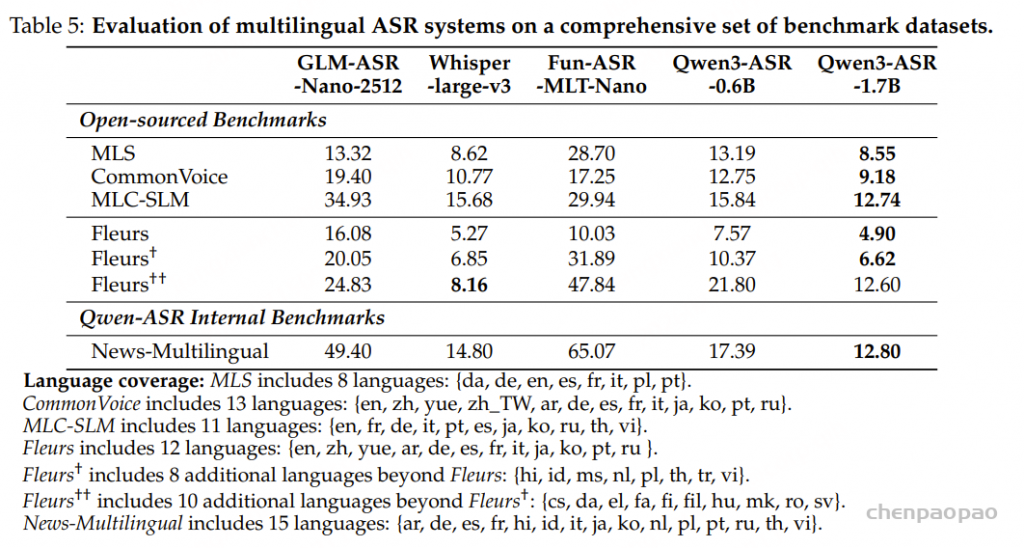

Multilingual ASR and Language Identification

多语言自动语音识别性能

总体而言,Qwen3-ASR-1.7B 在大多数测试设置中取得了最佳的平均性能,展现出强大的跨语言和跨领域的泛化能力,而 Qwen3-ASR-0.6B 则提供了一个具有竞争力的轻量级替代方案。

在 MLS、Common Voice 和 MLC-SLM 基准测试中,Qwen3-ASR-1.7B 的性能始终优于所有评估的开源基线模型,包括广泛使用的 Whisper-large-v3,并且显著优于规模较小的多语言模型。对于涵盖更多语言和多样化录音条件的 Fleurs 数据集,Qwen3-ASR-1.7B 在 12 种和 20 种语言的子集上取得了最佳性能。然而,相对于 Whisper-large-v3,其在完整的 30 种语言设置下的性能有所下降,表明其在处理日益增长的语言多样性和长尾语言方面仍有改进空间。尽管如此,Qwen3-ASR-1.7B 仍然明显优于 0.6B 版本,这表明模型扩展能够提高其在更具挑战性的多语言环境下的鲁棒性。

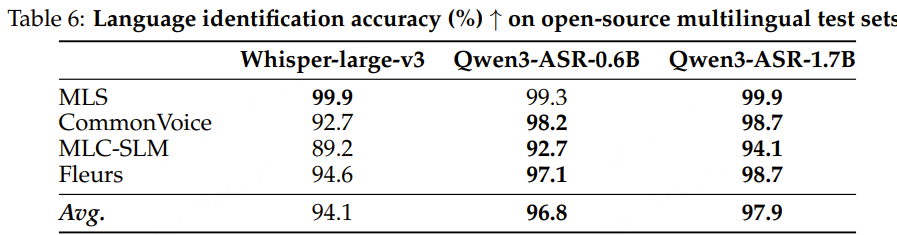

Language Identification Performance

Qwen3-ASR 不仅能够将语音解码为文本,还可以在进行 ASR 解码之前,通过自然语言提示完成语言识别(LID)。在本节中,我们在 4 个多语言基准数据集上评估语言识别准确率:

- FLEURS(30 种语言)

- MLS(9 种语言)

- Common Voice(13 种语言)

- MLC-SLM(11 种语言)

各数据集所覆盖的语言种类详见第 2.3 节。

如表 6 所示,我们将 Qwen3-ASR-0.6B 和 Qwen3-ASR-1.7B 与 Whisper-large-v3 进行对比。Whisper-large-v3 是一个具备内置语言识别能力的强大多语言 ASR 模型。实验结果表明,两种 Qwen3-ASR 模型均优于 Whisper-large-v3,在这些主流语言上展现出稳定而有效的语言识别能力。

在 FLEURS 数据集上的剩余错误主要来源于对马来语(ms)和印尼语(id)的混淆。这两种语言在语言学上高度接近,且在声学特征上具有较高相似性,因此较易产生识别混淆。

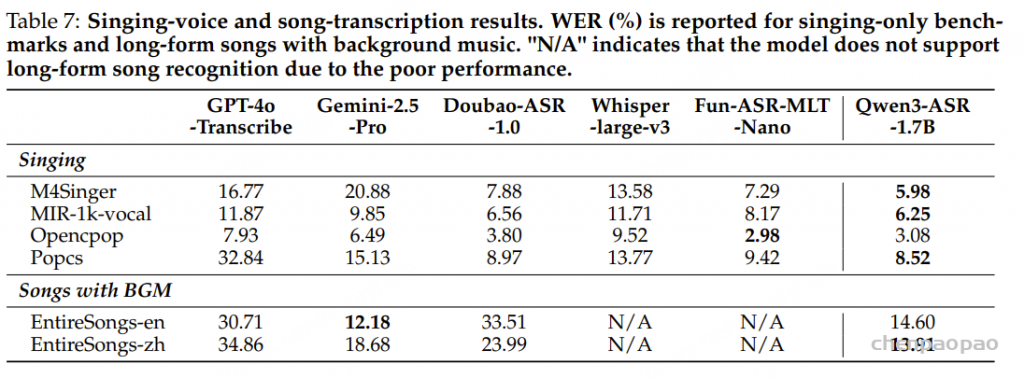

Singing Voice & Songs Recognition Performance

表 7 汇报了歌声转写以及带背景音乐的长时歌曲转写结果。总体来看,Qwen3-ASR-1.7B 在面对旋律引起的发音变化和音乐伴奏干扰时表现出较强的鲁棒性,在所评测的数据集上优于大多数商业 API 和开源基线模型。

在纯歌声(无伴奏)基准上,Qwen3-ASR-1.7B 在以下数据集上取得最佳表现:

- M4Singer

- MIR-1k

- PopCS

在 OpenCpop 上,其表现略低于 FunASR-MLT-Nano,位列第二,但差距较小。这表明模型在不同演唱风格和录音条件下具有较强的泛化能力,并且对音高漂移、音素拉长以及节奏变化等歌声特有现象的敏感性较低。

在包含背景音乐的完整歌曲转写任务中,Qwen3-ASR-1.7B 显著优于开源基线模型;Whisper-large-v3 和 FunASR-MLT-Nano 在长时、音乐混合场景下性能明显下降。Qwen3-ASR-1.7B 在英语和中文歌曲上都取得了较高准确率:在中文数据集上排名第一,在英语数据集上也与表现最佳的商业系统保持竞争力。

这些结果表明,Qwen3-ASR 在真实含音乐场景下具有良好的适应能力,对背景音乐干扰具有较强鲁棒性,并在一定程度上缩小了传统语音识别与歌声/歌曲转写之间的性能差距。

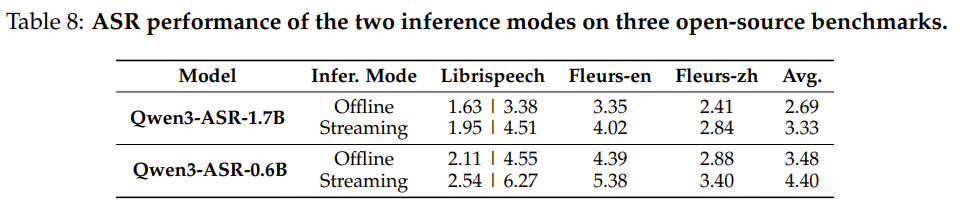

Streaming Speech Recognition

本节在离线(offline)和流式(streaming)两种推理模式下评估 Qwen3-ASR-1.7B 和 Qwen3-ASR-0.6B 的性能。得益于动态注意力窗口机制,Qwen3-ASR 系列模型能够自然支持流式推理。

表 8 展示了在三个开源测试集上的评测结果,实验设置为:分块大小为 2 秒、5 个 token 回退(fallback),并保持最近 4 个分块处于未固定(unfixed)状态。

总体而言,Qwen3-ASR 提供了一个同时适用于离线与流式场景的统一模型架构,并且在流式推理模式下仍然保持了较强的识别准确率。

Precision of Timestamps

表 9 报告了 Qwen3-ForcedAligner-0.6B 与其他强制对齐(forced-alignment)方法在 MFA 标注和人工标注测试集上的 累积平均偏移(AAS, Accumulated Average Shift) 表现。

主要结论如下:

-

多语言覆盖与跨语言能力

- 其他方法通常需要特定语言模型,支持语言数量有限。

- Qwen3-ForcedAligner-0.6B 通过单一模型覆盖多种语言,并能处理跨语言和混合语言(code-switched)场景。

-

长短语音表现稳定

- Qwen3-ForcedAligner-0.6B 对短句和长句均表现一致。

- 基线方法在长句或长语音上,时间戳预测准确度显著下降。

-

训练来源与泛化能力

- 虽然模型使用 MFA 伪标注训练,但在人工标注的测试集上依然保持较低的 AAS。

- 表明模型具有 强大的实际场景泛化能力,能够稳健预测各类语音的时间戳。

简单总结:Qwen3-ForcedAligner-0.6B 在多语言、长语音及真实数据上的时间戳预测都优于传统方法。

结论

本文介绍了 Qwen3-ASR 模型家族,包括两款自动语音识别(ASR)系统和一款强制对齐(FA, Forced Alignment)模型,这些模型均在大规模语音语料上训练得到。

核心特点与贡献如下:

-

性能与训练策略

- 利用基础模型 Qwen3-Omni 的强大音频理解能力,以及四阶段训练流程,

Qwen3-ASR-1.7B 和 Qwen3-ASR-0.6B 在语音覆盖率和识别准确率上,均优于同等规模或更大规模的竞品模型及商业 API。

- 利用基础模型 Qwen3-Omni 的强大音频理解能力,以及四阶段训练流程,

-

多语言与语音场景支持

- 支持 30 种语言的语言识别(LID)和语音识别(ASR)。

- 在复杂声学环境下表现稳健,对口音与方言具备鲁棒性。

- 对唱歌语音及其他真实场景语音同样有效。

-

强制对齐模型

- 引入 Qwen3-ForcedAligner-0.6B,基于 LLM 的非自回归(NAR)时间戳预测器,

支持 11 种语言的强制对齐,端到端处理时间低于 5 分钟。 - 在时间戳准确率、推理速度和语言覆盖方面,均优于三种主流端到端 ASR 基础的 FA 方案。

- 引入 Qwen3-ForcedAligner-0.6B,基于 LLM 的非自回归(NAR)时间戳预测器,

-

开源与易用性

- 发布了三款模型权重,同时开源了统一、易用的推理框架。

总结:Qwen3-ASR 家族在真实场景评测和公开基准测试中均达到 最先进水平,而开源的强制对齐模型解决了语音技术栈中的关键空白。团队将持续提升该开源模型家族的准确性与功能性。