https://funaudiollm.github.io/ [阿里团队] arxiv.org/abs/2407.04051

[Paper] [Code] [Modelscope:SenseVoiceCosyVoice] [HuggingFace: SenseVoice]

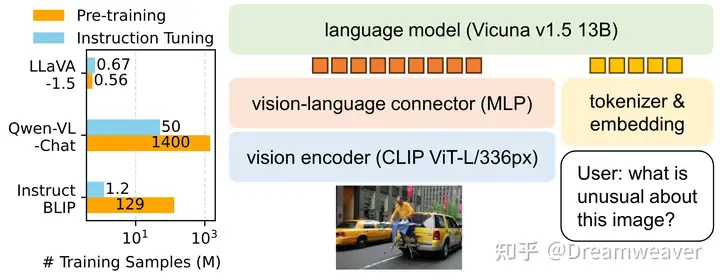

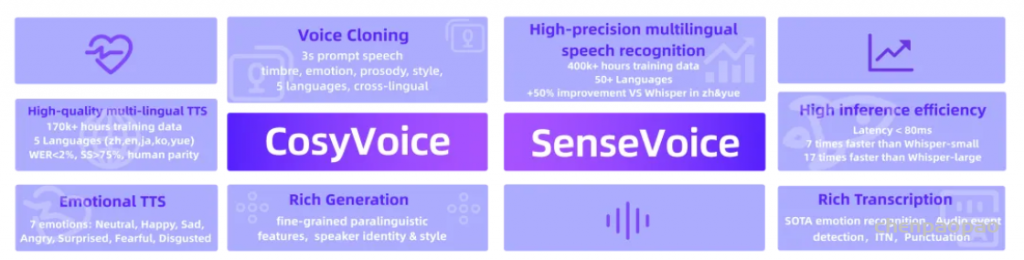

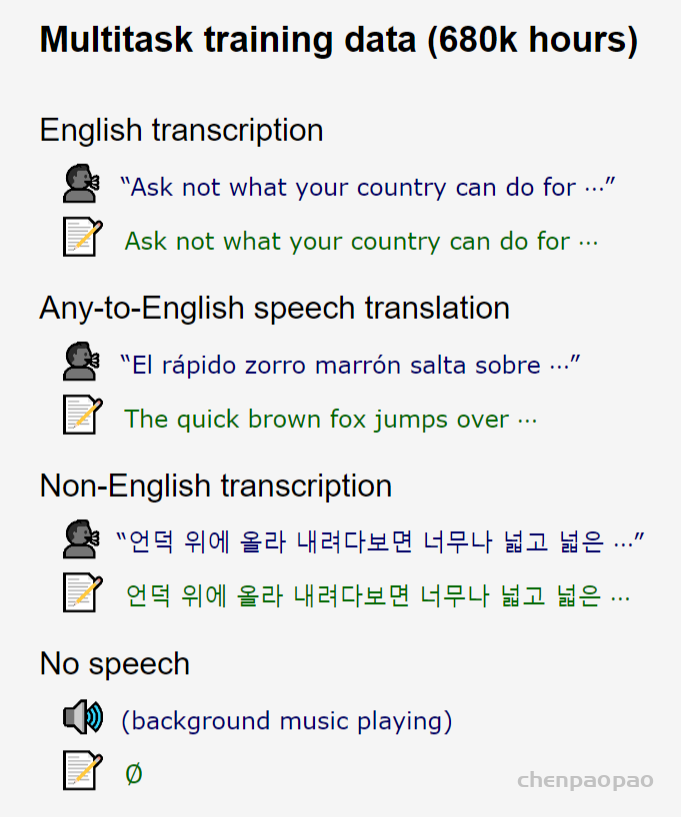

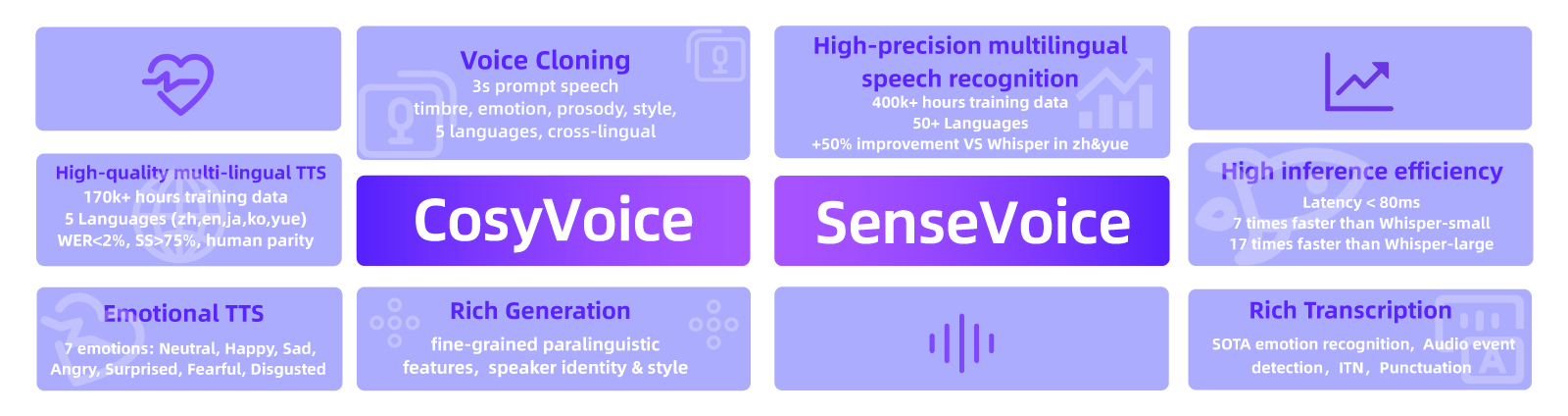

我们介绍FunAudioLLM,本报告介绍了FunAudioLLM,这是一个旨在增强人类与大型语言模型之间的自然语音交互的框架(LLMs)。其核心是两个创新模型:SenseVoice用于高精度多语言语音识别,情感识别和音频事件检测;CosyVoice用于多语言,音色和情感控制的自然语音生成。SenseVoice具有极低的延迟并支持50多种语言,而CosyVoice在多语言语音生成、零触发语音生成、跨语言语音克隆和指令遵循功能方面表现出色。与SenseVoice和CosyVoice相关的模型已经在Modelscope和Huggingface上开源,沿着相应的训练,推理和微调代码发布在GitHub上。 通过将这些模型与LLMs集成,FunAudioLLM可以实现语音翻译、情感语音聊天、交互式播客和富有表现力的有声读物叙述等应用,从而推动语音交互技术的发展。

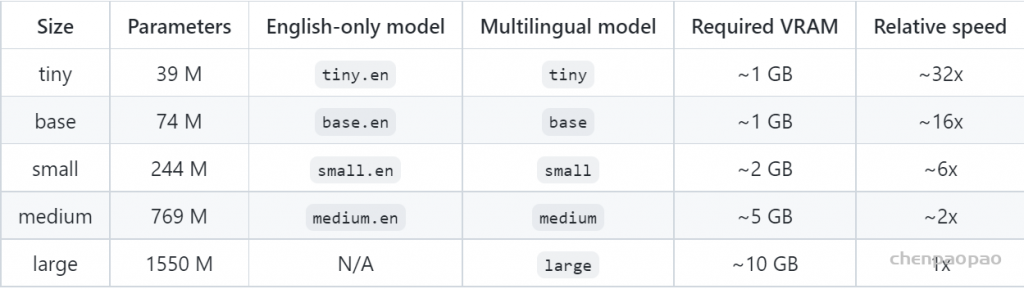

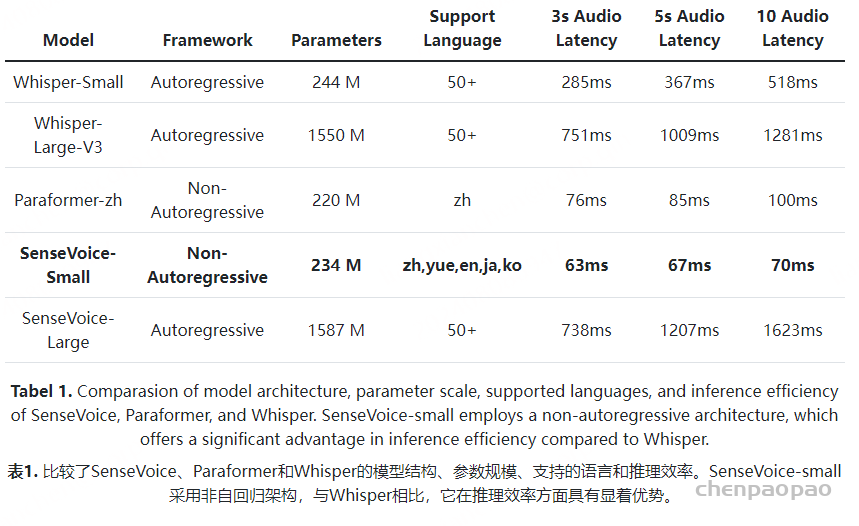

SenseVoice支持多语言语音识别,其训练时间超过30万小时。具体来说,SenseVoice-Small在推理方面非常高效,其中识别延迟小于80 ms,分别比Whisper-Small和Whisper-large快5倍和15倍以上,SenseVoice-Large支持50多种语言的高精度ASR。此外,SenseVoice支持丰富的转录,包括最先进的情感识别、音频事件检测、反向文本标准化(Pusateri 等人,2017)和标点符号(Chen 等人,2020年)。

语音生成模型,CosyVoice,可以生成多语言的语音,这是超过17万小时和五种语言,包括中文(ZH),英语(EN),日语(JP),广东话(Yue)和韩语(KO)的训练。CosyVoice生成的样本可以实现低于2%的WER和超过75%的说话人相似度,达到人类平价的质量水平。CosyVoice支持零样本上下文学习,这使得语音克隆只需要3秒的提示语音。音色、情感、韵律和风格可以在语言内部或跨语言复制。我们还发布了一个指令模型,它可以控制说话者身份,说话风格(例如,情感)和其他具有自然纹理指令的细粒度语言特征。

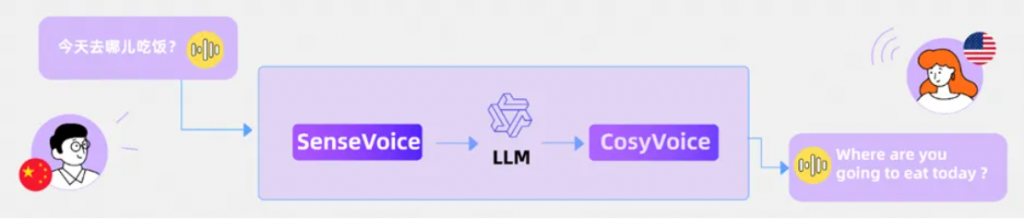

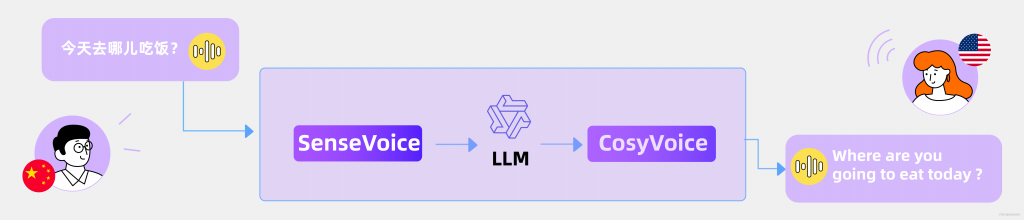

Speech-to-Speech Translation:

通过集成SenseVoice、LLMs和CosyVoice,我们可以毫不费力地执行语音到语音翻译(S2ST)。

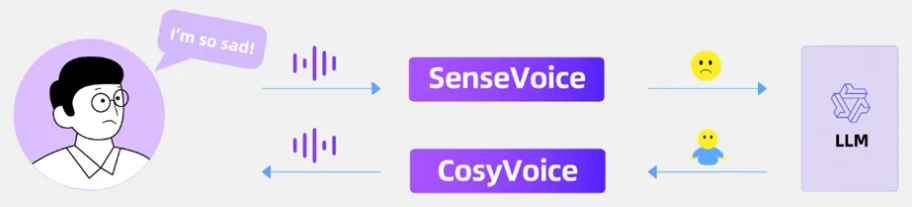

Emotional VoiceChat 情感语音聊天:

通过集成SenseVoice、LLMs和CosyVoice,我们可以开发一个情感语音聊天应用程序。

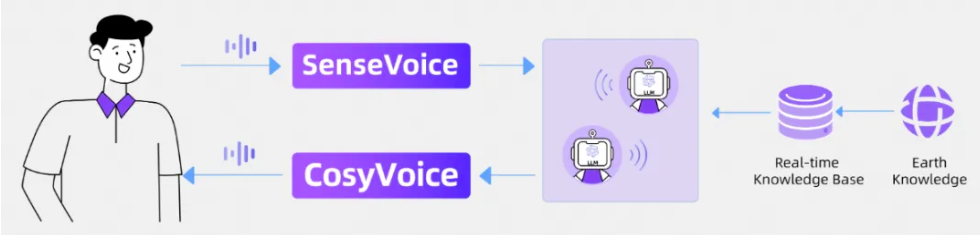

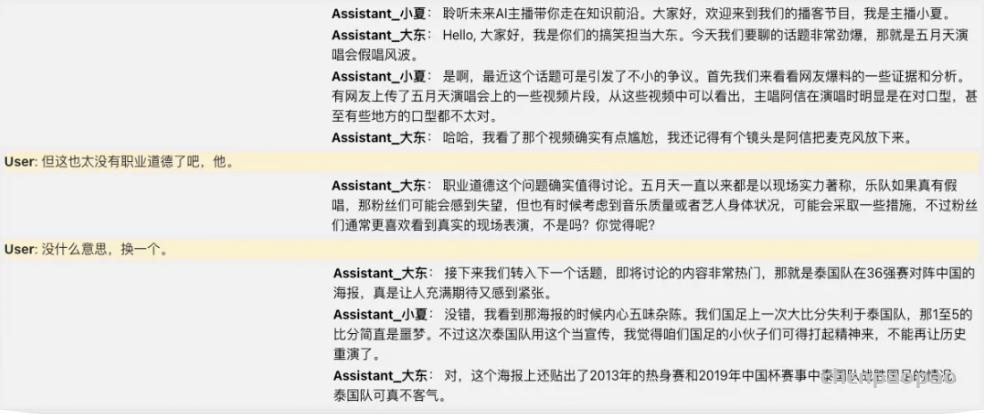

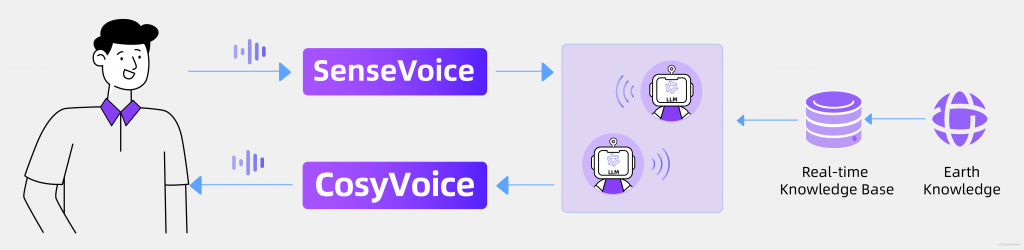

Interactive Podcast 互动播客:通过集成SenseVoice,一个基于LLM的多智能体系统,具有实时世界知识,以及CosyVoice,我们可以创建一个交互式播客。

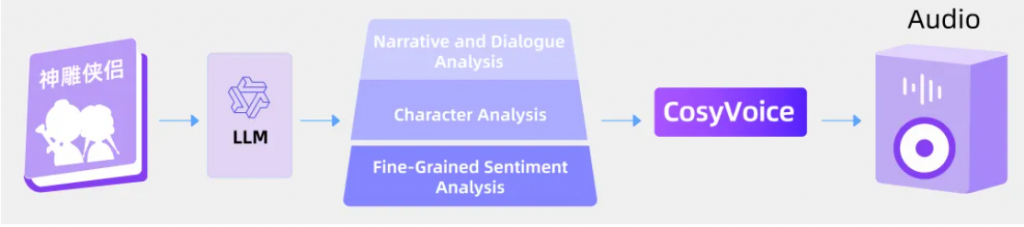

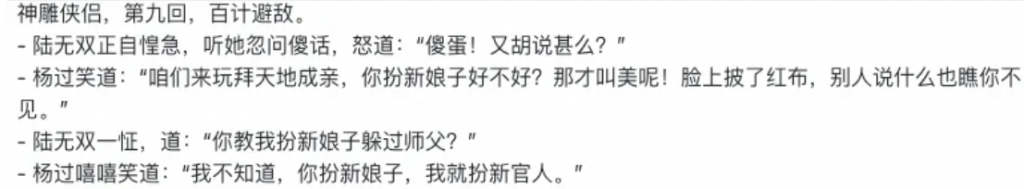

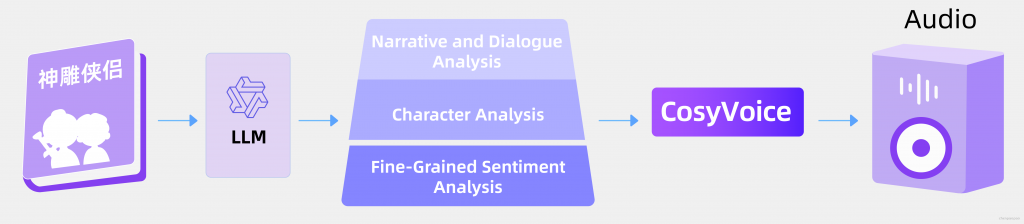

有声书:通过LLMs的分析能力来构建和识别书籍中的情感,并将其与CosyVoice合成,我们实现了具有增强表现力的有声读物。

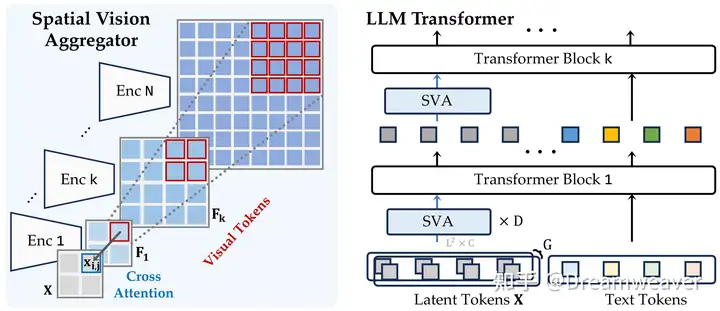

CosyVoice:

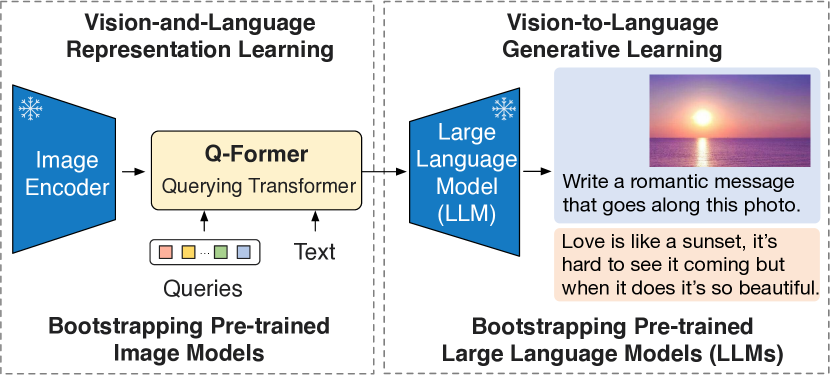

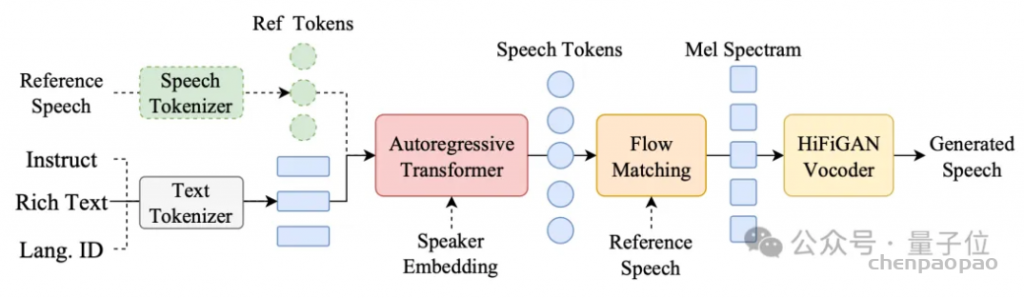

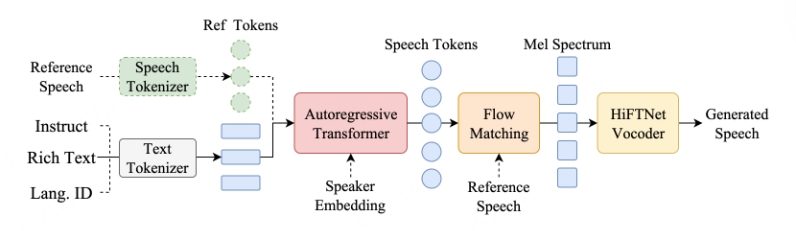

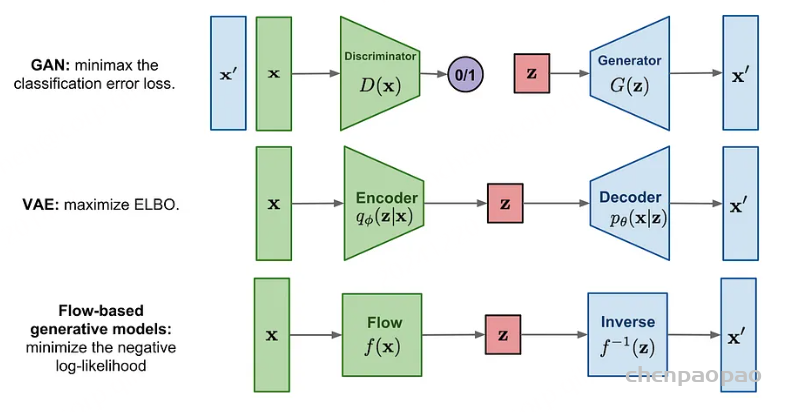

在推理阶段概述CosyVoice模型。概括地说,CosyVoice包括一个自回归Transformer,用于为输入文本生成相应的语音标记,一个基于ODE的扩散模型,流匹配,用于从生成的语音标记重建Mel频谱,以及一个基于HiFiGAN的声码器,用于合成波形。虚线模块在特定模型用途中是可选的,例如跨语言、SFT推理等。[论文]

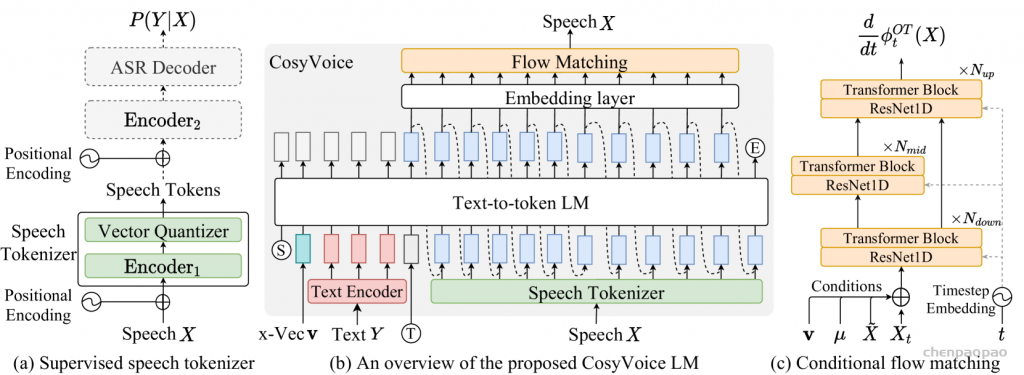

标记器,其中虚线模块仅在训练阶段使用。(b)是CosyVoice的示意图,由文本到令牌LLM和令牌到语音流匹配模型组成。 S、E和T表示“start of sequence”、“end of sequence”和“turn of speech”标记。虚线表示推理阶段的自回归解码。(c)提供了我们的流匹配模型的放大视图,该模型以概率密度路径上的时间步长 t处的说话者嵌入 𝐯、语义标记 μ、掩蔽语音特征 X~和中间状态 Xt为条件。

CosyVoice由四个组件组成,即文本编码器、语音分词器[ speech tokenizer]、大语言模型和条件流匹配模型。具体地说,文本编码器用于对齐文本和语音token的语义空间,而 speech tokenizer 用于提取语义记号,如图1(a)所示。我们采用一个大的语言模型来学习整个文本编码和语音标记序列,将TTS重新表述为一个给定文本作为提示的自回归序列生成问题。然后,如图1(c)所示,利用条件流匹配模型,通过最佳路径上的去噪过程将语音令牌转换为Mel频谱图 。2020)用于以所生成的Mel频谱图作为输入来合成波形。

语音的受监督语义令牌 [ speech tokenizer] :

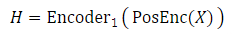

采用有监督的自动语音识别(ASR)模型来导出用于语音的有监督的语义语音( 𝒮3 )分词器。该模型是我们专有的SenseVoice ASR模型的微调版本。它接受了多语言音频数据的训练,并具有丰富的音频内容理解能力。 与原始ASR模型不同,我们将编码器分为两部分,并在它们之间插入矢量量化层。给定Mel频谱图 X 作为输入,其经历位置编码和 Encoder1 以获得上下文感知表示 H :

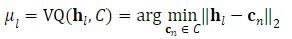

然后,一个矢量量化器(VQ)参与获得离散令牌。 对于帧 l 处的隐藏表示 𝐡l ,码本 C 中的最近嵌入的索引被视为该时间步处的语音令牌 μl :

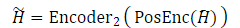

语音令牌的对应码本嵌入被用作量化的隐藏表示 H¯={𝐜μ1,𝐜μ2,…,𝐜μL} ,并通过剩余的编码器层 Encoder2 :

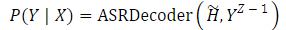

在 Encoder2 之后,接下来是基于transformer的ASR解码器,预测文本标签的后验概率:

TTS的大型语言模型:

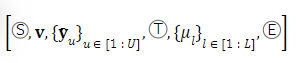

我们将TTS任务表述为具有大型语言模型的自回归语音令牌生成问题(LLM)。对于LLM,序列构建是最重要的事项,其构建如下:

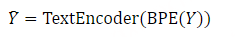

S and E denote the start and end of sequence, respectively.T is “turn of speech” tokens. 𝐯 is a speaker embedding vector extracted from the speech X with a pre-trained voice-print model2. The text encodings Y¯={𝐲¯u}u∈[1:U] is obtained by passing the text through a Byte Pair Encoded (BPE) tokenizer and text encoder:

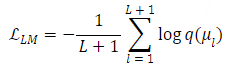

由于文本和语音标记位于不同的语义层,因此文本编码器用于对齐它们的语义空间并有利于LLM建模。 在文本编码和语音标记 {μl}l∈[1:L] 之间插入开始标识符T报告问题,语音标记 {μl}l∈[1:L] 是用2.1中描述的监督语义标记器提取的。在训练阶段,我们采用教师强迫方案,其中左移序列作为模式输入,原始序列作为期望输出。 注意,在训练期间仅考虑语音标记的交叉熵损失和:

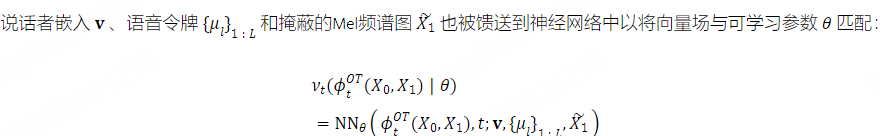

Optimal-transport Conditional Flow Matching:

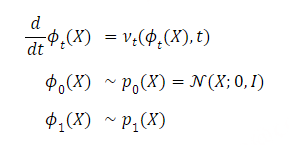

在CosyVoice中,采用最优传输条件流匹配模型(OT-CFM)来学习Mel谱图的分布,并以生成的语音令牌为条件从其生成样本。 与扩散概率模型(DPM)相比,OT-CFM可以实现更好的性能,具有更简单的梯度,更容易的训练和更快的生成.

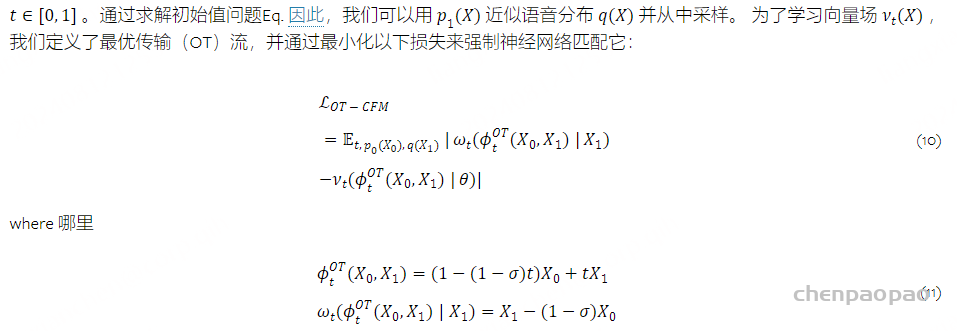

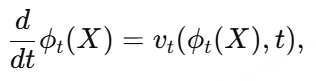

在连续时间归一化流(CNF)中,从先验分布 p0(X) 到Mel谱图 q(X) 的数据分布构造概率密度路径。 概率密度路径由依赖于时间的矢量场 νt(X):[0,1]×ℝL∗D→ℝL∗D 定义,其通过以下常微分方程(ODE)生成流 ϕt :

流匹配模型(The flow matching model)用于估计条件概率 P(S|X, v, Sref)。其中,X 和 v 分别表示语音片段和说话人嵌入,S 和 Sref 分别表示目标和参考语音的梅尔频谱。该模型使用卷积 Transformer U-Net 来确定最优传输 ODE 中先验分布与目标分布之间的矢量场。在推理阶段,只需五到十次迭代即可生成令人满意的梅尔频谱图。此外,还采用无分类器指导技术,通过屏蔽 70% 到 100% 的前置特征条件来增强上下文学习能力。

在从预测的梅尔频谱图合成波形时,我们使用改进的 HiFTNet 声码器,以支持流式生成。

关于最优传输条件流匹配模型的补充:

最优传输条件流匹配(Optimal Transport Conditional Flow Matching,OT-CFM)是一种用于生成模型的流匹配方法,它旨在学习将输入分布和目标分布之间的条件映射。与传统扩散模型(DPM)不同,OT-CFM的优化目标是基于最优传输理论(Optimal Transport,OT)进行的。通过构建和学习流场,OT-CFM能够高效地生成目标数据。

问题背景:给定输入分布 X0 和目标分布 X1,最优传输的目标是找到一个时间相关的流动函数 ϕt 【t介于0-1之间】 使得它能够逐渐将输入分布 X0 演变为目标分布 X1。这个流动由常微分方程(ODE)定义:

其中 vt是一个时间相关的速度场(或流场)。ϕt(X)表示输入数据 X 在时间 t 的状态。

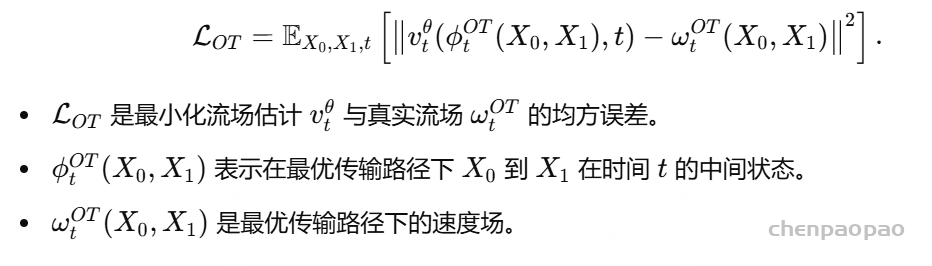

优化目标:OT-CFM 的核心是通过学习流场 vt 使得生成过程遵循最优传输路径。为此,定义最优传输条件流匹配的目标函数:

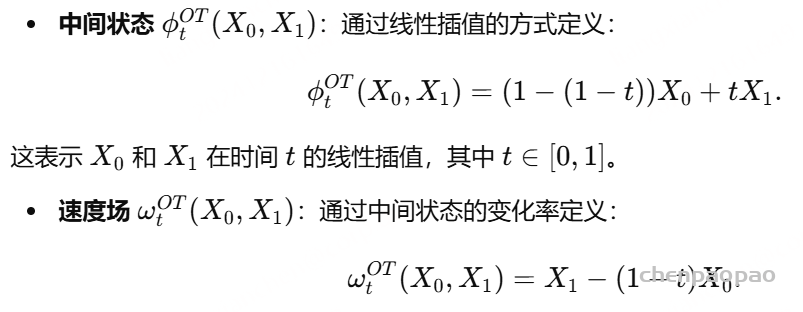

最优传输路径下的流场与中间状态:

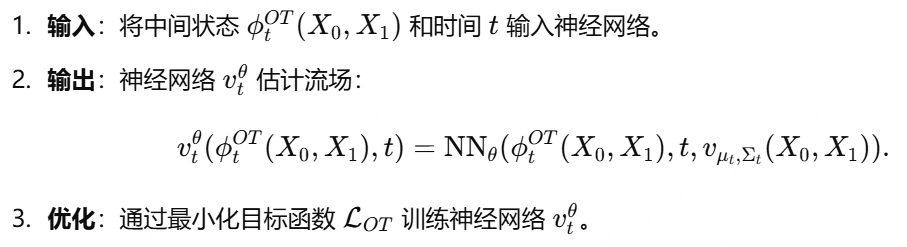

流场的估计与学习:为了学习最优传输的流场 vt,引入一个神经网络 vtθ 对 vt 进行参数化。具体步骤如下:

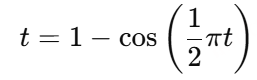

时间调度策略:为了使生成过程更稳定,文章引入了一个时间调度 t 的变换函数:

这个变换函数可以更均匀地分配时间步,提高生成效果。

可以实现的任务:

Multi-lingual Voice Generation 【多语言的语音合成】

Zero-shot In-context Generation 零样本上下文生成

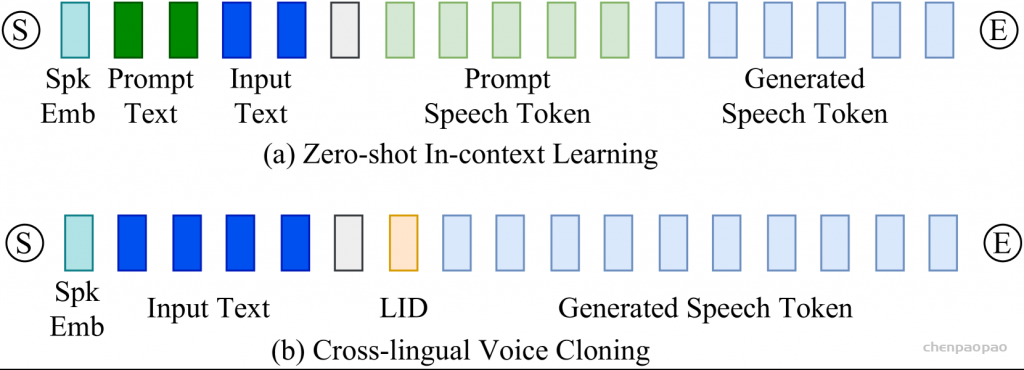

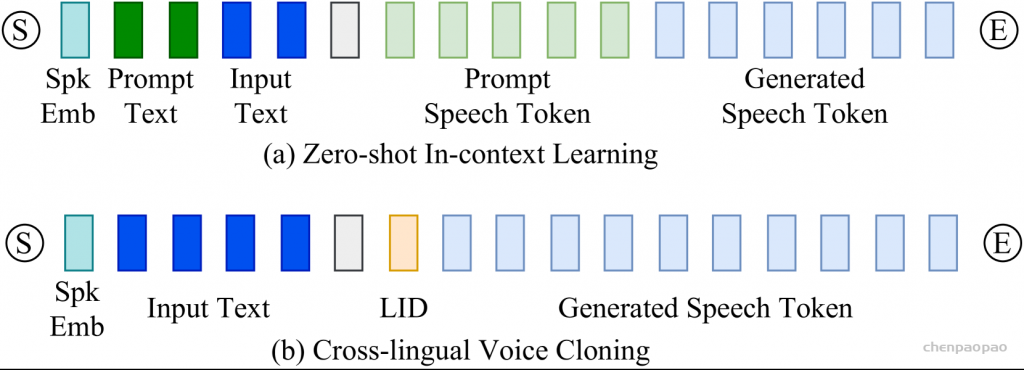

CosyVoice模型具有零触发的上下文学习能力,允许仅用简短的参考语音样本复制任意语音。这个过程需要仔细构造令牌语言模型(LM)的输入序列,如图2所示。 对于同一语言的提示语音和输入文本,我们将它们合并成一个统一的输入,将提示语音标记视为预生成的。利用该输入序列,自回归LM迭代地预测后续令牌,直到其遇到针对前一元素的“序列结束”令牌E。 然而,当提示语音和输入文本在语言上不同时,我们省略与提示相关联的文本和标记,以防止原始语言的韵律特征影响目标语言。 重要的是要注意,提示文本(对应于提示语音的内容)可以通过人工注释或ASR模型(如SenseVoice)转录。与提示文本类似,提示令牌是使用 𝒮3 tokenizer从提示语音中提取的。在生成语音标记之后,它们被附加在提示标记之后,形成流匹配模型的复合条件。此外,说话人嵌入和梅尔声谱图的提示语音,以进一步提高音色和环境的一致性。

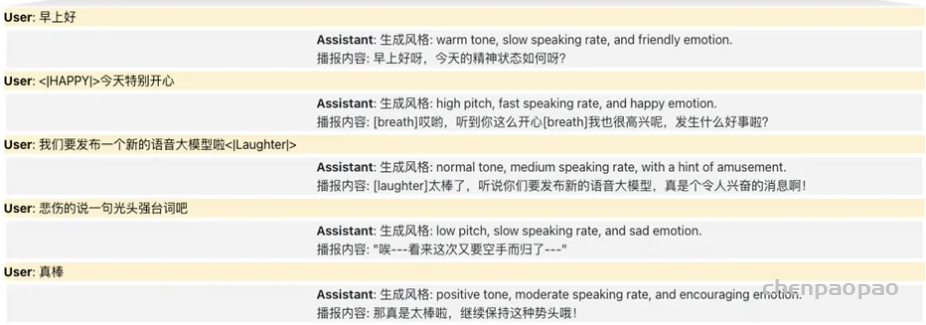

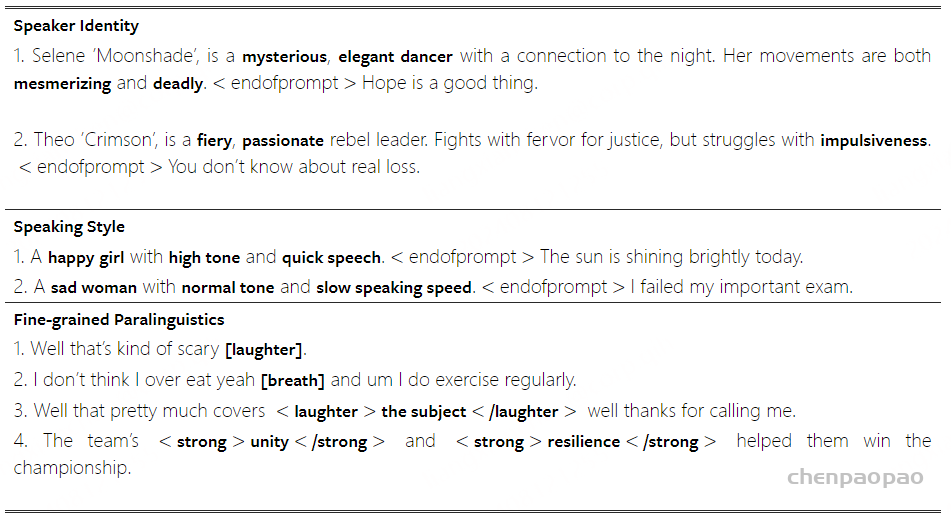

Instructed Voice Generation指令语音生成:

Speaker Identity Control、细粒度控制、Style Control、情感丰富的声音生成、Speaker Fine-tune、Speaker Interpolation

为了进一步实现对CosyVoice的可控性,我们尝试集成额外的指令微调(Ji 等人,2023年)。CosyVoice-instruct扩展了CosyVoice-base,具有增强的后续功能。具体地说,它支持对诸如说话人身份(即,说话者的特征)、说话风格(包括情感、性别、语速和音调)以及细粒度的副语言特征。这些功能包括插入笑声、呼吸、边笑边说以及强调某些单词的能力。

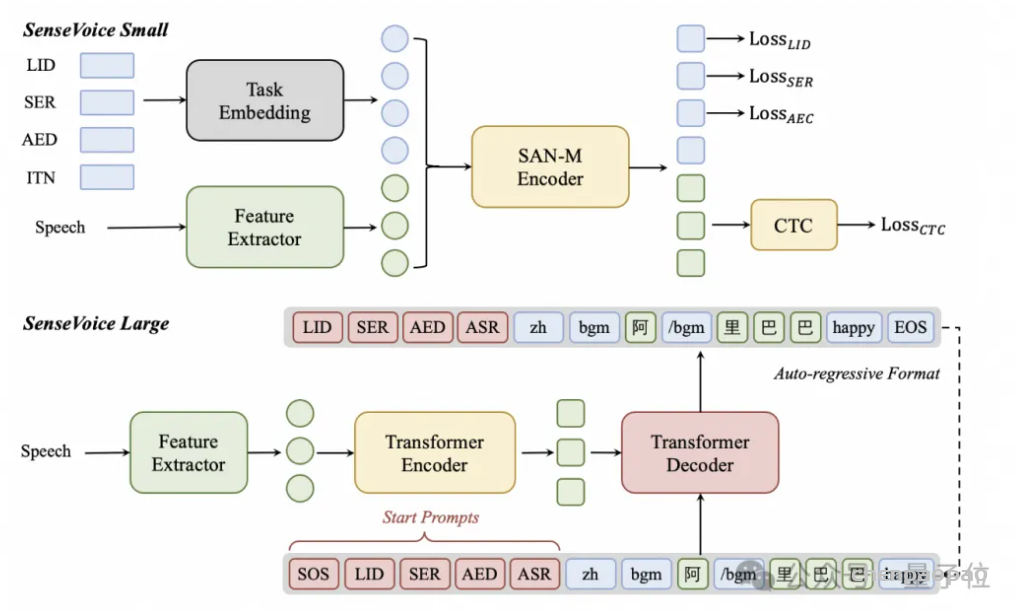

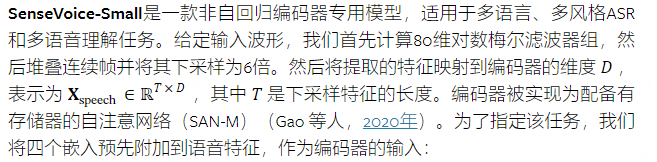

SenseVoice:

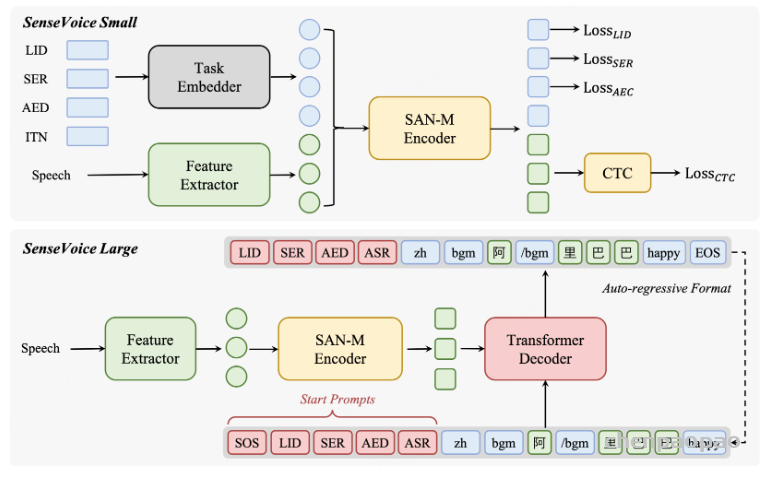

SenseVoice 是具有音频理解能力的音频基础模型,包括语音识别(ASR)、语种识别(LID)、语音情感识别(SER)和声学事件分类(AEC)或声学事件检测(AED)。提出了具有不同大小和架构的两个模型以适应不同的要求:SenseVoice-Small,用于快速语音理解的仅编码器语音基础模型,以及SenseVoice-Large,编码器-解码器(Vaswani 等人,2017)语音基础模型,用于更准确的语音理解,支持更多语言。

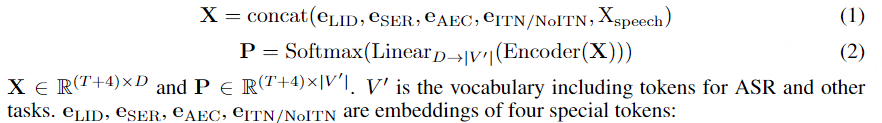

𝐞LID 、 𝐞SER 、 𝐞AEC 、 𝐞ITN/NoITN 是四个特殊标记的嵌入:

⟨LID⟩ 表示LID任务。如果 ⟨LID⟩ 被放置 ,则模型被训练以预测输出的对应位置处的语言标记。 在训练阶段,我们根据概率0.8用真实语言标记随机替换 ⟨LID⟩ ,以便模型可以预测语言标记,或者在推理阶段配置指定的语言标记。

⟨SER⟩ 表示SER任务。如果 ⟨SER⟩ 被放置,则训练模型以预测输出的对应位置处的语音情感标签。

⟨AEC⟩ 表示AEC任务。如果 ⟨AEC⟩ 被放置 ,则模型被训练以预测输出的对应位置处的音频事件标签。

⟨ITN⟩ 或 ⟨NoITN⟩ 指定转录样式。如果提供了 ⟨ITN⟩ ,则模型被训练为使用反向文本规范化(ITN)和标点符号进行转录。如果提供了 ⟨NoITN⟩ ,则模型被训练为在没有ITN和标点符号的情况下转录。

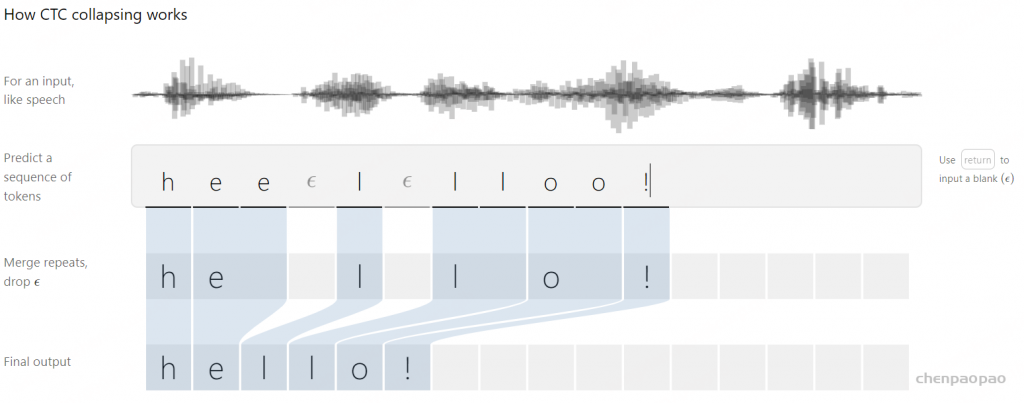

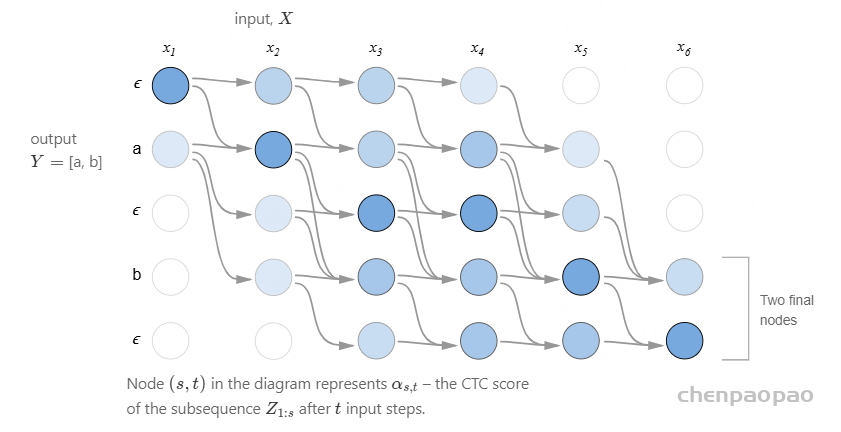

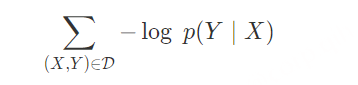

在训练阶段,利用交叉熵损失对LID、SER和AEC任务进行优化。ASR任务使用CTC损失来优化。

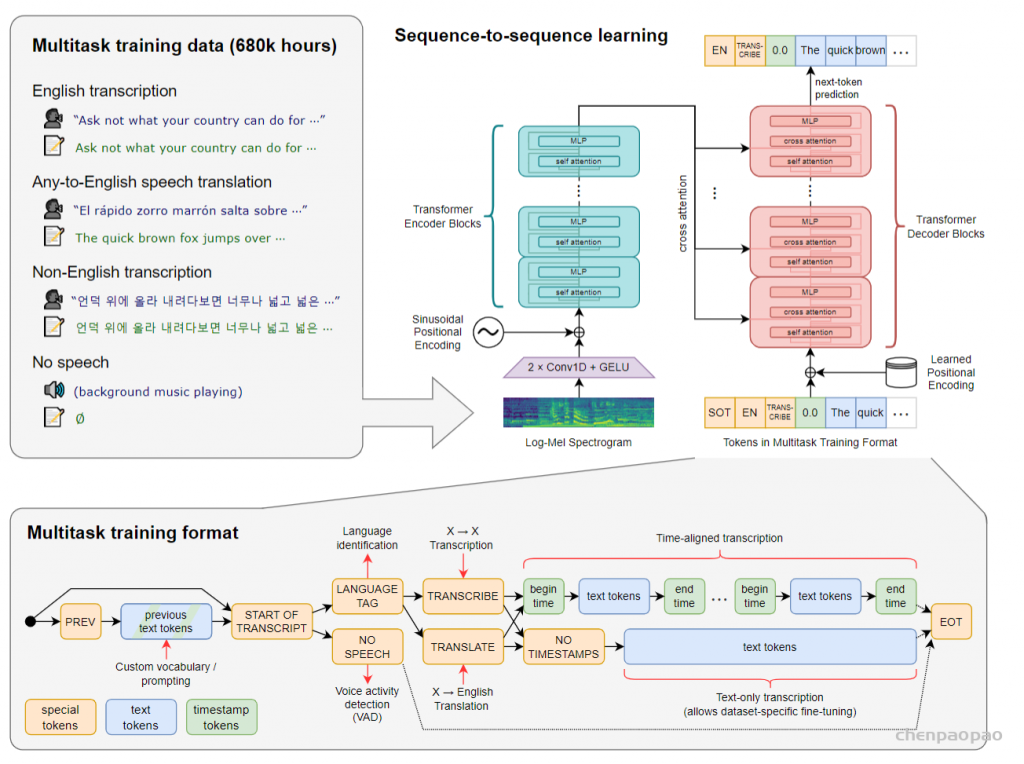

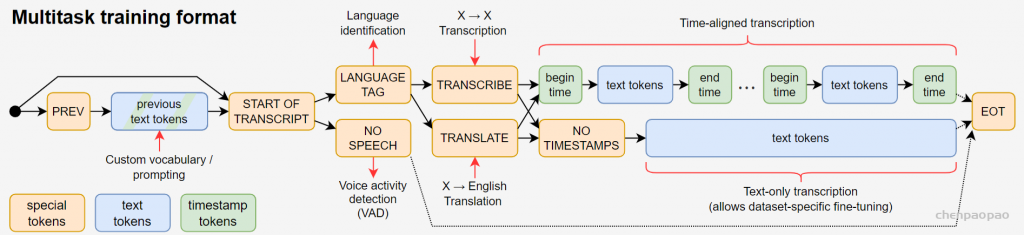

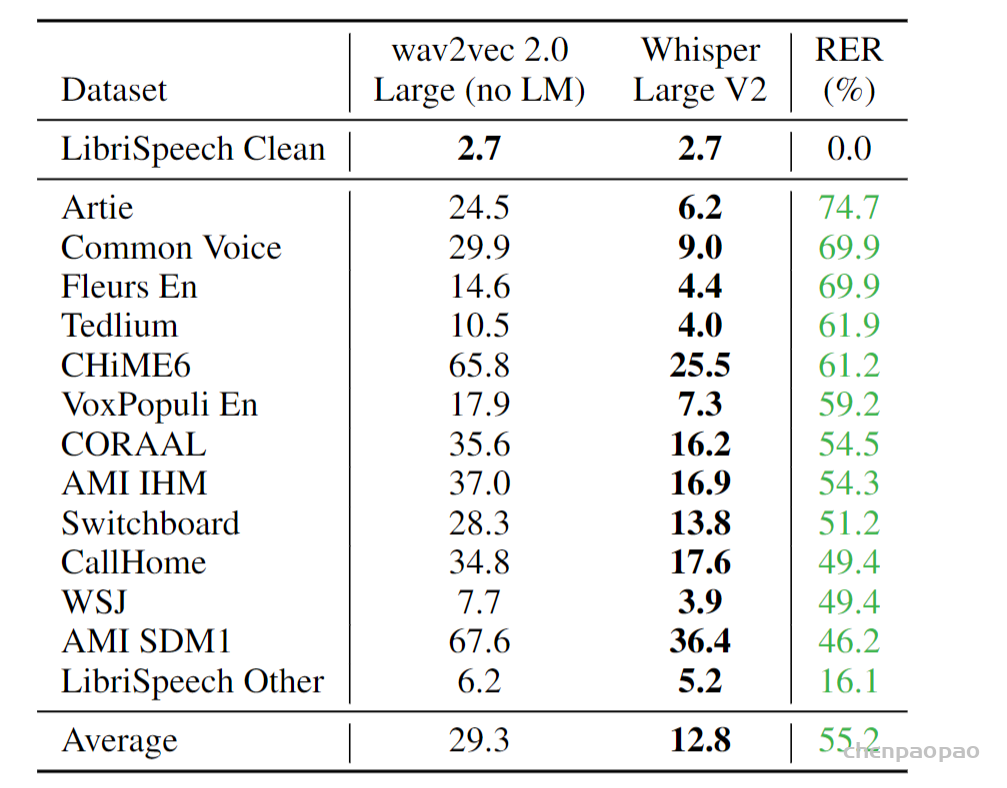

SenseVoice-Large是一个自回归编码器-解码器模型,用于多语言ASR和多语音理解任务。与Whisper类似(拉德福 等人,2023),SenseVoice-Large通过解码器的输入令牌序列来指定任务。具体来说,我们通过分别包括 ⟨LID⟩ 、 ⟨SER⟩ 、 ⟨AED⟩ 令牌来指定是否预测具有时间戳的语言、语音情感和音频事件。与SenseVoice-Small相比,SenseVoice-Large的优势在于转录准确性和支持大量语言(50+)。

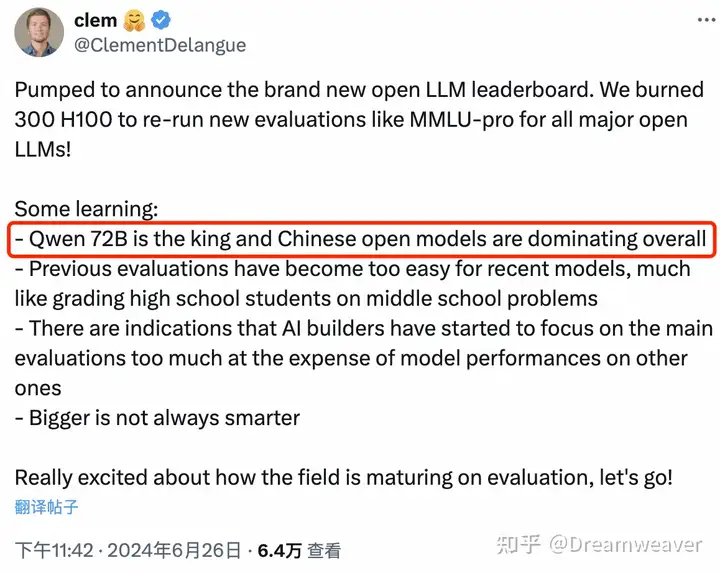

SenseVoice 专注于高精度多语言语音识别、情感辨识和音频事件检测

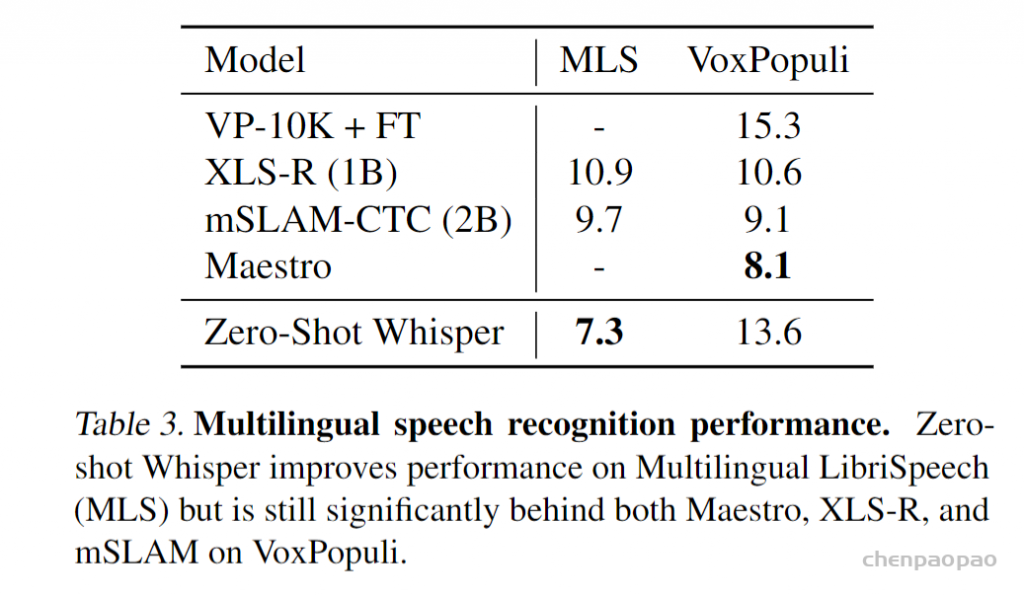

- 多语言识别: 采用超过 40 万小时数据训练,支持超过 50 种语言,识别效果上优于 Whisper 模型。

- 富文本识别:

- 具备优秀的情感识别,能够在测试数据上达到和超过目前最佳情感识别模型的效果。

- 支持声音事件检测能力,支持音乐、掌声、笑声、哭声、咳嗽、喷嚏等多种常见人机交互事件进行检测。

- 高效推理: SenseVoice-Small 模型采用非自回归端到端框架,推理延迟极低,10s 音频推理仅耗时 70ms,15 倍优于 Whisper-Large。

- 微调定制: 具备便捷的微调脚本与策略,方便用户根据业务场景修复长尾样本问题。

- 服务部署: 具有完整的服务部署链路,支持多并发请求,支持客户端语言有,python、c++、html、java 与 c# 等。

推理效率:

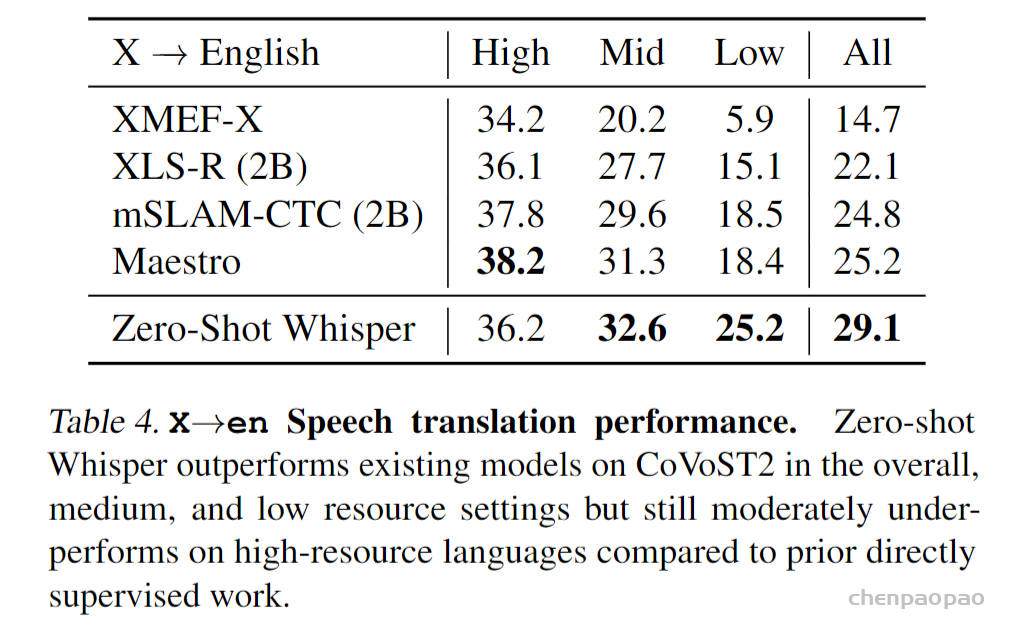

性能评测:

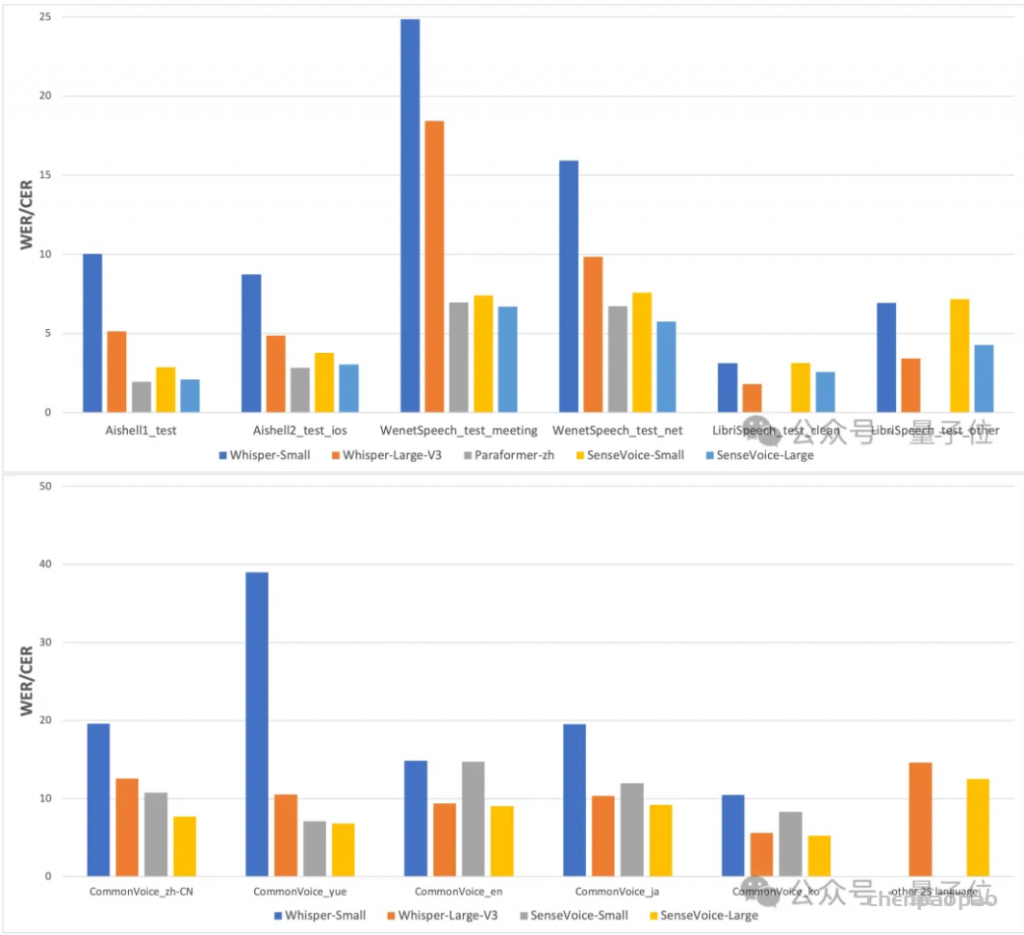

我们在开源基准数据集(包括AISHELL-1、AISHELL-2、Wenetspeech、Librisepeech和Common Voice)上比较了SenseVoice和Whisper的多语言识别性能和推理效率。使用A800机器进行推理效率评估。SenseVoice-small采用非自回归端到端架构,推理延迟极低-与Whisper-small相比快7倍,与Whisper-large相比快17倍。

1、文本识别:[在开源基准数据集(包括 AISHELL-1、AISHELL-2、Wenetspeech、Librispeech 和 Common Voice)上比较了 SenseVoice 与 Whisper 的多语言语音识别性能和推理效率。在中文和粤语识别效果上,SenseVoice-Small 模型具有明显的效果优势。]

2、情感识别

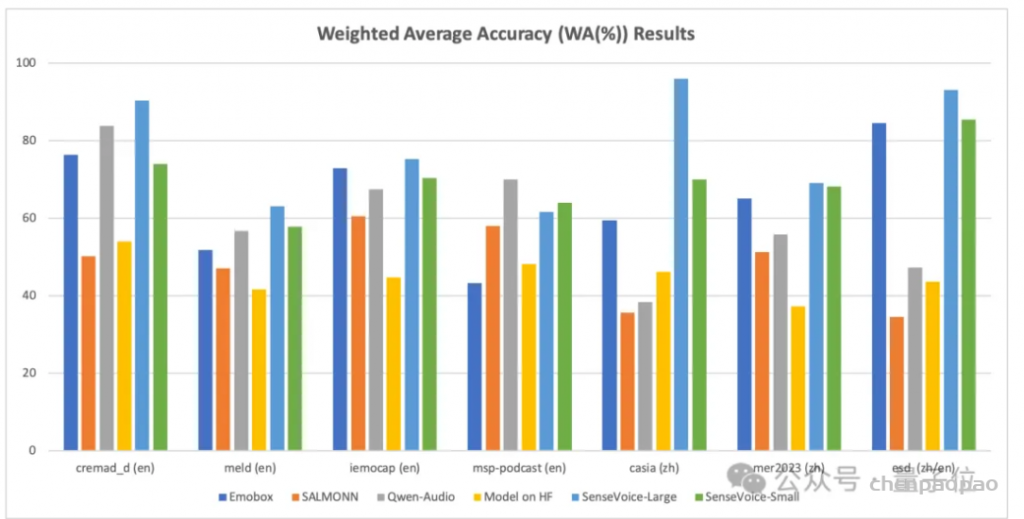

SenseVoice也可以用于离散情感识别。支持快乐、悲伤、愤怒和中立。我们在7个流行的情感识别数据集上对其进行了评估。SenseVoice-Large可以在大多数数据集上接近或超过SOTA结果,即使没有目标语料库微调。

由于目前缺乏被广泛使用的情感识别测试指标和方法,我们在多个测试集的多种指标进行测试,并与近年来 Benchmark 上的多个结果进行了全面的对比。所选取的测试集同时包含中文 / 英文两种语言以及表演、影视剧、自然对话等多种风格的数据,在不进行目标数据微调的前提下,SenseVoice 能够在测试数据上达到和超过目前最佳情感识别模型的效果。

我们还在测试集上对多个开源情感识别模型进行对比,结果表明,SenseVoice-Large 模型可以在几乎所有数据上都达到了最佳效果,而 SenseVoice-Small 模型同样可以在多数数据集上取得超越其他开源模型的效果。

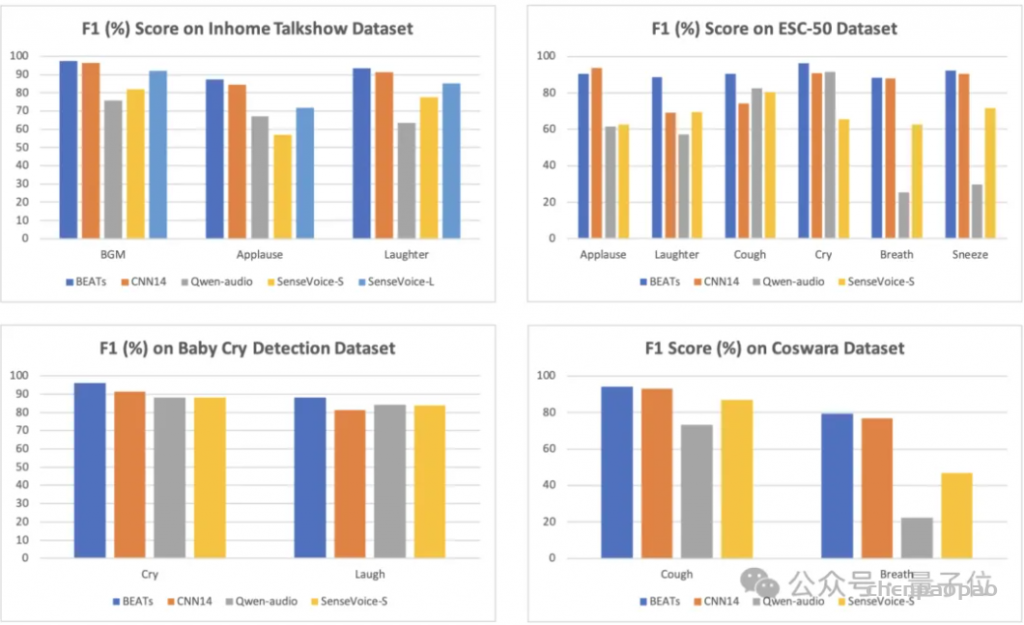

3、事件检测

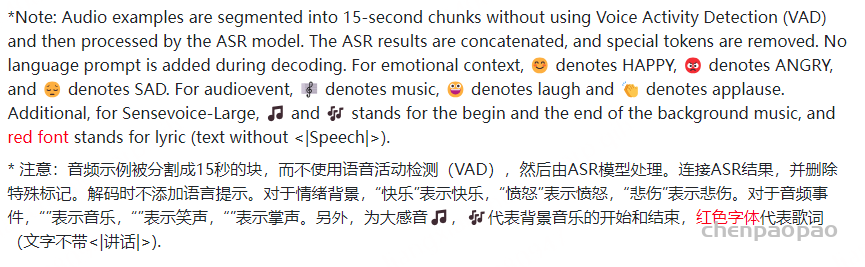

SenseVoice-Small和SenseVoice-Large模型都可以检测到语音中的音频事件,包括音乐、掌声、笑声。SenseVoice-Large可以预测音频事件的开始和结束位置,而SenseVoice Small只能预测音频中发生了什么(只有一个事件),但是,它可以检测更多的事件,例如在人机交互过程中可能发生的咳嗽,打喷嚏,呼吸和哭泣。

尽管 SenseVoice 只在语音数据上进行训练,它仍然可以作为事件检测模型进行单独使用。我们在环境音分类 ESC-50 数据集上与目前业内广泛使用的 BEATS 与 PANN 模型的效果进行了对比。SenseVoice 模型能够在这些任务上取得较好的效果,但受限于训练数据与训练方式,其事件分类效果专业的事件检测模型相比仍然有一定的差距。

训练数据:

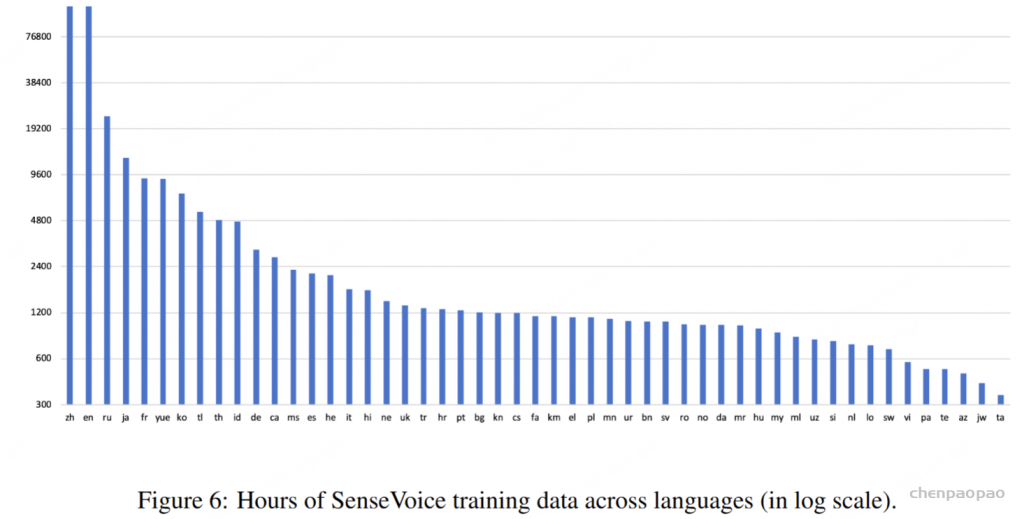

SenseVoice的训练集

下图展示了用于训练 SenseVoice 模型的数据集概览。

SenseVoice-Small 模型在一个包含约 30 万小时音频数据的庞大语料库上进行了训练,覆盖了包括中文、粤语、英语、日语和韩语在内的 5 种语言。为了进一步增强 SenseVoice-Large 的多语言能力,训练语料库中额外加入了 10 万小时多语言数据。为了从语音数据中获取丰富的转录标签,我们利用了开源的音频事件检测(AED)模型和语音情感识别(SER)模型,生成伪标签,从而构建了一个内容丰富的大规模转录数据集。具体而言,AED 数据集包含了 1.5 亿条音频,而 SER 数据集则包含了 3000 万条音频。

【 SER 模型 :https://modelscope.cn/models/iic/emotion2vec_plus_large】

【 AED模型 :https://github.com/qiuqiangkong/audioset_tagging_cnn/tree/master】

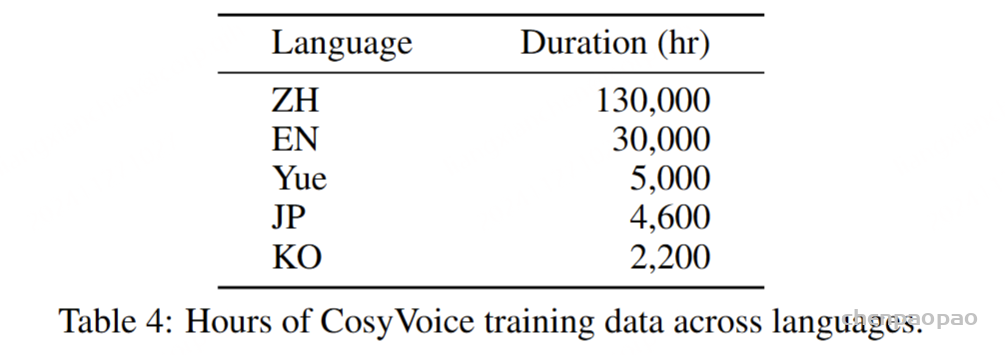

CosyVoice 的训练集

为了训练 CosyVoice 模型,我们积累了一个包含多种语言的大量数据集。在整个收集过程中,我们利用专门的内部工具进行语音检测、信噪比 (SNR) 估计、说话人分类和分离。随后,使用 SenseVoice-Large 和 Paraformer 生成伪文本标签。这些标签在力对齐 (FA) 模型的帮助下经过优化过程,这有助于消除低质量的数据并提高标点符号的准确性。表 4 列出了各种语言的训练数据持续时间的全面细分。

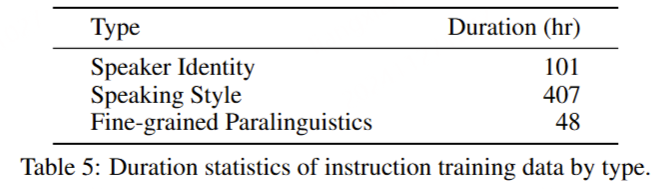

对于 CosyVoice-instruct 模型,我们使用指令训练数据对 CosyVoice-base 进行了微调,而无需在自回归语言模型中加入说话人嵌入。表 5 显示了不同类型指令的训练数据的持续时间。

限制:

1、SenseVoice有一些需要解决的局限性。首先,对于资源不足的语言,ASR性能通常要低得多。其次,SenseVoice不是为流式转录而设计的。因此,未来的工作可能会集中在开发基于SenseVoice的流式语音理解模型。

2、CosyVoice也有一些限制。首先,它支持的语言数量有限。虽然它可以根据明确的指令表达情感和说话风格,但它不能根据文本的语义内容推断出适当的情感或风格。此外,CosyVoice在唱歌时表现不佳。在保持声音原有音色的同时,实现富有表现力的情感变化仍有改进的空间。

3、另一个限制是FunAudioLLM中的两个创新模型没有使用LLMs进行端到端的训练。这种流水线方法可能会引入错误传播,这可能会影响整体性能。

sensevoice 推理代码:

def inference(

self,

data_in,

data_lengths=None,

key: list = ["wav_file_tmp_name"],

tokenizer=None,

frontend=None,

**kwargs,

):

meta_data = {}

if (

isinstance(data_in, torch.Tensor) and kwargs.get("data_type", "sound") == "fbank"

): # fbank

speech, speech_lengths = data_in, data_lengths

if len(speech.shape) < 3:

speech = speech[None, :, :]

if speech_lengths is None:

speech_lengths = speech.shape[1]

else:

# extract fbank feats

time1 = time.perf_counter()

audio_sample_list = load_audio_text_image_video(

data_in,

fs=frontend.fs,

audio_fs=kwargs.get("fs", 16000),

data_type=kwargs.get("data_type", "sound"),

tokenizer=tokenizer,

)

# print(audio_sample_list)

time2 = time.perf_counter()

meta_data["load_data"] = f"{time2 - time1:0.3f}"

speech, speech_lengths = extract_fbank(

audio_sample_list, data_type=kwargs.get("data_type", "sound"), frontend=frontend

)

time3 = time.perf_counter()

meta_data["extract_feat"] = f"{time3 - time2:0.3f}"

meta_data["batch_data_time"] = (

speech_lengths.sum().item() * frontend.frame_shift * frontend.lfr_n / 1000

)

speech = speech.to(device=kwargs["device"])

speech_lengths = speech_lengths.to(device=kwargs["device"])

print("speech", speech.shape, speech_lengths)

language = kwargs.get("language", "auto")

language_query = self.embed(

torch.LongTensor(

[[self.lid_dict[language] if language in self.lid_dict else 0]]

).to(speech.device)

).repeat(speech.size(0), 1, 1)

print("language_query", language_query.shape)

use_itn = kwargs.get("use_itn", False)

textnorm = kwargs.get("text_norm", None)

if textnorm is None:

textnorm = "withitn" if use_itn else "woitn"

textnorm_query = self.embed(

torch.LongTensor([[self.textnorm_dict[textnorm]]]).to(speech.device)

).repeat(speech.size(0), 1, 1)

print("textnorm_query", textnorm_query.shape)

speech = torch.cat((textnorm_query, speech), dim=1)

speech_lengths += 1

print("speech_add_textnorm", speech.shape, speech_lengths)

event_emo_query = self.embed(torch.LongTensor([[1, 2]]).to(speech.device)).repeat(

speech.size(0), 1, 1

)

print("event_emo_query", event_emo_query.shape)

input_query = torch.cat((language_query, event_emo_query), dim=1)

print("input_query", input_query.shape)

speech = torch.cat((input_query, speech), dim=1)

speech_lengths += 3

print("speech_final", speech.shape, speech_lengths)

# Encoder

encoder_out, encoder_out_lens = self.encoder(speech, speech_lengths)

print("encoder_out", encoder_out.shape, encoder_out_lens)

if isinstance(encoder_out, tuple):

encoder_out = encoder_out[0]

# c. Passed the encoder result and the beam search

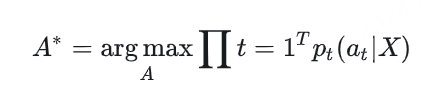

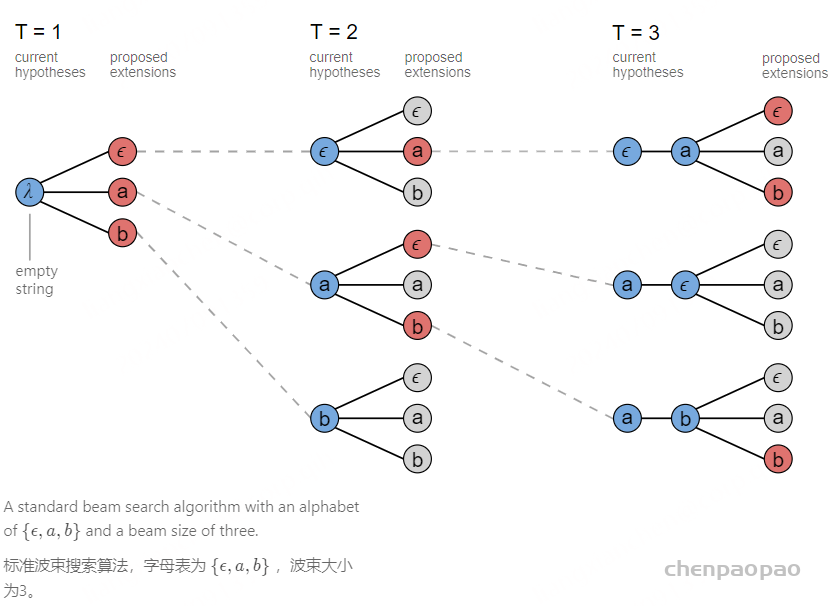

# 束搜索和CTC解码

ctc_logits = self.ctc.log_softmax(encoder_out)

results = []

b, n, d = encoder_out.size()

if isinstance(key[0], (list, tuple)):

key = key[0]

if len(key) < b:

key = key * b

for i in range(b):

#对每个 batch 样本提取 CTC logits 输出的前 encoder_out_lens[i] 帧。

#使用 argmax 找到每个时间步概率最大的类别 ID (yseq)。

#使用 torch.unique_consecutive 去除连续的重复类别 ID(CTC 解码中的常见步骤,用于去除重复的符号)。

x = ctc_logits[i, : encoder_out_lens[i].item(), :]

yseq = x.argmax(dim=-1)

yseq = torch.unique_consecutive(yseq, dim=-1) # 使用 torch.unique_consecutive 去除连续的重复类别 ID(CTC 解码中的常见步骤,用于去除重复的符号)

ibest_writer = None

if kwargs.get("output_dir") is not None:

if not hasattr(self, "writer"):

self.writer = DatadirWriter(kwargs.get("output_dir"))

ibest_writer = self.writer[f"1best_recog"]

#使用 mask 去掉 CTC 解码中的 blank ID。

#将整数 ID 列表转化为对应的字符或单词(通过 tokenizer.decode)。

mask = yseq != self.blank_id

token_int = yseq[mask].tolist()

# Change integer-ids to tokens

text = tokenizer.decode(token_int)

result_i = {"key": key[i], "text": text}

results.append(result_i)

if ibest_writer is not None:

ibest_writer["text"][key[i]] = text

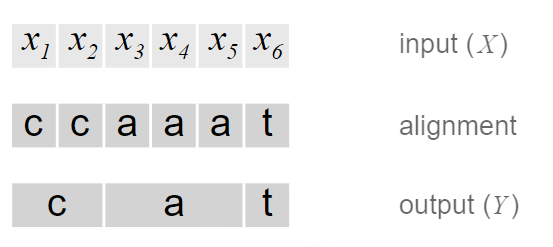

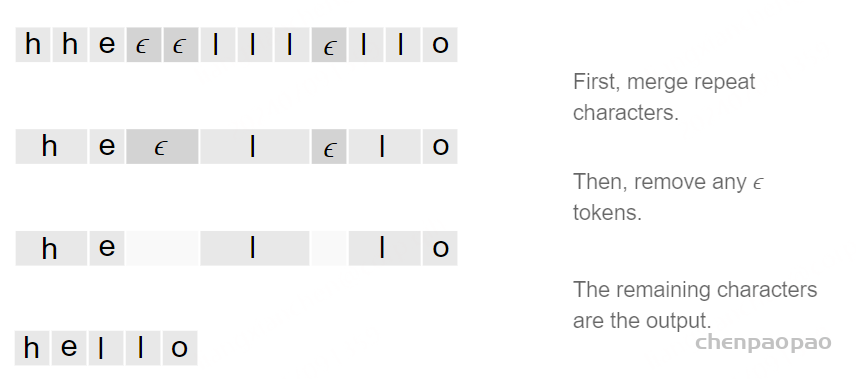

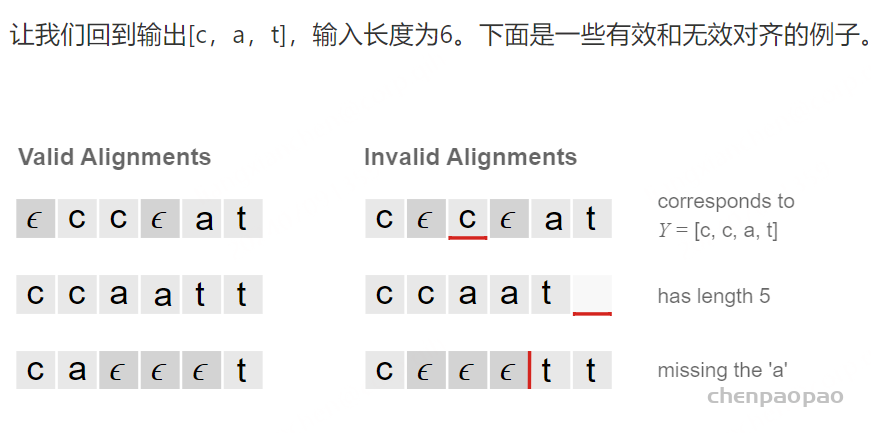

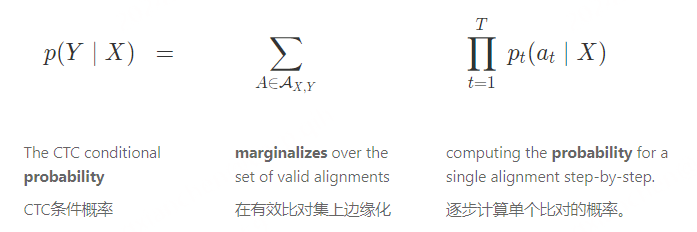

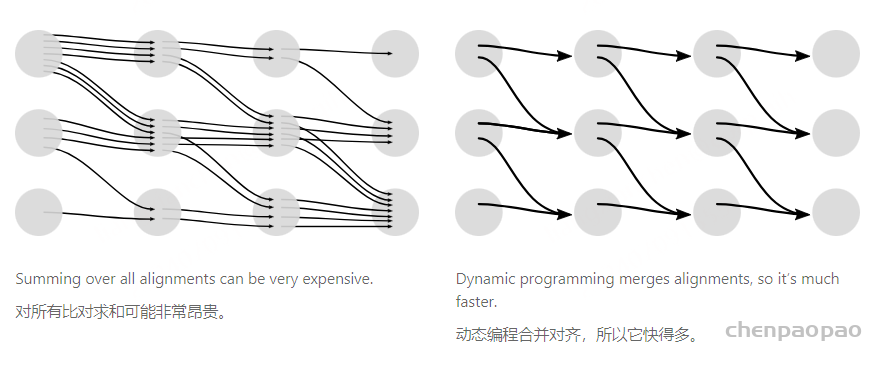

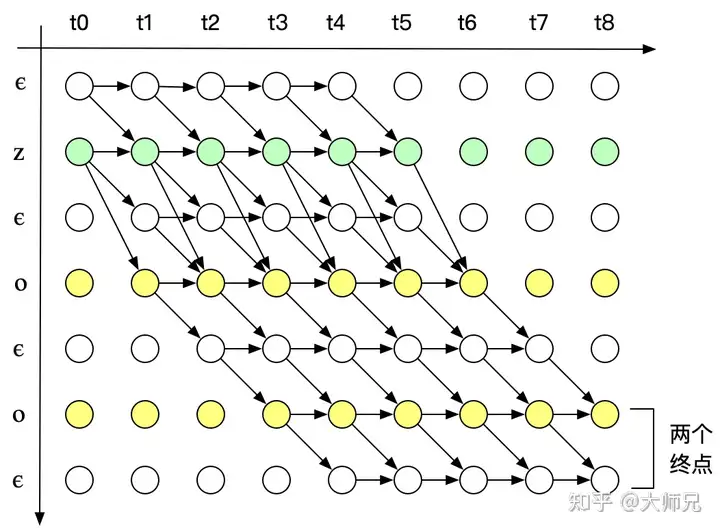

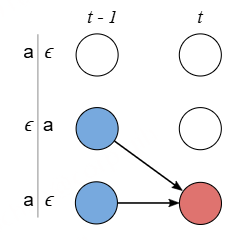

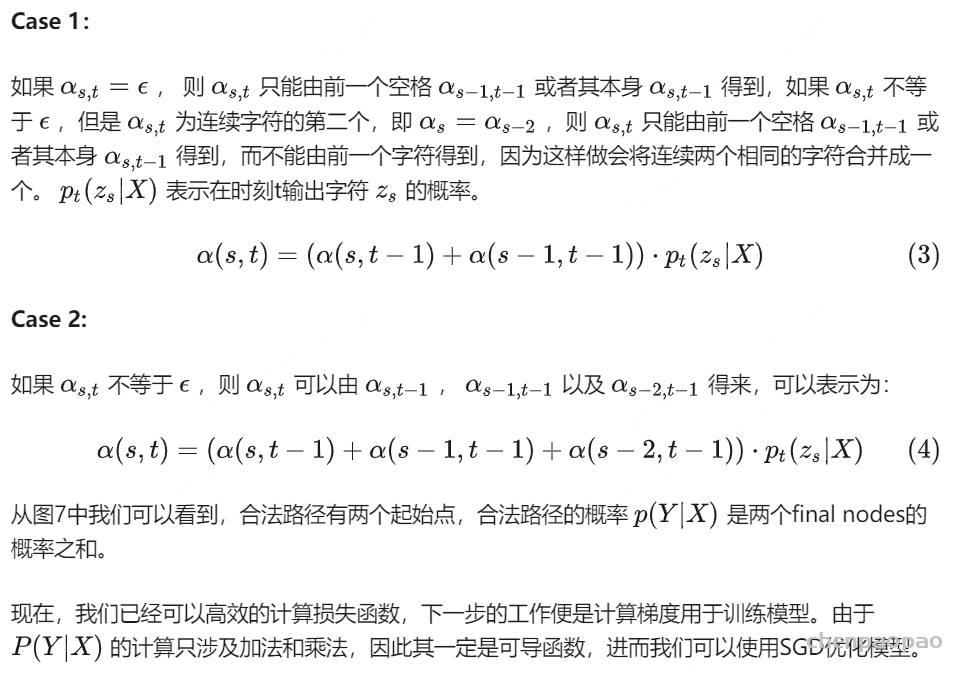

return results, meta_dataCTC使用blank id来对齐不同长度的输入和输出:

- 在语音识别等任务中,输入的语音帧数往往远多于输出的字符数。CTC 通过引入

blank ID来解决这个问题,使模型能够生成对齐(alignment),从而允许输入长度大于输出长度。 - blank 用来表示在某个时间步模型没有输出任何字符,或者保持上一个字符的状态不变。

去除重复和冗余:

- 语音帧与字符之间的对齐并不是一一对应的,CTC 会允许模型在多个时间步中输出相同的字符,同时在其他时间步输出

blank。 - 解码过程中,当遇到连续的相同字符时,只保留第一个字符,忽略重复出现的字符和

blank,这帮助去除冗余。 - 例如,模型输出可能是

[a, blank, blank, a, a, blank, t, blank, blank],最终解码结果会变为"a, t"。