Qwen3-Omni ,这是一个原生端到端的多语言全模态基础模型。它旨在处理包括文本、图像、音频和视频在内的各种输入,同时提供文本和自然语音的实时流式响应。

💜 Qwen Chat | 🤗 Hugging Face | 🤖 ModelScope | 📑 Blog | 📚 Cookbooks | 📑 Paper

🖥️ Hugging Face Demo | 🖥️ ModelScope Demo | 💬 WeChat (微信) | 🫨 Discord | 📑 API

主要特点:

- 原生全模态:Qwen3-Omni是原生全模态大模型,预训练全模态不降智。

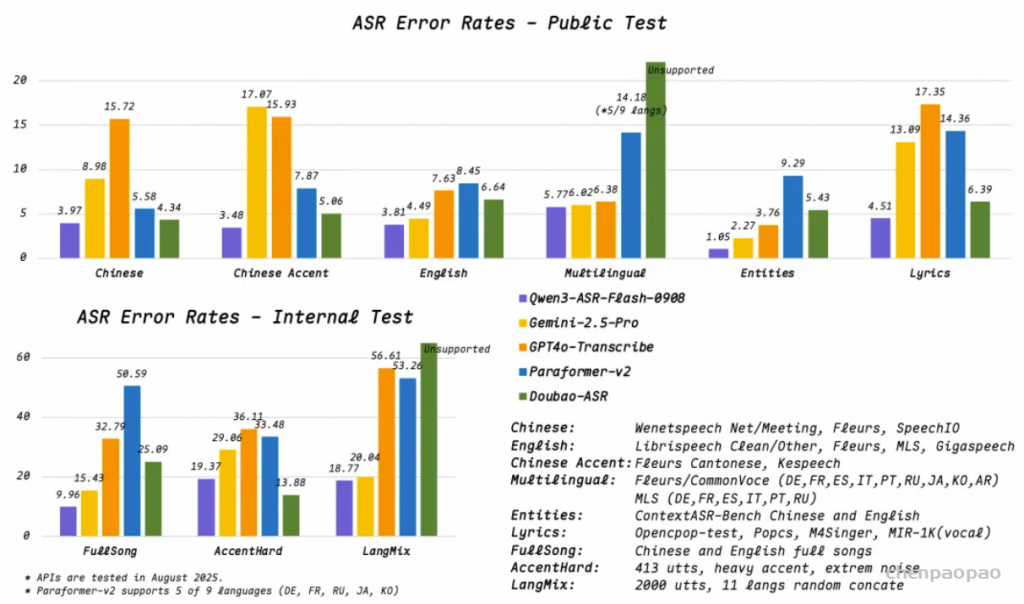

- 强大的性能:Qwen3-Omni在36项音频及音视频基准测试中斩获32项开源SOTA与22项总体SOTA,超越Gemini-2.5-Pro、Seed-ASR、GPT-4o-Transcribe等闭源强模型,同时其图像和文本性能也在同尺寸模型中达到SOTA水平。

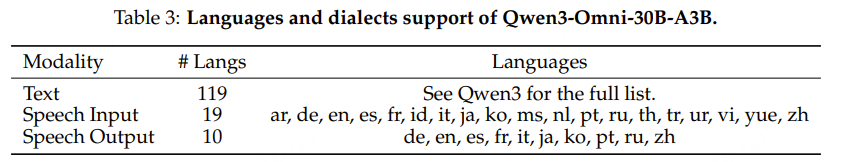

- 多语言:Qwen3-Omni支持119种文本语言交互、19种语音理解语言与10种语音生成语言。

- 更快响应:Qwen3-Omni纯模型端到端音频对话延迟低至211ms,视频对话延迟低至507ms。

- 长音频:Qwen3-Omni支持长达30分钟音频理解。

- 个性化:Qwen3-Omni支持system prompt随意定制,可以修改回复风格,人设等。

- 工具调用:Qwen3-Omni支持function call,实现与外部工具/服务的高效集成。

- 开源通用音频Captioner:开源Qwen3-Omni-30B-A3B-Captioner,低幻觉且非常详细的通用音频caption模型,填补开源社区空白。

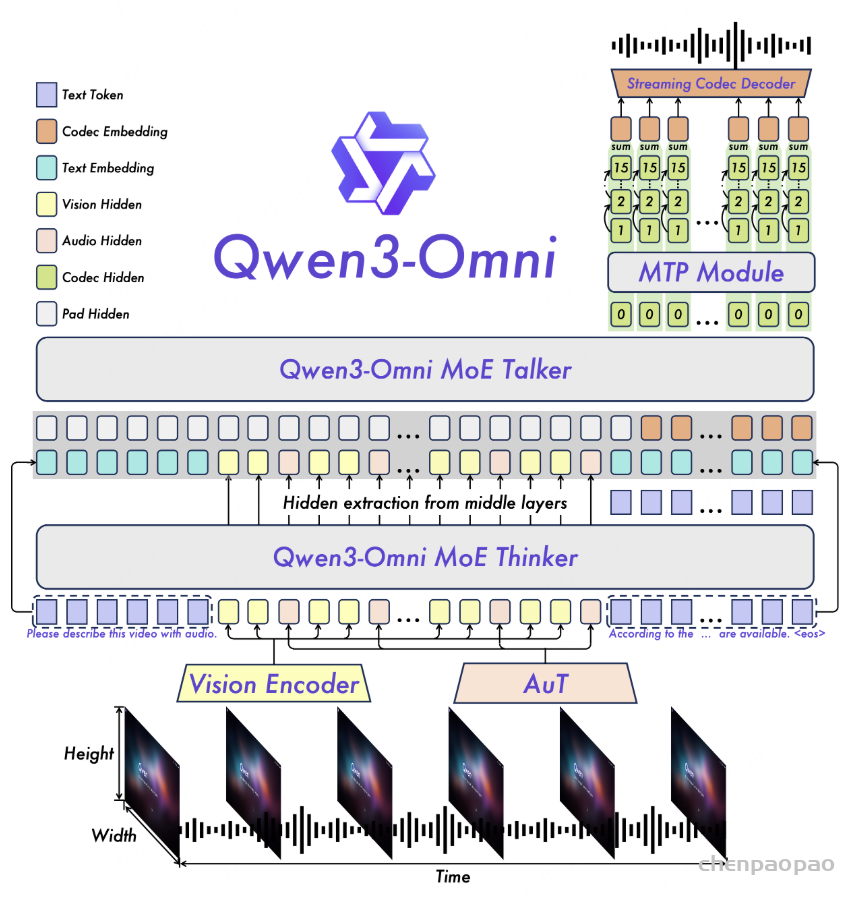

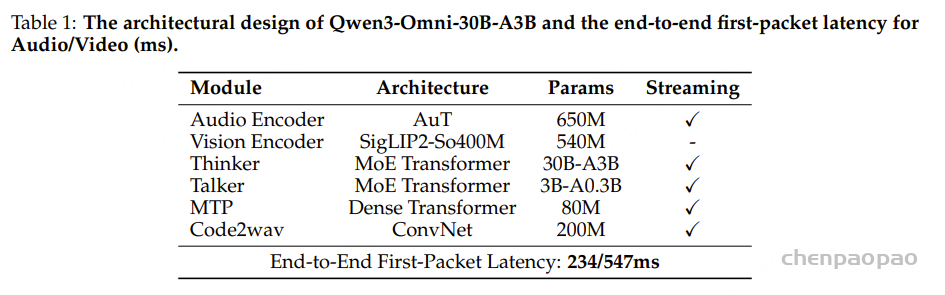

模型架构:

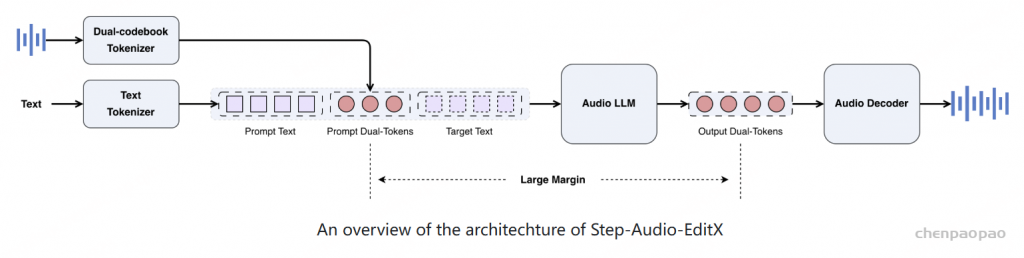

Qwen3-Omni采用Thinker-Talker架构:Thinker负责文本生成,Talker专注于流式语音Token生成,直接接收来自Thinker的高层语义表征。为实现超低延迟流式生成,Talker通过自回归方式预测多码本序列:在每一步解码中,MTP模块输出当前帧的残差码本,随后Code2Wav合成对应波形,实现逐帧流式生成。

- 创新架构设计AuT:音频编码器采用基于2000万小时音频数据训练的AuT模型,具备极强的通用音频表征能力。MoE:Thinker与Talker均采用MoE架构,支持高并发与快速推理。多码本技术:Talker采用多码本自回归方案——每步生成一个编解码帧,MTP模块同步输出剩余残差码本。

- 全模态不降智在文本预训练早期混合单模态与跨模态数据,可实现各模态混训性能相比纯单模态训练性能不下降,同时显著增强跨模态能力。

- 卓越的语音对话与指令跟随能力Qwen3-Omni在语音识别与指令跟随任务中达到Gemini-2.5-Pro相同水平。

- 实时音频和音视频交互AuT,Thinker, Talker + Code2wav全流程全流式,支持首帧token直接流式解码为音频输出。

Qwen3-Omni models

- Qwen3-Omni-30B-A3B-Instruct:包含 thinker and talker ,支持音频、视频和文本输入,并可输出音频和文本。

- Qwen3-Omni-30B-A3B-Thinking:包含 thinker ,配备思维链推理功能,支持音频、视频和文本输入,并输出文本。

- Qwen3-Omni-30B-A3B-Captioner:基于 Qwen3-Omni-30B-A3B-Instruct 微调的下游音频细粒度字幕模型,能够为任意音频输入生成细节丰富、低幻觉的字幕。它包含thinker ,支持音频输入和文本输出。

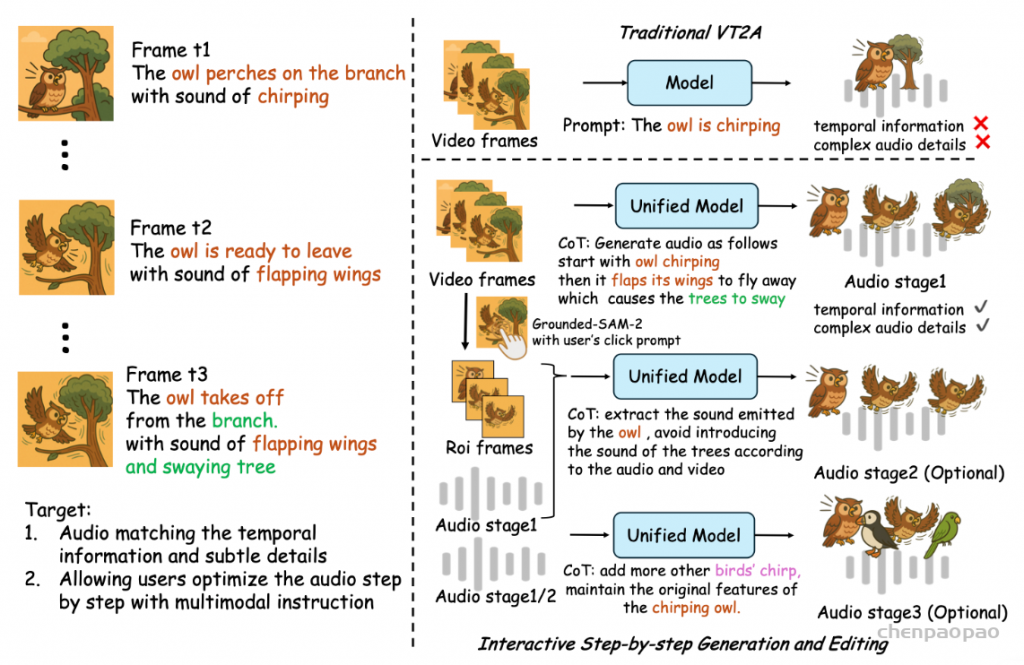

Introduction

当前多模态的训练会出现一种模态的提升伴随着其他模态的退化,该工作探索在当前主流的基于大语言模型(LLM)的范式下实现集成式多模态训练,证明了联合多模态训练可以在所有模态上实现性能均衡,即不存在模态特异性的性能下降,同时显著增强跨模态能力。关键在于:在文本预训练的早期阶段混合单模态和跨模态数据。

关键:在文本预训练的早期阶段混合单模态和跨模态数据。预训练早期的多模态融合允许语言模型与视觉或音频共同训练,而不会导致语言能力下降;文本模态的加入显著提升了视觉和音频的性能,但从视觉或音频信号中并未观察到语言能力的显著提升;从经验来看,加入音频数据可以持续提升视觉模态在 MMMU 基准和 OCR 相关任务上的表现。

Qwen3-Omni 对 Qwen2.5-Omni的架构进行五项关键升级:

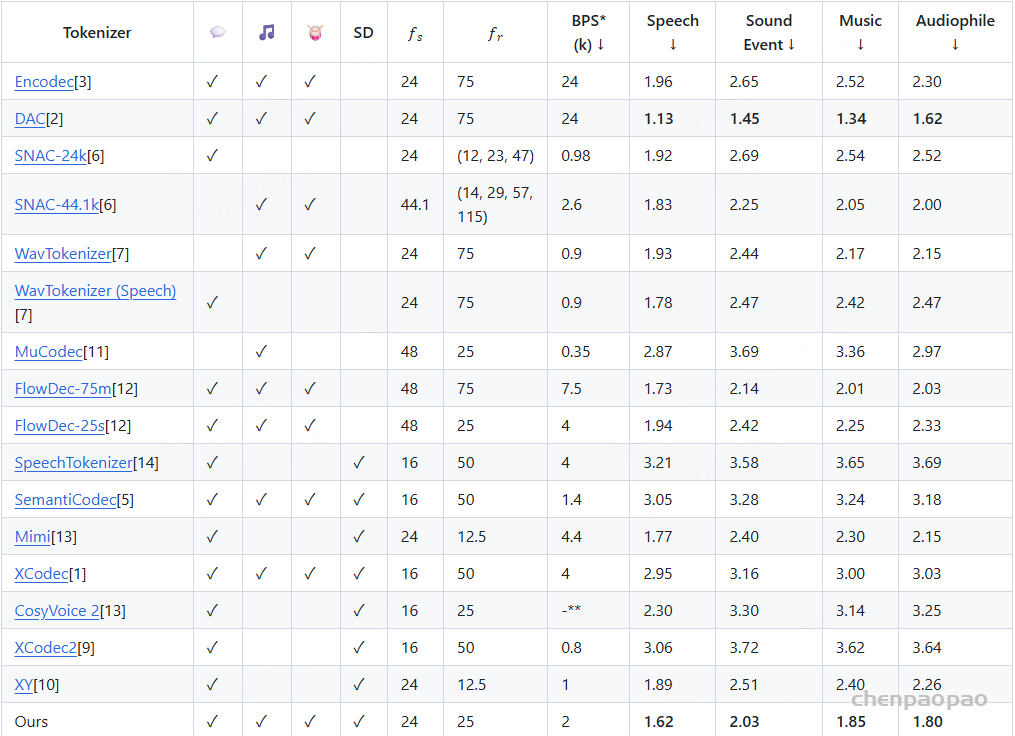

- Thinker 与 Talker 均升级为 MoE(专家混合)结构,提升模型容量与任务适应性。

- 使用自研的 AuT(Audio Transformer)编码器替换Whisper编码器,该编码器在 2000 万小时的有监督音频上从零训练而成,能够提供更强的通用音频表示能力。AuT 使用分块窗口注意力(block-wise window attention),以实现实时的 prefill 缓存。

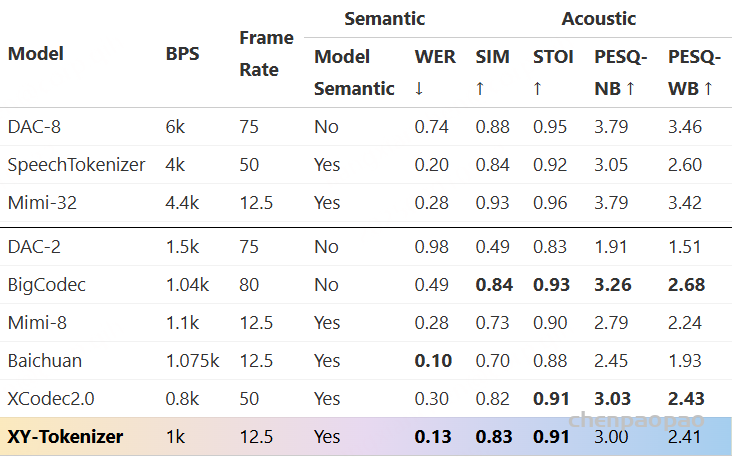

- 在语音生成端,引入多码本表示,其更高的表达容量有助于更真实地建模多样化的音色、超语段要素以及声学现象。

- Talker 从单轨 codec 建模升级为多轨 codec 建模,通过 MTP 模块自回归地预测多个码本层;同时波形生成阶段用轻量级卷积网络(ConvNet)替代了分块式 DiT。

- 输入与输出音频码率均降低至 12.5 Hz,且输出 codec 支持单帧、即时的语音合成。

此外,还有四个大的改进:

- 支持超过 40 分钟的长音频理解;

- 扩展语言覆盖范围:支持 119 种书写语言、19 种口语理解语言,以及 10 种口语生成语言;

- Thinking 模式实现全模态推理,包括音频—视频场景与仅音频场景;

- 流式性能进一步提升,端到端延迟最低可达 234 毫秒。

最核心的是 Qwen3-Omni 在文本与视觉模态上保持了与同规模单模态 Qwen 模型一致的最先进性能,没有出现性能退化。

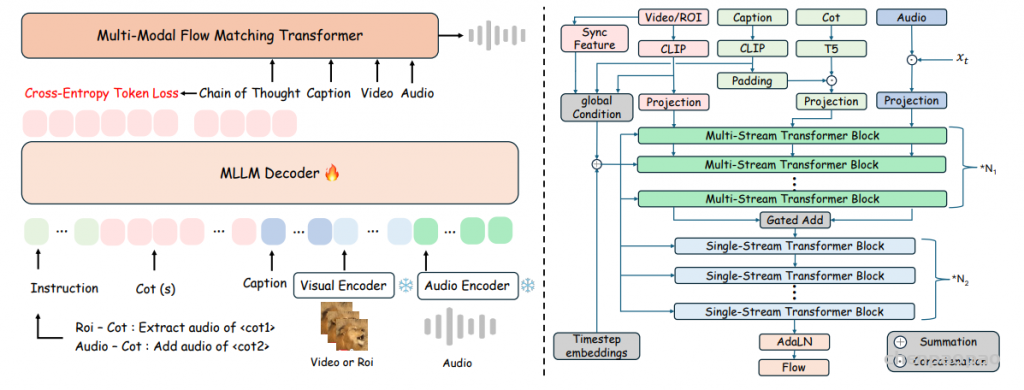

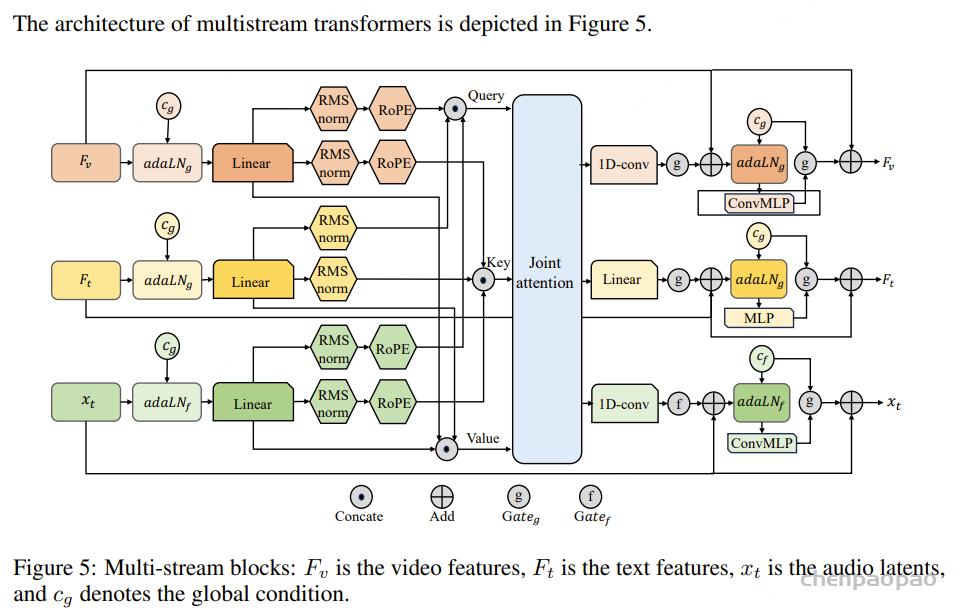

Architecture

- Thinker 与 Talker 均采用 Mixture-of-Experts(MoE)架构,以支持高并发与快速推理。

- Talker 不再只使用 Thinker 的高级文本表征,而是基于音频与视觉的多模态特征进行条件建模。其设计动机如下:

(i) 对于文本内容而言,离散 token 与其 embedding 在信息量上基本等价;

(ii) 多模态条件对于音频–视频协调的语音生成(例如在语音翻译中保持韵律/音色)是必要的。

此外,这种解耦使外部模块(如 RAG、函数调用、安全过滤器)能够对 Thinker 的文本输出进行干预,并在需要时通过受控预处理将文本输入给 Talker,用于流式合成。 - 由于文本表征被解耦,Thinker 和 Talker 可以使用不同的系统提示语(system prompts),从而分别控制 Thinker 的文本响应风格与 Talker 的音频生成风格。

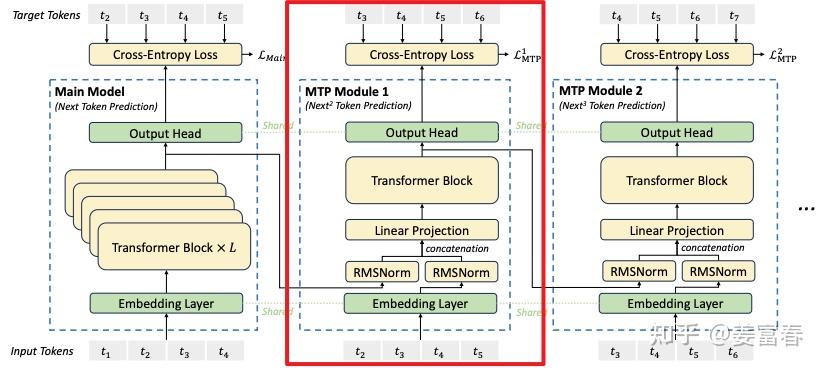

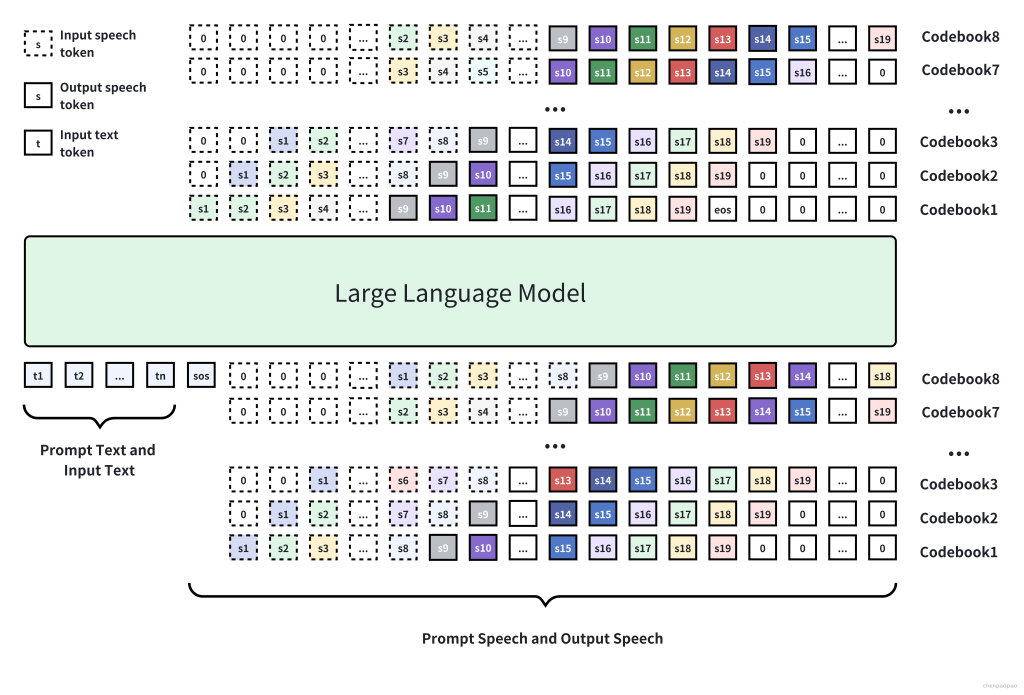

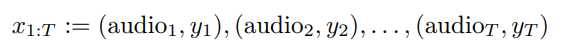

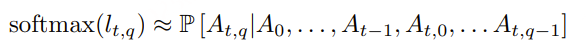

- Talker 采用多码本(multi-codebook)自回归方案:每一步生成一个 codec 帧,剩余的残差码本由 MTP 模块预测完成。

- Code2Wav 以轻量级因果卷积网络(causal ConvNet)实现,简化了音频合成的最终阶段。

在训练和推理过程中,Talker 直接接收来自 Thinker 的高维多模态特征,并共享完整的对话历史。因此,整个系统作为一个整体运行,实现端到端训练与统一推理。

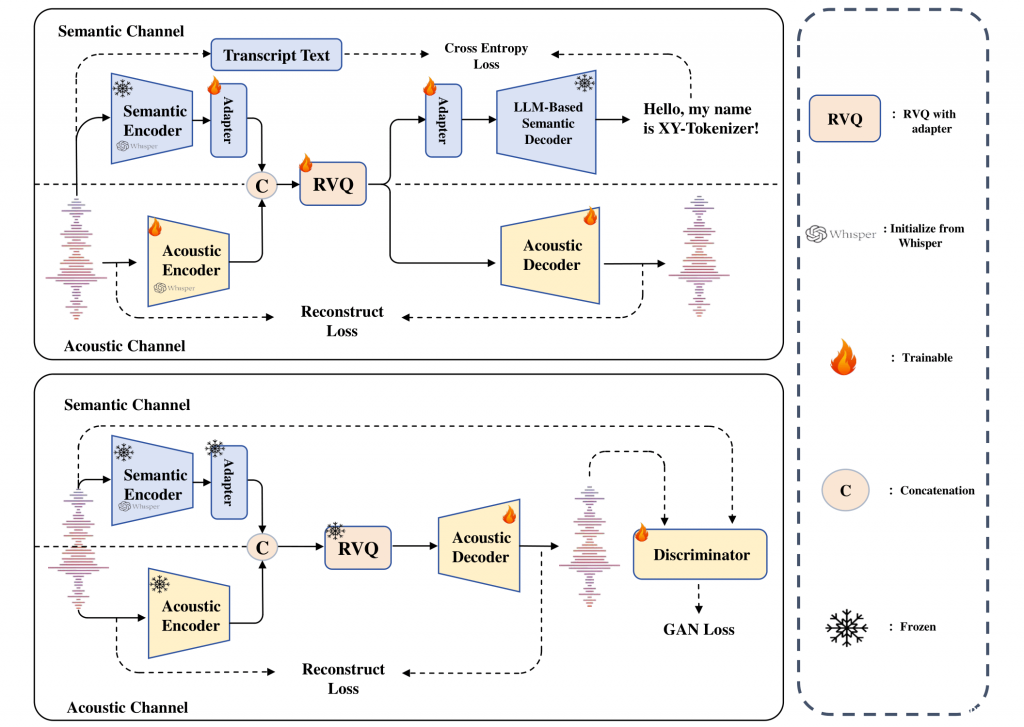

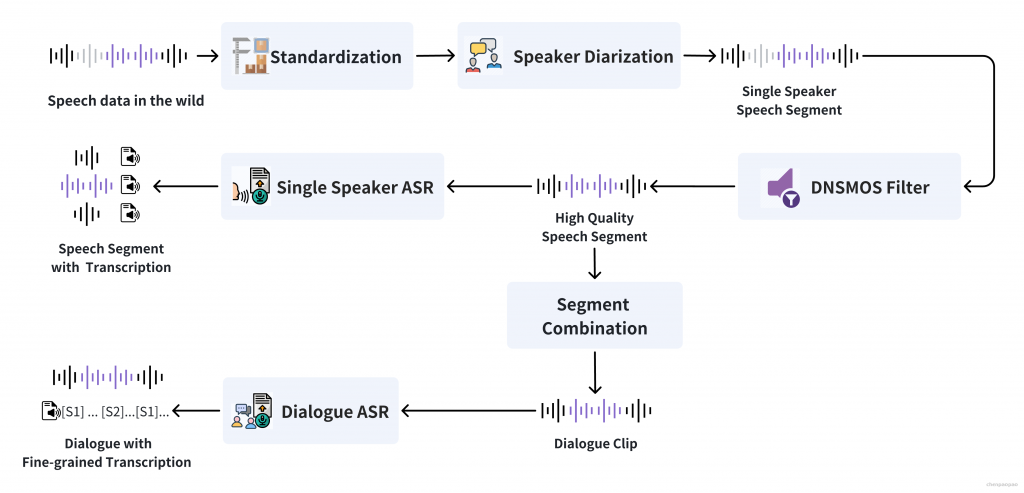

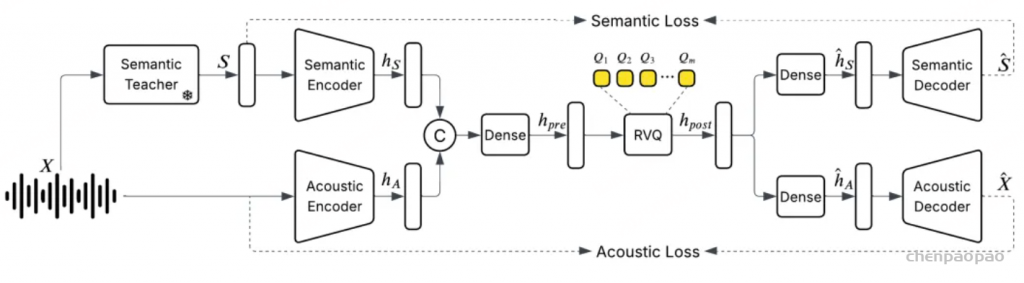

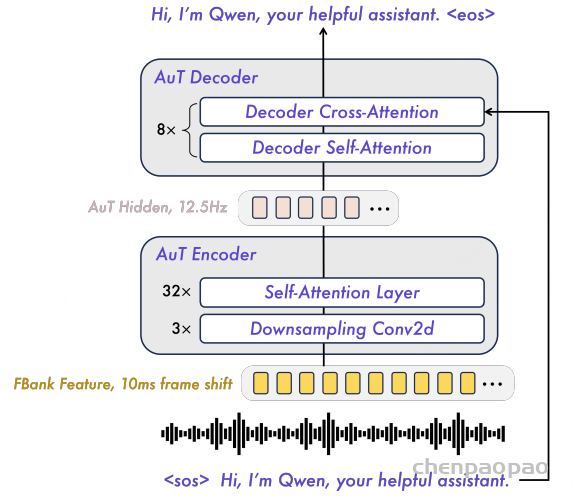

Audio Transformer (AuT)

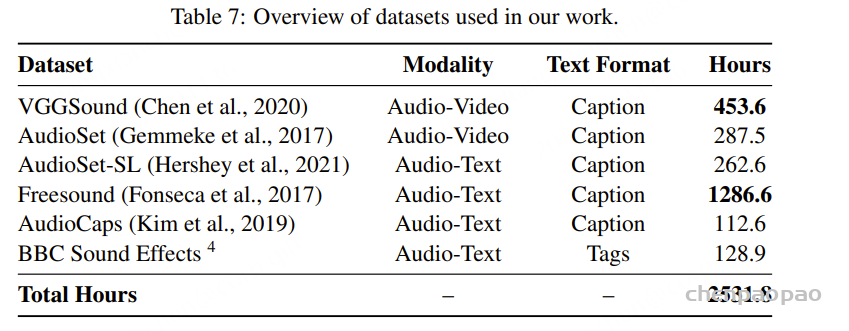

Audio Transformer(AuT)是一种注意力式的 encoder–decoder 模型,如图 3 所示,在 2000 万小时的有监督音频数据上从零训练而成。训练过程中,音频的滤波器组特征(filter bank features)在进入注意力层之前,通过 Conv2D 模块进行 8 倍下采样,将 token 速率降至 12.5 Hz。为了学习更强大、更通用的音频表示,AuT 在大规模音频数据集上进行训练,涵盖语音识别与音频理解任务。具体而言,训练数据组成如下:

- 80% 中文与英文的伪标签 ASR 数据;

- 10% 其他语言的 ASR 数据;

- 10% 音频理解数据。

为在实时 prefill 缓存效率与离线音频任务性能之间取得平衡,AuT 使用具有动态注意力窗口大小的 flash attention,覆盖从 1 秒到 8 秒的注意力查询模式。将 AuT encoder 用作音频编码器,模型参数约为 0.6B

Perceivation (感知)

Text, Audio, Image and Video (w/o Audio).

Thinker 将文本、音频、图像与无音轨视频转换为一系列可作为输入的表征。文本基于Qwen3文本分词器,语音处理为16 kHz,并将原始波形转换为 128 维 Mel 频谱图,通过AUT编码,每一帧音频表示约对应原始音频信号的 80 ms。视频编码器基于Qwen3-VL 的视觉编码器(SigLIP2-So400m),可同时处理图像与视频输入。为了尽可能保留视频信息并与音频采样率对齐,我们采用动态帧率采样视频帧。

Video and Multimodal Position Embedding (TM-RoPE)

参考Qwen2.5-Omni,使用 时间对齐的多模态旋转位置编码(TM-RoPE),它在多模态旋转位置编码(M-RoPE)基础上加入了绝对时间信息。TM-RoPE 将传统旋转位置编码分解为三个维度:

- 时间维(temporal)

- 高度维(height)

- 宽度维(width)

在原始 M-RoPE 中,时间相关性由前 16 个旋转角建模,这些角对应高频且震荡更强的模式。该设计有利于捕获局部时间变化,但会影响模型对长序列的外推能力。

为解决这一问题,我们重新分配了旋转角数量:

- 时间维 24 个

- 高度维 20 个

- 宽度维 20 个

该分配在局部语义与长程依赖之间实现了更平衡的表示,从而提升整体性能。

TM-RoPE 会根据输入模态的不同进行定制化应用:

- 文本模态:三个维度共享相同的位置 ID,使 TM-RoPE 等价于一维 RoPE。

- 音频模态:同样共享位置 ID,并额外加入绝对时间编码,每个时间 ID 对应 80 ms。

- 图像模态:所有视觉 token 分配相同的时间 ID,而其行列位置分别决定高度与宽度的 ID。

对于音视频输入:

- 音频:每 80 ms 分配一个时间 ID;

- 视频:每帧视频根据其真实时间戳分配 递增的时间 ID,动态调整以确保与音频保持 80 ms 分辨率对齐。

- 视频的高度与宽度 ID 与静态图像保持一致。

为避免多模态之间的位置冲突,所有模态的位置编号保持连续,每种模态的起始位置 ID 为前一种模态最大位置 ID 加一。该精细化的位置编码方案使模型能够有效整合并联合建模多模态信息。

相较 Qwen2.5-Omni 的关键区别:不同于 Qwen2.5-Omni 将音视频表示强制切分为固定的 2 秒块,Qwen3-Omni 直接基于绝对时间的时间 ID 对齐多模态表示。这种设计赋予模型处理任意时长流式输入的灵活性。

Speech Generation

在多轮对话的语音合成中,Talker 模块依赖于由 Thinker 组件提供的丰富上下文,该上下文包括历史文本 token、多模态表示以及当前轮的流式文本。对长上下文信息的依赖至关重要,因为高保真语音合成需要根据当前对话动态调整声学属性,如韵律、响度和情感,这一原则在上下文感知生成模型中已被充分验证。

在架构上,直接在 RVQ token 上进行操作。Talker 采用层次化预测策略:骨干网络(backbone)输入当前帧的聚合码本特征,并通过线性头预测第零码本,随后多 token 预测(MTP)模块生成所有剩余码本。这一策略使模型能够学习声学细节的完整表示,从而增强语音的表现力。因此,波形重建被简化为轻量级因果卷积网络(Code2Wav),在显著降低推理延迟和计算开销(FLOPs)的同时,相比更复杂的基于 DiT 的声码器实现了更高的音频保真度。

流式与并发设计

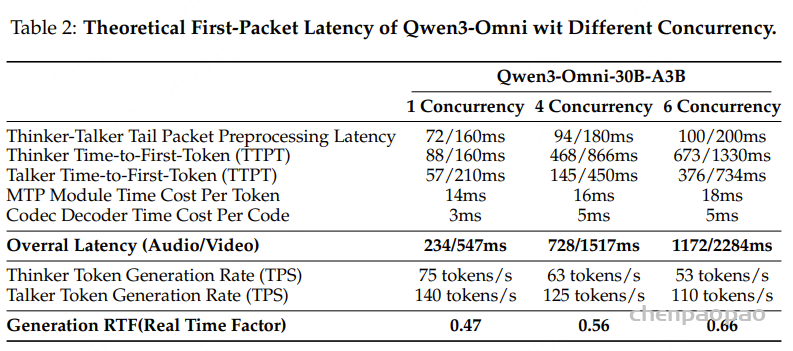

在流式视听交互场景中,首包延迟是影响用户体验的关键因素,而模型的并发能力对于降低服务成本和提高响应速度至关重要。下面是 Qwen3-Omni 如何通过算法与架构优化提升并发性并降低首包延迟。

分块预填充与 MoE 架构。在 Qwen3-Omni 中,保留了 Qwen2.5-Omni 中的分块预填充机制,其音频和视觉编码器能够沿时间维度输出分块(chunk)。在实时交互中,Thinker 和 Talker 模块执行异步预填充:当 Thinker 完成当前块的预填充后,其输出的高层表示会立即异步用于预填充 Talker 的当前块,同时 Thinker 预填充下一块。这种方法显著降低了 Thinker 和 Talker 的 Time-To-First-Token (TTFT)。

在架构上,Qwen3-Omni 的 Thinker 与 Talker 均采用 MoE设计,这对于提升服务吞吐量非常有效。与稠密模型相比,MoE 架构在处理长序列时显著降低了 KV 缓存带来的 IO 消耗,从而提高生成过程中的每秒 token 数(TPS)并增强并发性能。

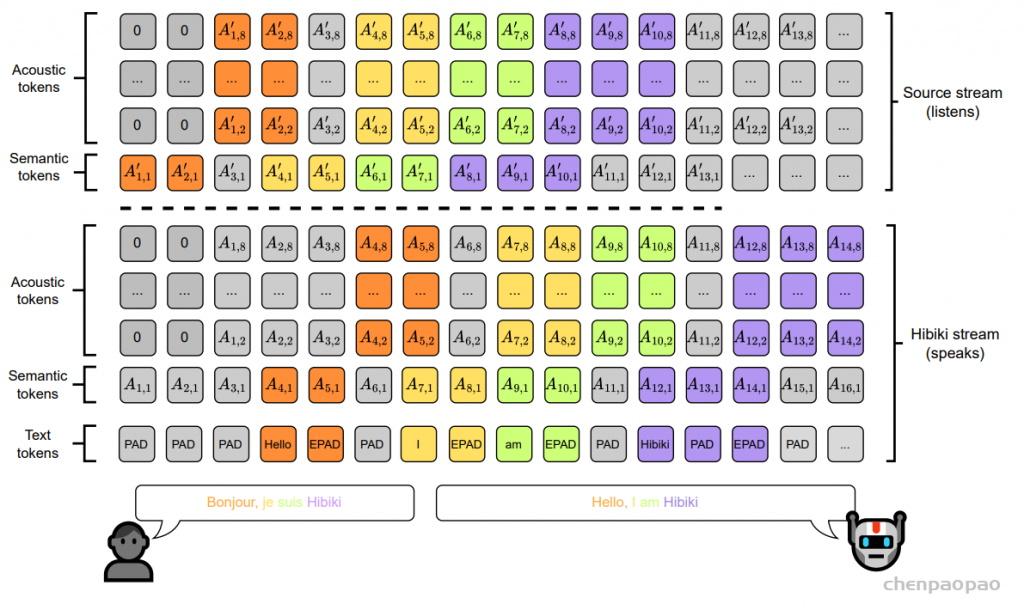

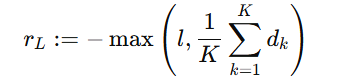

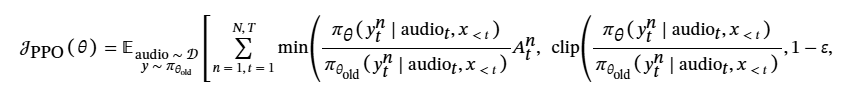

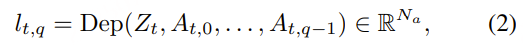

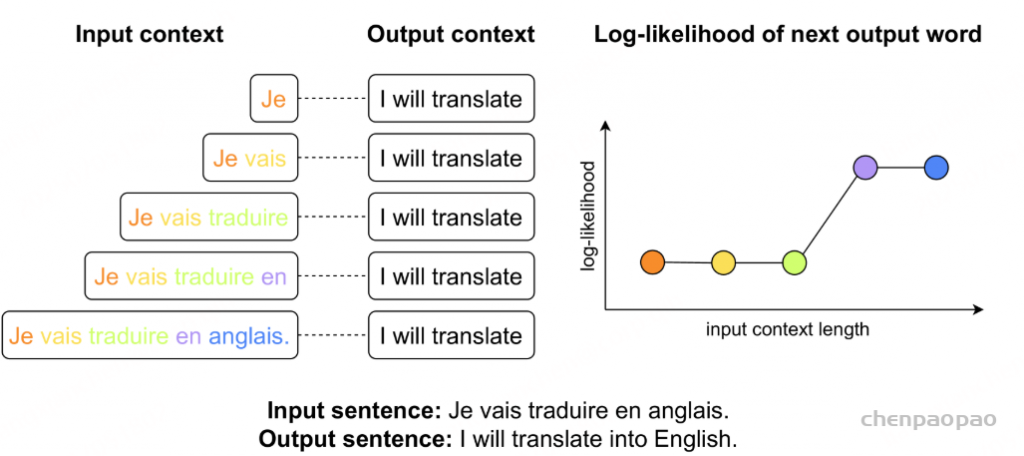

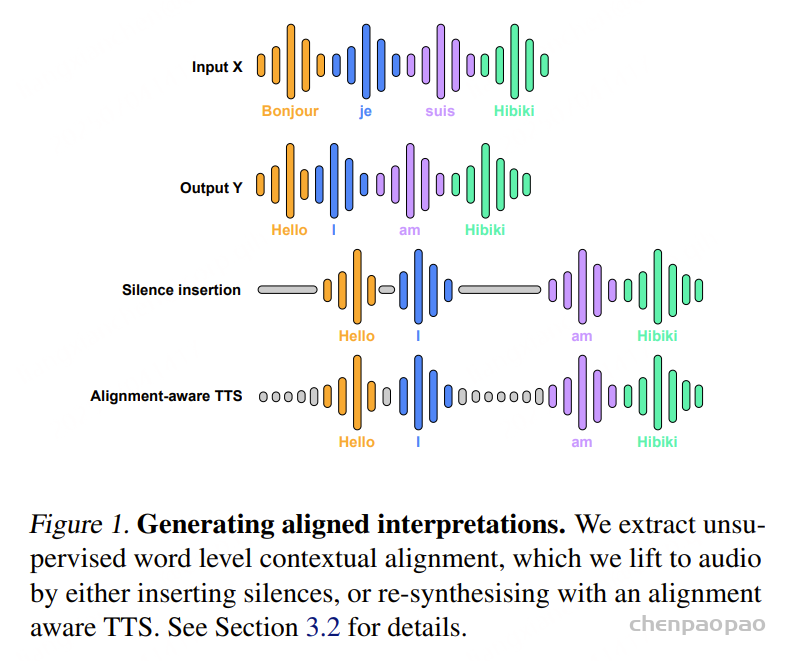

流式多码本编解码生成:为了最小化用户接收首个生成包的等待时间,提出了仅左侧上下文的多码本生成机制。如图 2 所示,一旦 Talker 生成第一个 token,MTP 模块即可预测当前帧的剩余 token,然后由流式多码本编解码器将其解码为波形,该编解码器仅关注左侧上下文。与 Qwen2.5-Omni 需要等待 Talker 生成足够块级上下文才能合成波形不同,Qwen3-Omni 在 Talker 生成每个 token 后即可输出波形,从而显著降低首包延迟。

轻量级 MTP 模块与 ConvNet:MTP 模块和编解码器均为轻量级模块,计算 FLOPs 低,支持批处理推理,非常适合高并发场景。MTP 模块是超轻量级、固定步长的自回归稠密 Transformer,在推理硬件上对内存带宽要求低,从而天然支持高吞吐量请求的批处理。其固定步长自回归推理机制允许高效利用固定 KV 缓存空间加速,实现低延迟推理。同时,基于 ConvNet 的编解码器也能在低延迟下实现高吞吐量,因为其卷积架构在多种推理平台上均有广泛硬件加速支持,并且支持高效的批处理推理。

表 2 给出了 Qwen3-Omni 在典型计算资源下,不同并发场景下的理论首包延迟(first-packet latency)。实验在 vLLM 框架上进行,用于处理并发的视听流,同时对 MTP 模块和编解码器采用了 torch.compile 和 CUDA Graph 加速优化。

首包延迟受到多个因素影响:

- Thinker 与 Talker 的模型规模会影响尾包预处理延迟(包括音频和视觉编码器的多模态数据预处理和推理)以及 Time-To-First-Token (TTPT)。

- MTP 模块与编解码器的架构与规模会影响它们的推理延迟。

由于这些组件之间存在顺序依赖,总体首包延迟是各个延迟的累加。结果显示,Thinker 和 Talker 的 MoE 架构 能确保在高并发下,其预填充延迟和 TTPT 基本不受影响。同时,MTP 模块和编解码器的轻量化设计最小化了计算开销,对首包延迟的影响也很小。

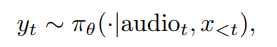

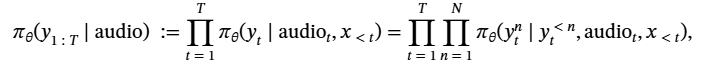

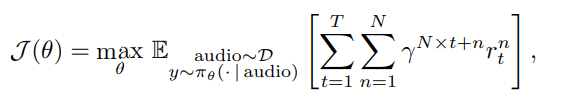

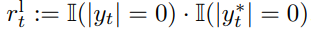

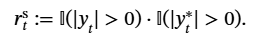

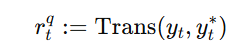

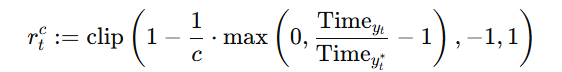

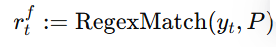

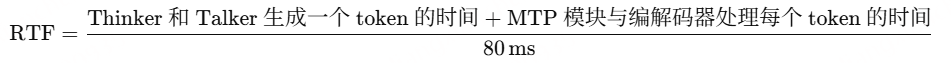

此外,在输出首个数据包后,模型开始进行流式音频合成,由于 Talker 的 token 生成速率为 12.5 Hz,每个 token 即可合成 80 ms 的音频。因此,生成实时因子(RTF)通过以下公式计算:

实验结果表明,RTF 在不同并发水平下始终低于 1,确保用户能够持续接收流式音频响应

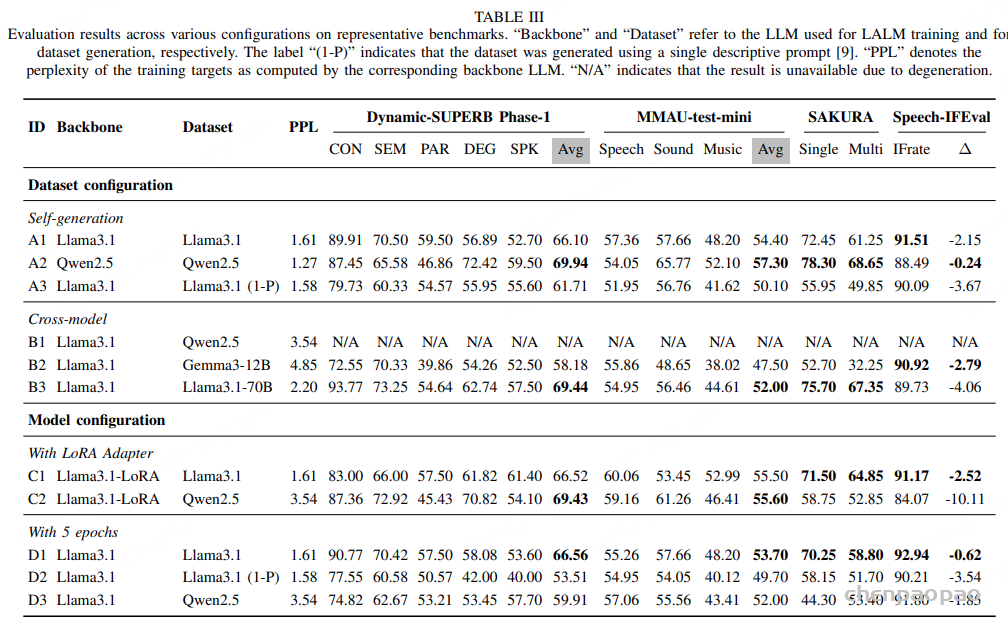

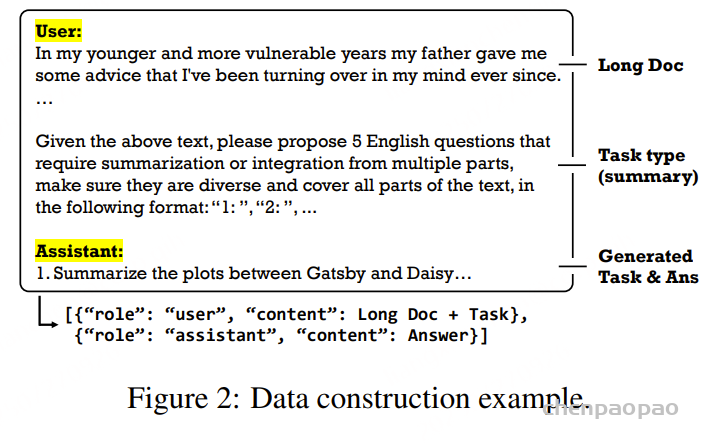

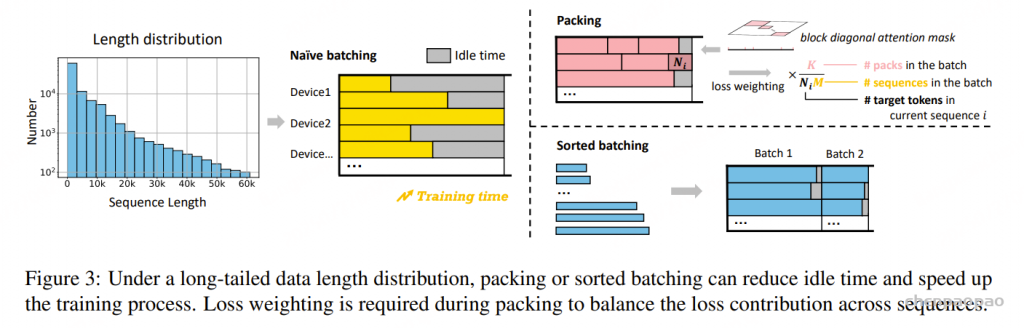

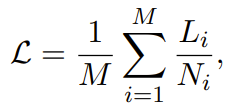

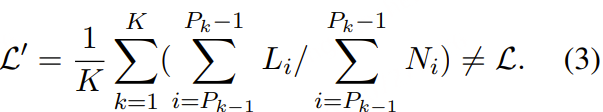

Pretraining

Qwen3-Omni 在一个多样化的数据集上进行预训练,该数据集涵盖多种语言和方言(如表 3 所示)以及多种模态,包括图文、视频文本、音频文本、视频音频、视频音频文本以及纯文本语料库。与 Qwen2.5-Omni 使用每个任务单一提示词不同,我们采用更丰富的自然语言提示,以增强模型的泛化能力和指令遵循能力。为了在所有模态下实现稳健性能,训练策略从早期预训练阶段就整合了单模态和跨模态数据。

Qwen3-Omni 的预训练分为三个阶段:

- 编码器对齐阶段:音频和视觉编码器在固定的 LLM 上单独训练,最初重点训练各自的 adapter,随后再训练编码器本身。不采用在冻结 LLM 的情况下联合训练编码器与 adapter 的方法,因为该方法可能导致编码器过度补偿冻结 LLM 的限制,从而降低感知能力。

- 通用阶段:使用了一个大规模数据集,约含 2 万亿 token,其中文本:0.57 万亿、音频:0.77 万亿、图像:0.82 万亿、视频:0.05 万亿、视频-音频:0.05 万亿。在此阶段,引入更多样化的多模态数据和任务,增强了模型在听觉、视觉、文本及视听信息上的理解与交互能力。

- 长上下文阶段:最后,将最大 token 长度从 8,192 提升至 32,768,并增加了训练数据中长音频和长视频的比例。实验结果表明,这些调整显著提升了模型对长序列数据的理解能力。

后训练

Thinker

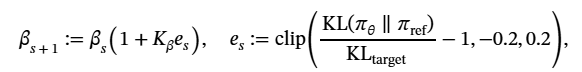

后训练阶段包括对 Thinker 的三阶段训练,使 Qwen3-Omni 具备指令遵循能力。训练数据集采用 ChatML格式,涵盖纯文本对话、视觉模态对话、音频模态对话以及混合模态对话数据。

第一阶段:轻量化监督微调(SFT)

通过有针对性的指令优化,将预训练表示与下游任务需求进行桥接。SFT 有意偏离预训练数据结构,但保持与预训练模型的架构一致,以实现高效的知识迁移,同时保留预训练特征的完整性。

第二阶段:强对弱蒸馏(Strong-to-Weak Distillation)采用 Qwen3中描述的蒸馏流程,包括两个阶段:

- 离策略蒸馏(Off-policy Distillation):初期阶段,教师模型生成的输出被整合,用于响应蒸馏。这帮助轻量学生模型掌握基础推理能力,为后续的在线训练奠定基础。

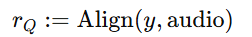

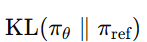

- 在线蒸馏(On-policy Distillation):学生模型根据采样提示生成响应序列,随后进行微调,将学生预测的 logits 与教师模型(Qwen3-32B 或 Qwen3-235B-A22B)的 logits 对齐,通过最小化 KL 散度进行优化。

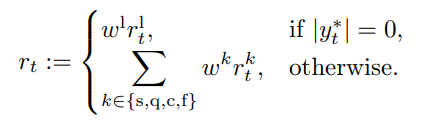

第三阶段:GSPO 强化,利用 GSPO全面提升模型在文本、图像、视频和音频等多模态上的能力和稳定性。针对不同模态使用两类奖励信号:

- 规则基奖励(Rule-based Reward):用于可验证的多模态任务(如数学、编码、指令遵循),奖励信号源自预定义规则,可高精度评估模型输出的正确性,避免奖励漏洞(reward hacking)。

- 模型基奖励(Model-based Reward):用于缺乏客观评价指标的多模态任务,采用 LLM 作为评估者(LLM-as-a-judge)协议。通用任务由 Qwen3 担任评估,视觉-语言任务由 Qwen2.5-VL 担任评估。评估过程中,LLM 可获取对应的真实答案或参考答案,以实现更稳健、可靠的评价。

Talker

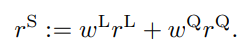

对 Talker 采用四阶段训练,使 Qwen3-Omni 能够同时生成文本与语音响应。训练数据统一采用 ChatML 格式,确保与 Thinker 的一致性。

- 第一阶段:使用数亿条带多模态上下文的语音数据训练 Talker,建立从多模态表示到语音的单调映射关系。

- 第二阶段:进行高质量数据的持续预训练(Continual Pretraining, CPT),缓解第一阶段噪声数据导致的幻觉问题,显著提升语音生成质量。同时进行长上下文训练,增强 Talker 处理长复杂输入并生成语境适配语音的能力。

- 第三阶段:构建多语言语音偏好对(preference pairs),通过 直接偏好优化(Direct Preference Optimization, DPO)提升多语言语音生成的泛化能力和系统稳定性。

- 第四阶段:对基模型进行说话人微调(speaker fine-tuning),使 Talker 可以采用特定声音,并优化语音自然度、表现力和可控性。

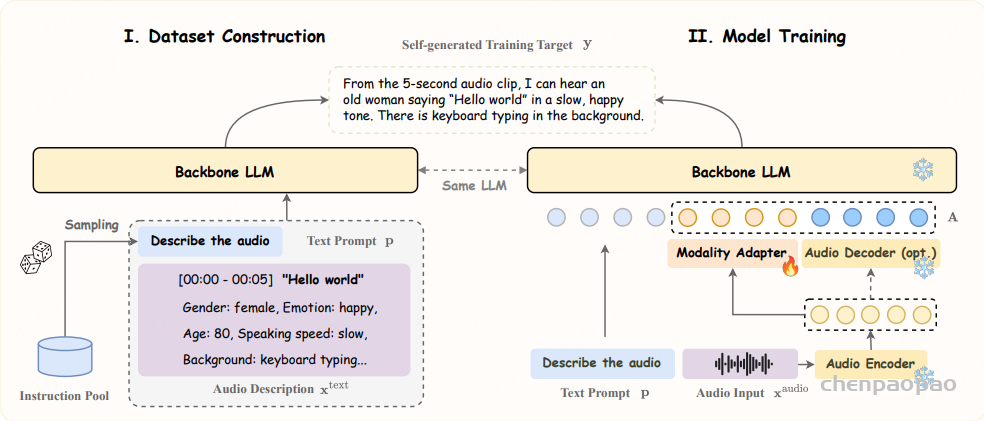

Captioner

字幕生成是多模态理解的基础任务,也是大型多模态模型训练与评估的重要组成部分。然而,现有研究大多集中在视觉字幕生成,较少关注音频模态,而听觉感知是人类感知与交互的重要组成。为弥补这一空白并推动多模态感知研究,我们提出 Qwen3-Omni-30BA3B-Captioner。该模型通过在大规模音频描述数据集上微调 Qwen3-Omni-30B-A3B 得到,可为任意音频输入生成详细、低幻觉的字幕。

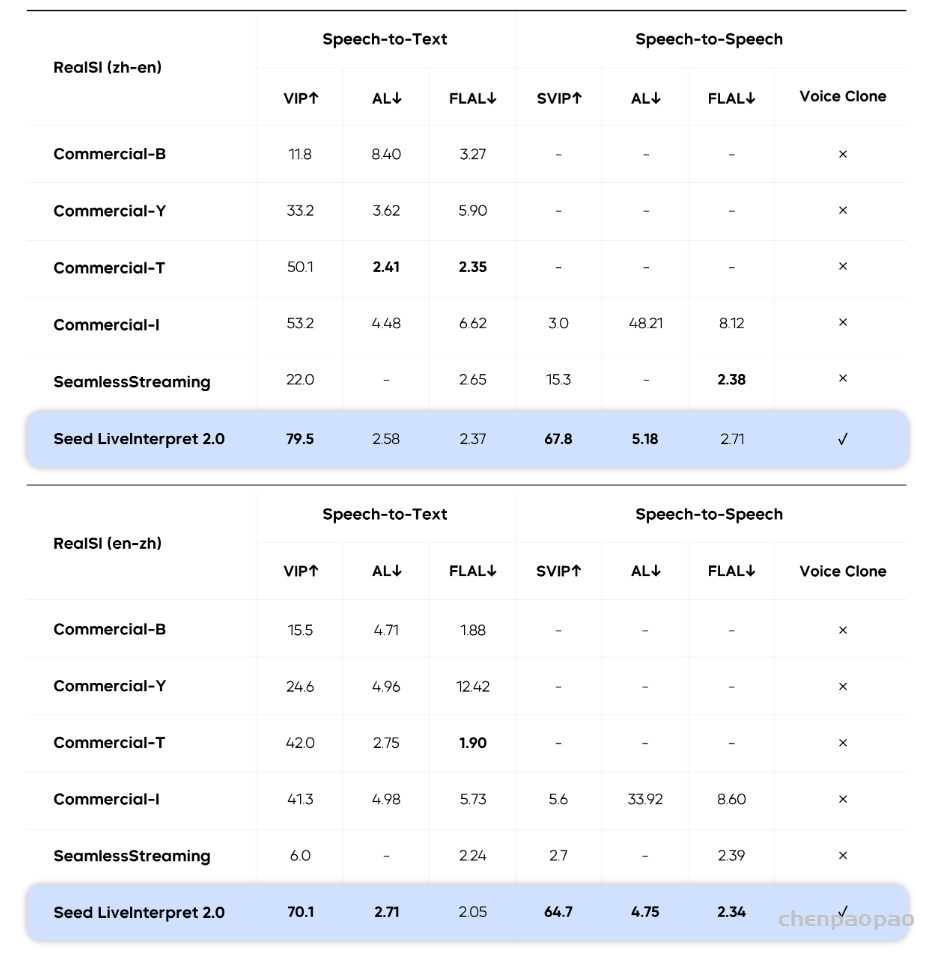

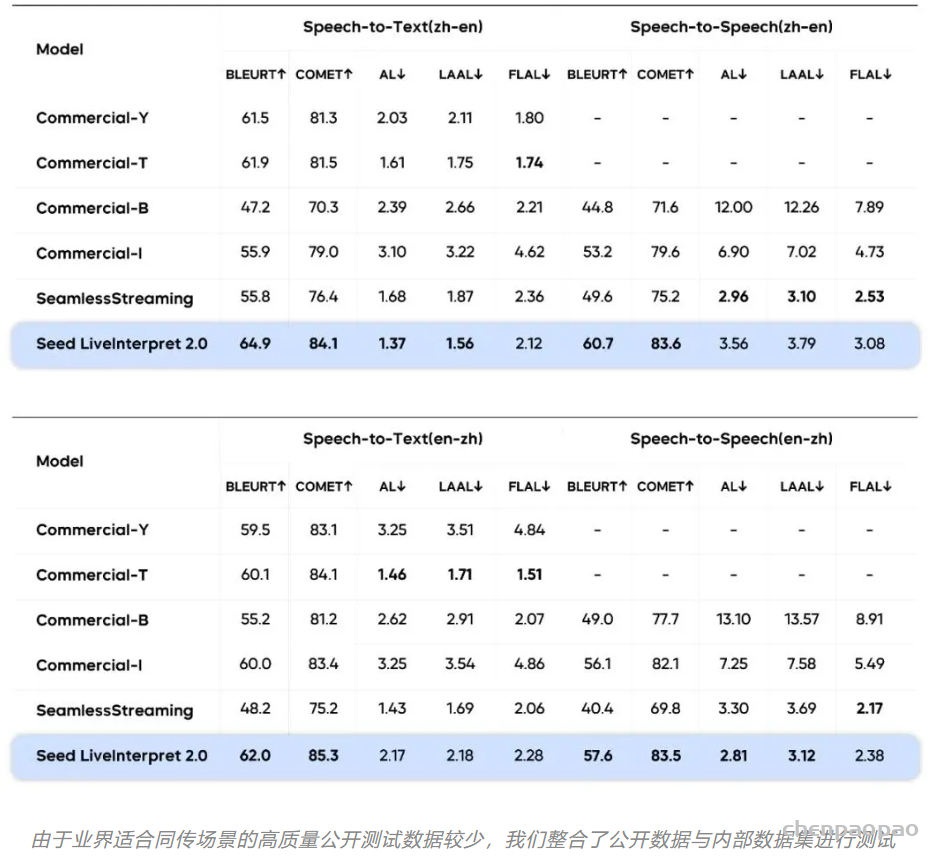

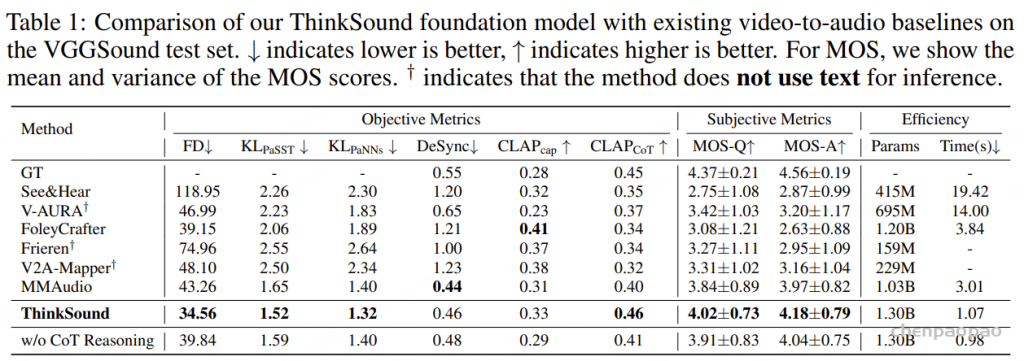

Evaluation

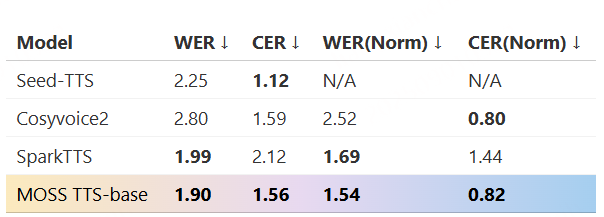

对一系列模型进行了全面评估,包括 Qwen3-Omni-30B-A3B-Instruct、Qwen3-Omni-30B-A3B-Thinking 以及两款内部开发的变体 Qwen3-Omni-Flash-Instruct 和 Qwen3-Omni-Flash-Thinking。这些 “Flash” 模型旨在提升计算效率和性能,同时引入新功能,尤其是对多方言的支持。评估结果分为两大类:理解能力(X→Text) 和 语音生成能力(X→Speech)。

X→Text 评估

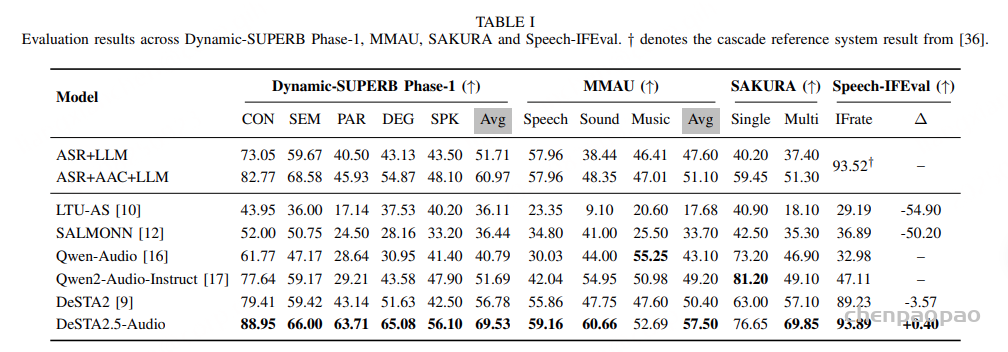

Qwen3-Omni 理解各种多模态输入(文本、音频、视觉以及视听视频)并生成文本响应的能力。

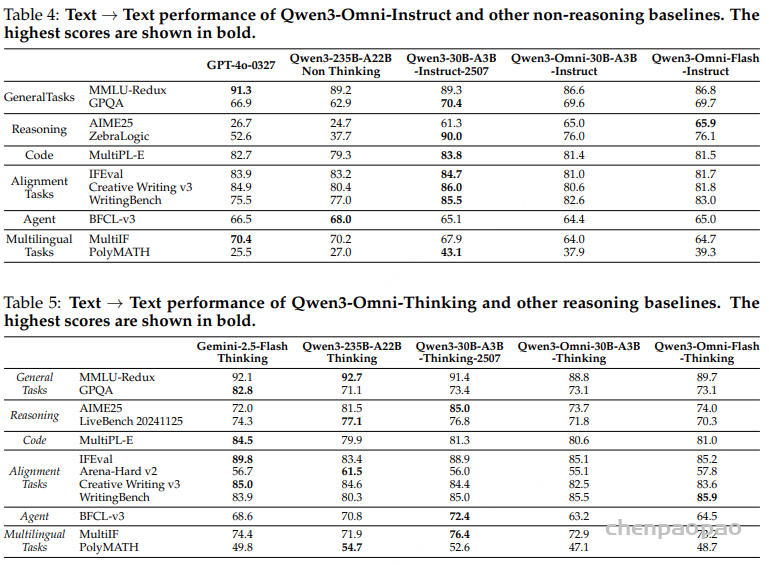

文本→文本:评估通用任务、推理能力、编码能力、对齐任务、代理(Agent)以及多语言任务。

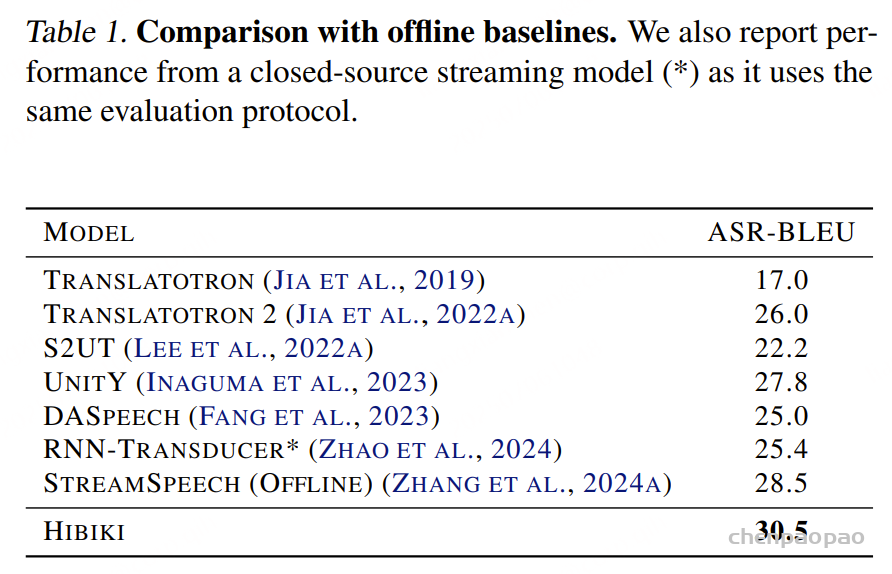

- 表4 :Qwen3-Omni-30B-A3B-Instruct 的性能在多个基准任务中超过 了更大的开源模型 Qwen3-235B-A22B Non-Thinking 以及强大的闭源模型 GPT-4o-0327

- 表5:Qwen3-Omni-30B-A3B-Thinking 的表现与 Gemini-2.5-Flash-Thinking 以及Qwen3-235B-A22B Non-Thinking 接近。

- Qwen3-Omni-30B-A3B 在文本任务中的表现也与其对应的纯文本模型版本保持一致,包括:Qwen3-30B-A3B-Instruct-2507、Qwen3-30B-A3B-Thinking-2507

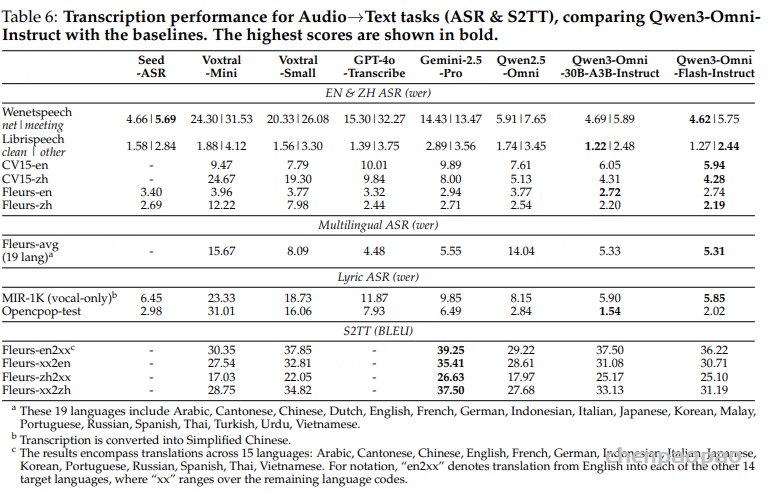

音频→文本:分为基础音频任务和高级音频任务两类。基础任务包括自动语音识别(ASR)、语音转文本(S2TT)以及音乐理解;高级任务包括语音聊天和音频推理。另外,还评估模型在各种音乐信息检索任务上的能力,如流派识别、情感与主题识别、乐器识别以及音乐关键词标注。

表 6 所示,Qwen3-Omni-Instruct 在 Librispeech、Wenetspeech、Fleurs、CommonVoice、Opencpop-test 以及 MIR-1K(vocal)等数据集上取得了英语与中文 ASR 以及歌词识别的最新最优性能(SOTA)。在多语言 ASR 和 S2TT 任务上,Qwen3-Omni 的表现同样优于或可与其他专业模型或通用模型(如 Voxtral-Small 和 Gemini-2.5-Pro)媲美。这些结果表明 Qwen3-Omni 在语音识别与语音翻译任务上具备非常强的能力。

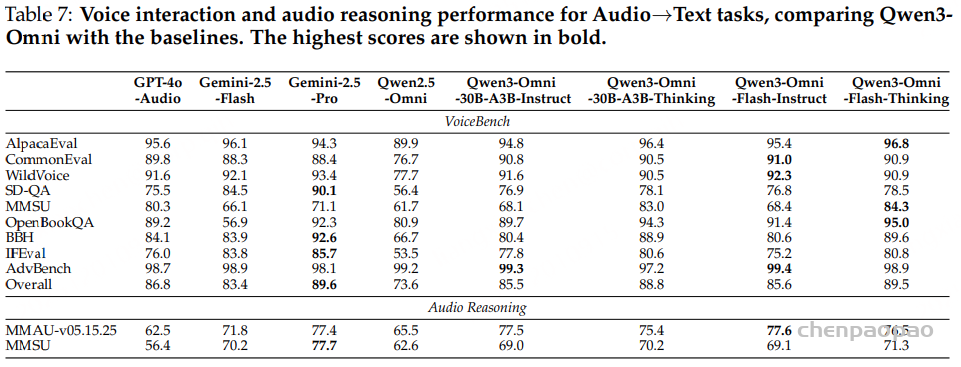

此外,如表 7 所示,Qwen3-Omni-Thinking 在 VoiceBench 上取得了 89.5 的平均得分,超过了除 Gemini-2.5-Pro(89.6)之外的所有其他音频大模型,展现出优秀的语音交互能力。

在音频推理方面,Qwen3-Omni 同样表现突出:在 MMAU 基准上超越了强大的闭源模型 Gemini-2.5-Pro 与 Gemini-2.5-Flash,在 MMSU 上超过了 Gemini-2.5-Flash 和 GPT-4o-Audio。

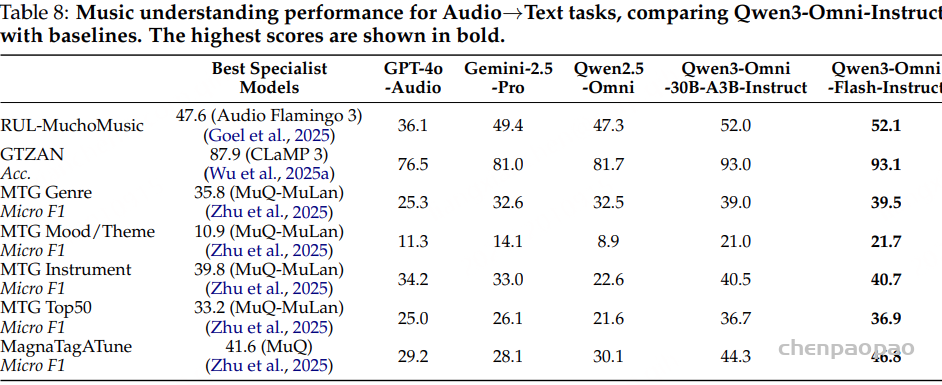

表 8 中将 Qwen3-Omni-Instruct 与通用音频语言模型和专业音乐模型进行了比较。Qwen3-Omni-Instruct 在 RUL-MuchoMusic 上取得了最新最优(SOTA)表现。在 GTZAN、MTG-Jamendo 以及 MagnaTagATune 上,Qwen3-Omni-Instruct 的得分也显著超过了其他音频语言模型(包括 Gemini-2.5-Pro 和 GPT-4o-Audio),并超过了在这些数据集上测试的多种自监督音乐专业模型。

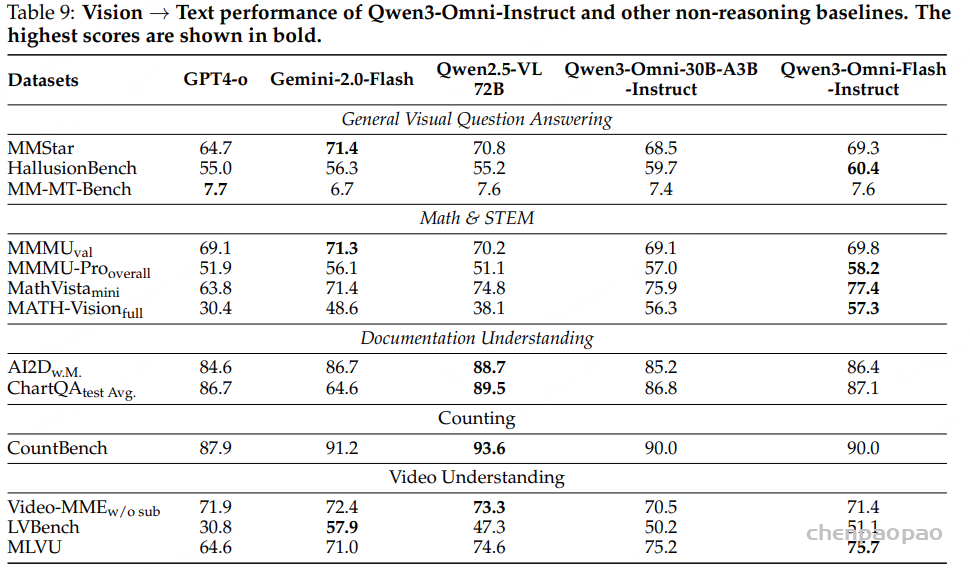

视觉→文本:通用视觉问答能力、数学与 STEM 推理能力、文档理解能力、数值推理与计数能力、动态视觉数据理解能力。将 Qwen3-Omni-Instruct 与 Qwen2.5-VL-72B 以及其他表现优异的闭源视觉语言模型进行了对比。如表 9 所示,Qwen3-Omni-Instruct 的整体表现与 Qwen2.5-VL-72B 相当,并且在 数学与 STEM 相关任务(如 MMMU-Pro overall、MathVista mini、MATH-Vision full)上取得了优于 GPT-4o 和 Gemini-2.0-Flash 的成绩。

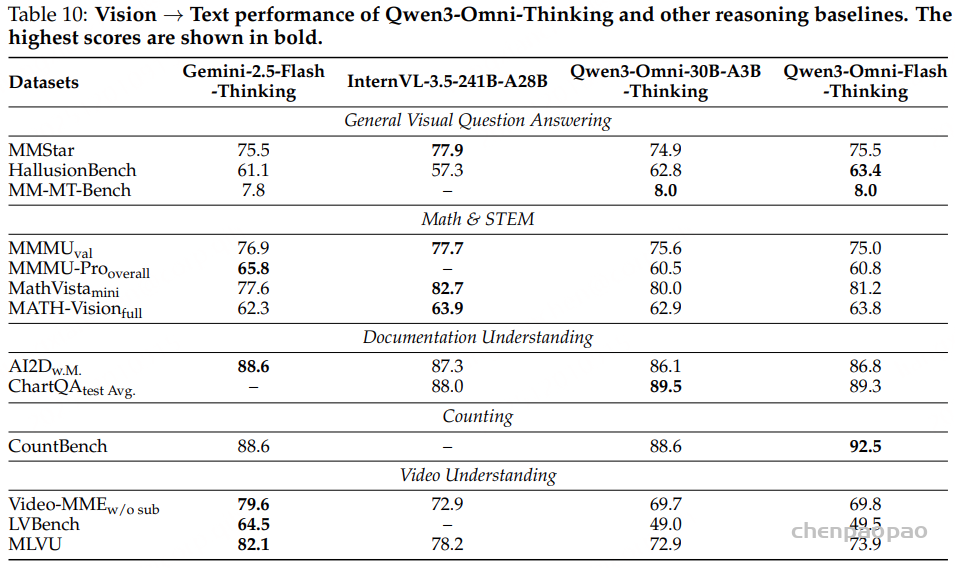

Qwen3-Omni-Thinking 与多种最先进推理模型进行了比较。

表 10 的结果显示,我们提出的模型取得了显著的性能提升。例如,在 数学与 STEM 基准 上,它比 Qwen3-Omni-Instruct 基线提升了 4.4 个点。

值得注意的是,Qwen3-Omni-30B-A3B-Thinking 的性能已经可与规模更大的模型相媲美,展现了在 性能与计算效率之间的优秀平衡。

然而,该模型仍存在一个限制:在 长视频任务 上表现不佳。原因:1、位置外推能力有限(positional extrapolation)2、上下文长度受限

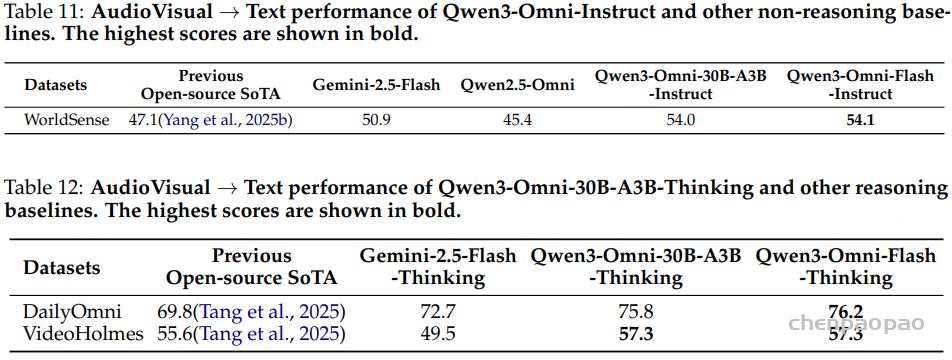

音视频→文本:在 WorldSense 进行基准测试以及两个视听推理基准进行测试。在 通用理解任务 中,Qwen3-Omni-Instruct 在 WorldSense 基准上实现了当前最佳性能,并以显著优势超越了其他 Omni 模型。该结果表明其在基础多模态信息融合方面具有卓越能力。

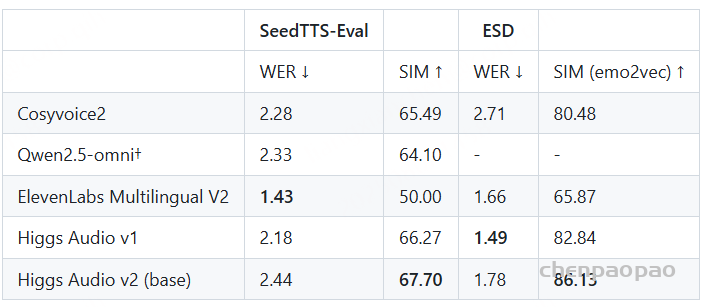

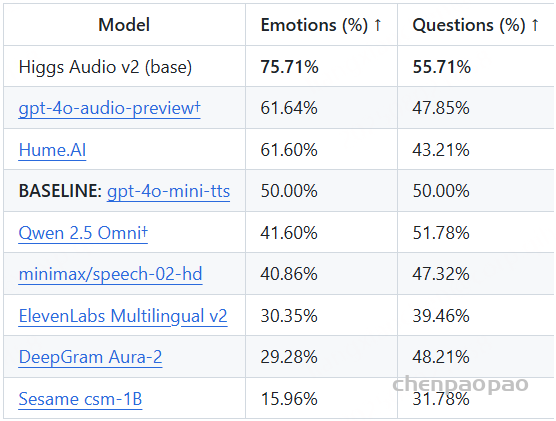

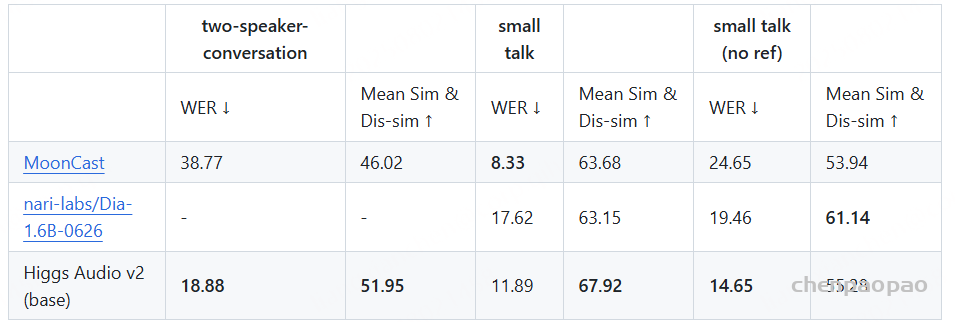

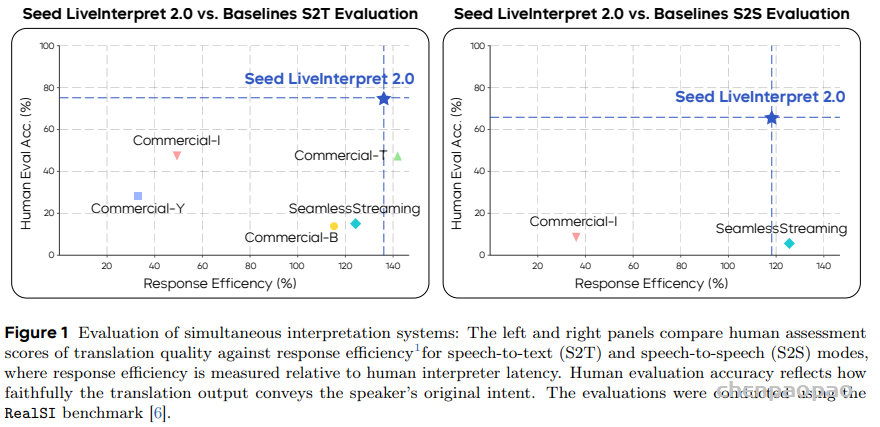

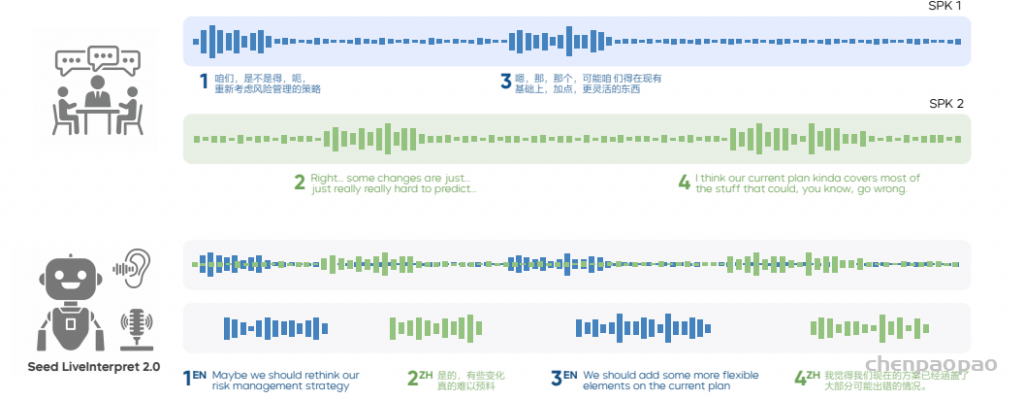

X→Speech 评估

评估主要集中在给定文本条件下的语音生成,即与文本到语音(TTS)任务的相似性,评估内容包括以下三个方面:

- 零样本语音生成:内容一致性(WER,字错误率)和说话人相似性(SIM)方面的表现

- 多语言语音生成:评估模型在零样本条件下生成多语言语音的内容一致性与说话人相似性。

- 跨语言语音生成:评估模型在零样本条件下进行跨语言语音生成的内容一致性。

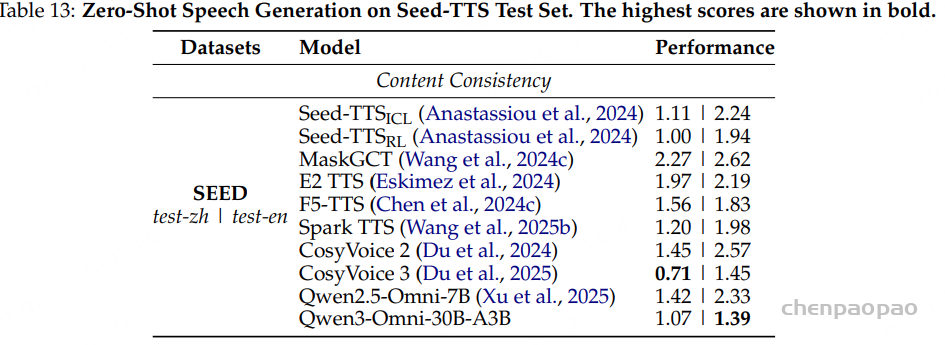

零样本语音生成:

如表 13 所示,Qwen3-Omni 展现了 高度竞争力的性能,凸显了其通过预训练及持续预训练所获得的稳健语音理解与生成能力。此外,通过 强化学习(RL)优化,Qwen3-Omni 在语音生成的稳定性方面也取得了显著提升,并在 test-en 数据集上达到了最佳性能。

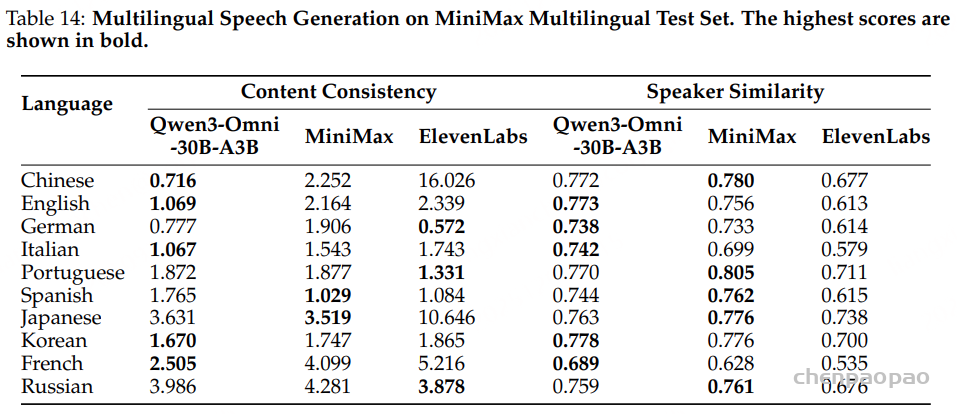

多语言语音生成:

Qwen3-Omni 支持跨 10 种语言 的语音生成。我们将其性能与 MiniMax-Speech 和 ElevenLabs Multilingual v2 模型在多语言语音生成任务上进行了对比。

如表 14 所示,Qwen3-Omni 在 中文、英文和法语 等语言上显著超越了其他模型,并在其余语言中取得了具有竞争力的结果。

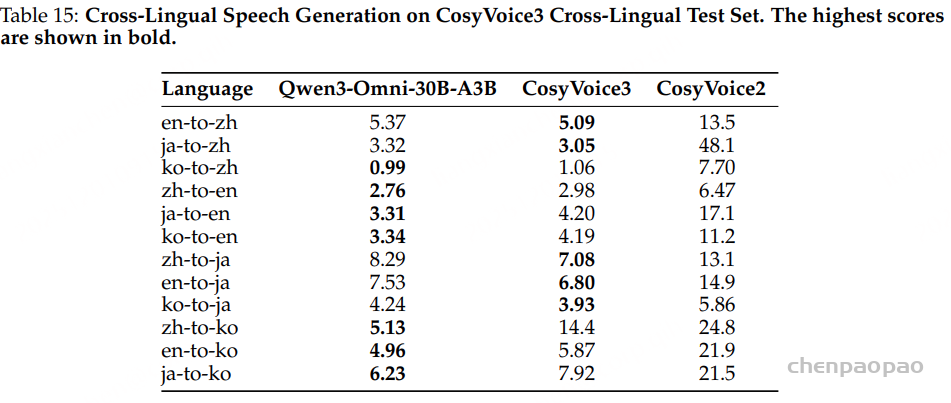

跨语言语音生成评估:Qwen3-Omni 在 any-to-en(任意语言到英语) 和 any-to-ko(任意语言到韩语) 的语音克隆任务中均优于 CosyVoice3。在 any-to-ja(任意语言到日语) 任务中,即便 未进行文本规范化,Qwen3-Omni 仍能达到与 CosyVoice3 相当的性能,而 CosyVoice3 会将所有日语字符转换为假名(kana)。

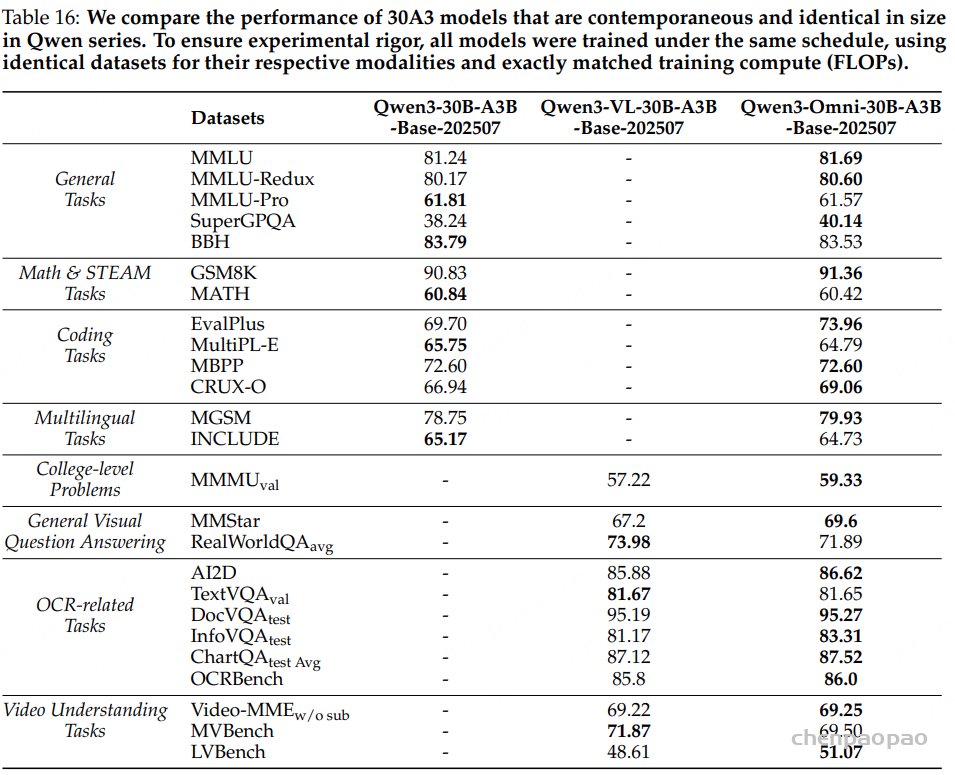

跨模态性能不退化评估

由于不同模态的异质性,每种模态都需要不同的预训练目标和优化技术,因此采用标准化的数据整合方法变得不切实际。为了确保公平而严格的评估,我们设计了一个 受控对比实验。具体方法如下:我们预训练了三个参数量匹配的模型:仅文本基线模型(text-only baseline)、仅视觉基线模型(vision-only baseline)以及多模态 “Omni” 模型。为了隔离多模态效应,所有潜在的混淆变量都得到了精确控制。具体而言,Omni 模型使用与单模态基线相同的文本和视觉语料进行训练。此外,我们在所有模型间对关键训练参数进行了对齐,包括学习率策略、批大小以及每种模态的有效训练轮数(通过调整数据采样比例进行归一化)。因此,本实验中唯一的区别在于 Omni 模型在预训练阶段加入了额外的音频和视听数据。

如表 16 所示,我们评估了涵盖多种模态的综合基准,包括:文本模态(通用任务、数学与 STEM 任务、编程任务、多语言任务)、视觉模态(大学水平问题、OCR 相关任务)以及视频模态(视频理解任务)。实验结果表明:

- 在文本预训练的早期阶段混合单模态与跨模态数据,可以在所有模态上实现更优性能;

- 联合多模态训练能够促进不同模态之间的相互增强,从而提升单模态的表现;

这充分展示了 Qwen3-Omni 在多样化评估标准下的通用性与稳健性。

根据表 16 及内部实验结果,我们观察到以下规律:

- 预训练早期的多模态融合允许语言模型与视觉或音频共同训练,而不会导致语言能力下降;

- 文本模态的加入显著提升了视觉和音频的性能,但从视觉或音频信号中并未观察到语言能力的显著提升;

- 从经验来看,加入音频数据可以持续提升视觉模态在 MMMU 基准和 OCR 相关任务上的表现。

结论:

Qwen3-Omni 是一个里程碑:据我们所知,它首次提供了证据表明,完全整合的端到端多模态训练可以在不降低核心语言能力和其他模态表现的情况下实现。我们希望与学术社区分享这些成果,并期待能够激发更多相关研究。

未来工作中,我们计划在多个方向进一步推进模型发展,包括多说话人语音识别(multi-speaker ASR)、视频 OCR、视听主动学习,以及增强对基于代理(agent)工作流和函数调用的支持。

相关知识补充: