给定一个字符串 s ,请你找出其中不含有重复字符的 最长子串 的长度。

示例 1:

输入: s = "abcabcbb"

输出: 3

解释: 因为无重复字符的最长子串是 "abc",所以其长度为 3。示例 2:

输入: s = "bbbbb"

输出: 1

解释: 因为无重复字符的最长子串是 "b",所以其长度为 1。示例 3:

输入: s = "pwwkew"

输出: 3

解释: 因为无重复字符的最长子串是 "wke",所以其长度为 3。

请注意,你的答案必须是 子串 的长度,"pwke" 是一个子序列,不是子串。

示例 4:

输入: s = ""

输出: 0思路:

我第一遍写的时候,想法是把字符串作为一个队列输入,当前输入到队列 中的j in 队列时,就把队列中第一个出列,并更新maxlenght。代码如下 :

# @lc code=start

class Solution:

def lengthOfLongestSubstring(self, x: str) -> int:

maxlength = 0

lens = len(x)

for i in range(lens-1):

for j in range(i+1,lens):

if x[j] in x[i:j] or x[j]==x[i]:

maxlength = maxlength if maxlength>(j-i) else (j-i)

break

elif j == lens-1:

maxlength = maxlength if maxlength>(j-i+1) else (j-i+1)

break

else:

continue

return maxlength

# @lc code=end但是通过率不是100,因为没有考虑空字符串。

Wrong Answer

- 879/987 cases passed (N/A)

Testcase

" "可以在开始加一个判断 if ” ” in string

class Solution:

def lengthOfLongestSubstring(self, x: str) -> int:

maxlength = 0

lens = len(x)

if " " in x[0:1] or lens==1:

return 1

for i in range(lens-1):

for j in range(i+1,lens):

if x[j] in x[i:j] or x[j]==x[i]:

maxlength = maxlength if maxlength>(j-i) else (j-i)

break

elif j == lens-1:

maxlength = maxlength if maxlength>(j-i+1) else (j-i+1)

break

else:

continue

return maxlength

Accepted

- 987/987 cases passed (520 ms)

- Your runtime beats 8.75 % of python3 submissions

- Your memory usage beats 16.81 % of python3 submissions (15.2 MB)

改进版:

滑动窗口

思路和算法

我们先用一个例子考虑如何在较优的时间复杂度内通过本题。

我们不妨以示例一中的字符串 \texttt{abcabcbb}abcabcbb 为例,找出从每一个字符开始的,不包含重复字符的最长子串,那么其中最长的那个字符串即为答案。对于示例一中的字符串,我们列举出这些结果,其中括号中表示选中的字符以及最长的字符串:

以 \(\texttt{(a)bcabcbb}(a)bcabcbb\) 开始的最长字符串为 \(\texttt{(abc)abcbb}(abc)abcbb\);

以 \(\texttt{a(b)cabcbb}a(b)cabcbb\) 开始的最长字符串为 \(\texttt{a(bca)bcbb}a(bca)bcbb\);

以 \(\texttt{ab(c)abcbb}ab(c)abcbb\) 开始的最长字符串为 \(\texttt{ab(cab)cbb}ab(cab)cbb\);

以 \(\texttt{abc(a)bcbb}abc(a)bcbb\) 开始的最长字符串为 \(\texttt{abc(abc)bb}abc(abc)bb\);

以 \(\texttt{abca(b)cbb}abca(b)cbb\) 开始的最长字符串为 \(\texttt{abca(bc)bb}abca(bc)bb\);

以 \(\texttt{abcab(c)bb}abcab(c)bb\) 开始的最长字符串为 \(\texttt{abcab(cb)b}abcab(cb)b\);

以 \(\texttt{abcabc(b)b}abcabc(b)b\) 开始的最长字符串为\(\texttt{abcabc(b)b}abcabc(b)b\);

以 \(\texttt{abcabcb(b)}abcabcb(b)\) 开始的最长字符串为 \(\texttt{abcabcb(b)}abcabcb(b)\)。

发现了什么?如果我们依次递增地枚举子串的起始位置,那么子串的结束位置也是递增的!这里的原因在于,假设我们选择字符串中的第 k个字符作为起始位置,并且得到了不包含重复字符的最长子串的结束位置为 r_k。那么当我们选择第 k+1 个字符作为起始位置时,首先从 k+1 到 r_k的字符显然是不重复的,并且由于少了原本的第 k个字符,我们可以尝试继续增大 r_k,直到右侧出现了重复字符为止。这样一来,我们就可以使用「滑动窗口」来解决这个问题了:

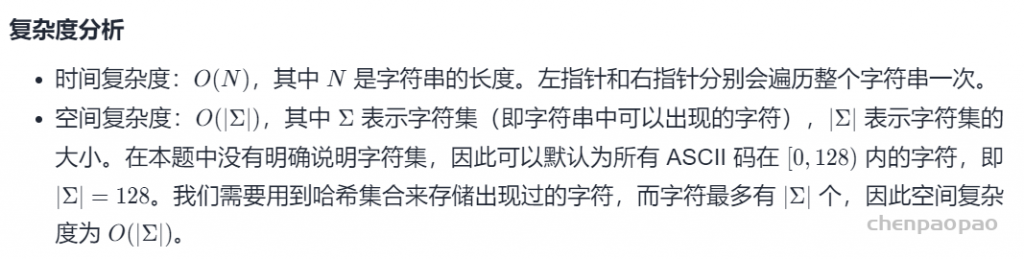

我们使用两个指针表示字符串中的某个子串(或窗口)的左右边界,其中左指针代表着上文中「枚举子串的起始位置」,而右指针即为上文中的 r_k在每一步的操作中,我们会将左指针向右移动一格,表示我们开始枚举下一个字符作为起始位置,然后我们可以不断地向右移动右指针,但需要保证这两个指针对应的子串中没有重复的字符。在移动结束后,这个子串就对应着以左指针开始的,不包含重复字符的最长子串。我们记录下这个子串的长度;

在枚举结束后,我们找到的最长的子串的长度即为答案

class Solution:

def lengthOfLongestSubstring(self, s: str) -> int:

# 哈希集合,记录每个字符是否出现过

occ = set()

n = len(s)

# 右指针,初始值为 -1,相当于我们在字符串的左边界的左侧,还没有开始移动

rk, ans = -1, 0

for i in range(n):

if i != 0:

# 左指针向右移动一格,移除一个字符

occ.remove(s[i - 1])

while rk + 1 < n and s[rk + 1] not in occ:

# 不断地移动右指针

occ.add(s[rk + 1])

rk += 1

# 第 i 到 rk 个字符是一个极长的无重复字符子串

ans = max(ans, rk - i + 1)

return ans

- 哈希Map 只需一次遍历, more efficiency

- 附

Python代码

class Solution:

def lengthOfLongestSubstring(self, s: str) -> int:

k, res, c_dict = -1, 0, {}

for i, c in enumerate(s):

if c in c_dict and c_dict[c] > k: # 字符c在字典中 且 上次出现的下标大于当前长度的起始下标

k = c_dict[c]

c_dict[c] = i

else:

c_dict[c] = i

res = max(res, i-k)

return res

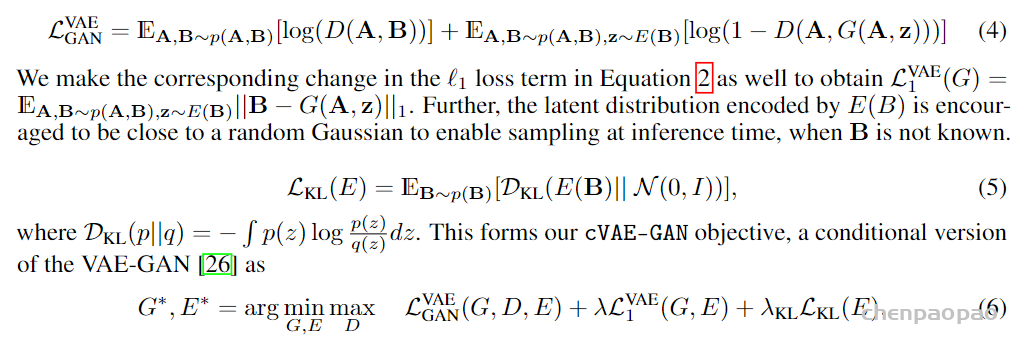

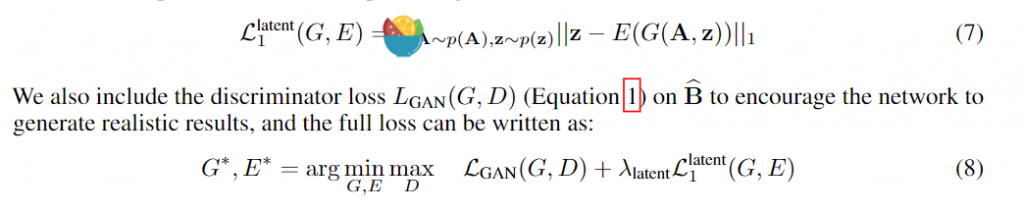

。 此时为了衡量重构和真实的误差,这里用了L1损失和GAN的对抗思想实现,我们在后面损失函数分析部分再说。这样cVAE-GAN部分就可以训练了,cVAE GAN的重点还是在得到的embedding z。

。 此时为了衡量重构和真实的误差,这里用了L1损失和GAN的对抗思想实现,我们在后面损失函数分析部分再说。这样cVAE-GAN部分就可以训练了,cVAE GAN的重点还是在得到的embedding z。