论文:https://arxiv.org/pdf/2204.08714v2.pdf

代码:https://github.com/megvii-research/NAFNet

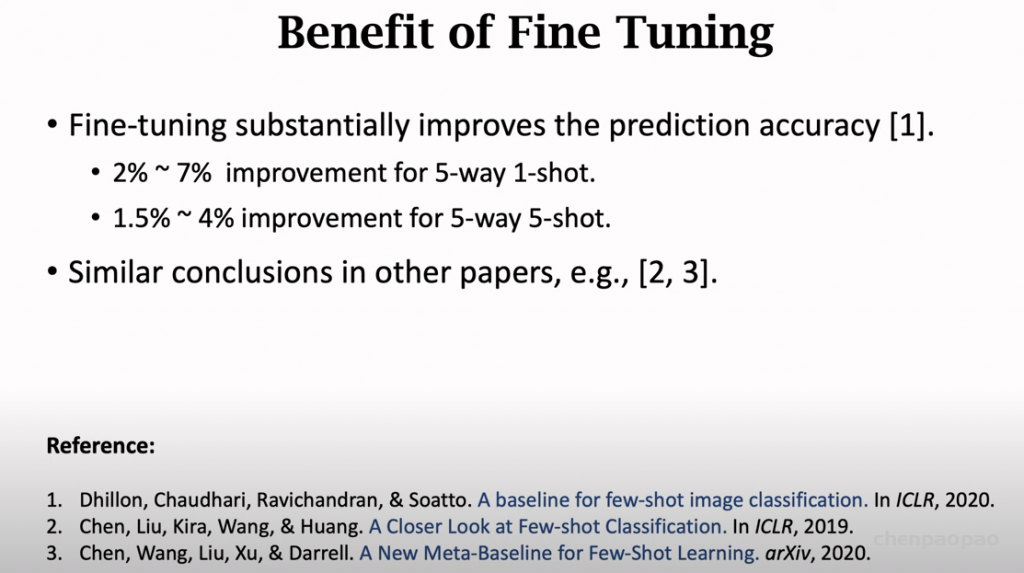

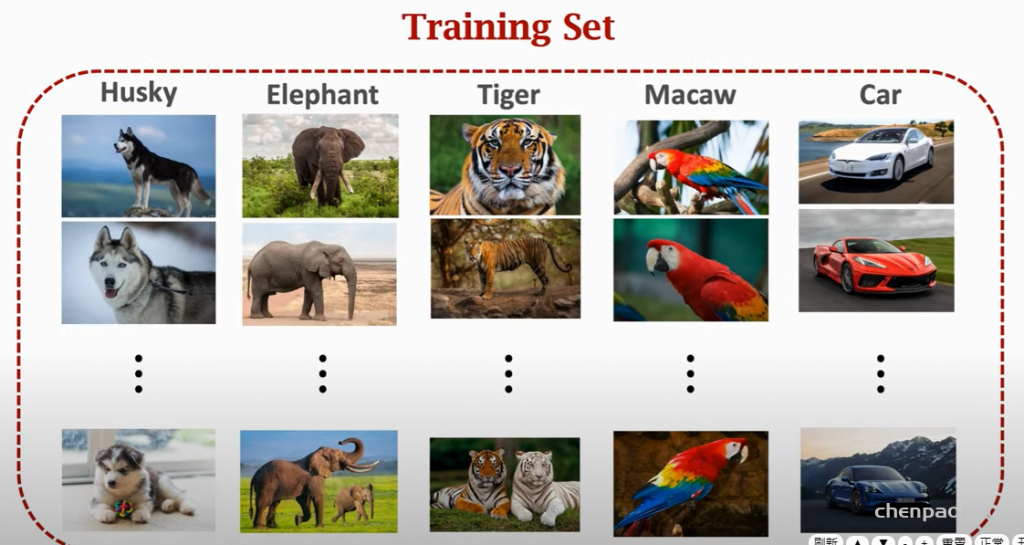

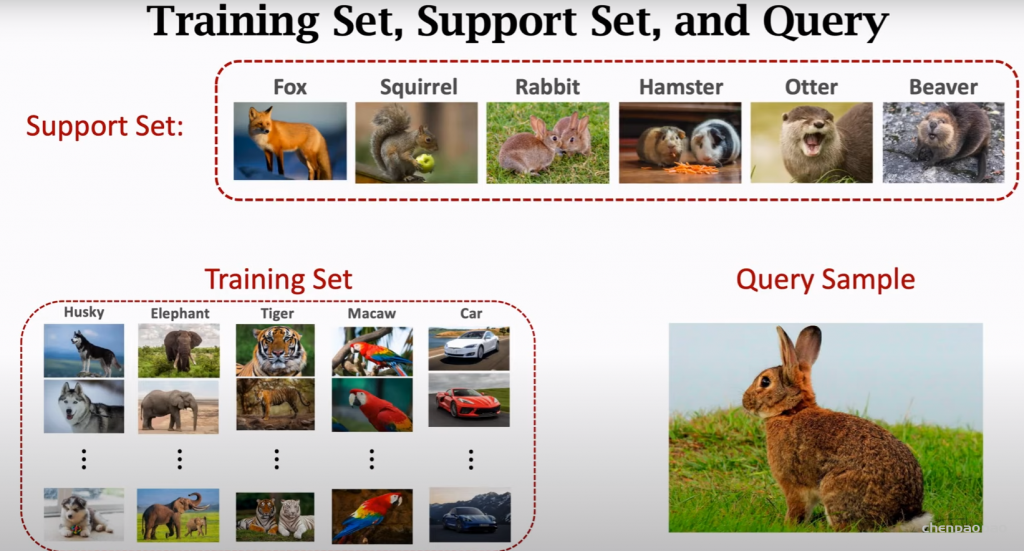

近日,New Trends in Image Restoration and Enhancement (以下简称:NTIRE) 比赛结果揭晓,旷视研究院荣获双目图像超分辨率赛道的冠军。NTIRE 即“图像恢复与增强的新趋势”,是近年来计算机图像恢复领域最具影响力的一场全球性赛事,由苏黎世联邦理工学院计算机视觉实验室(Computer Vision Laboratory, ETH Zurich)主办,每年都会吸引大量的关注者和参赛者。

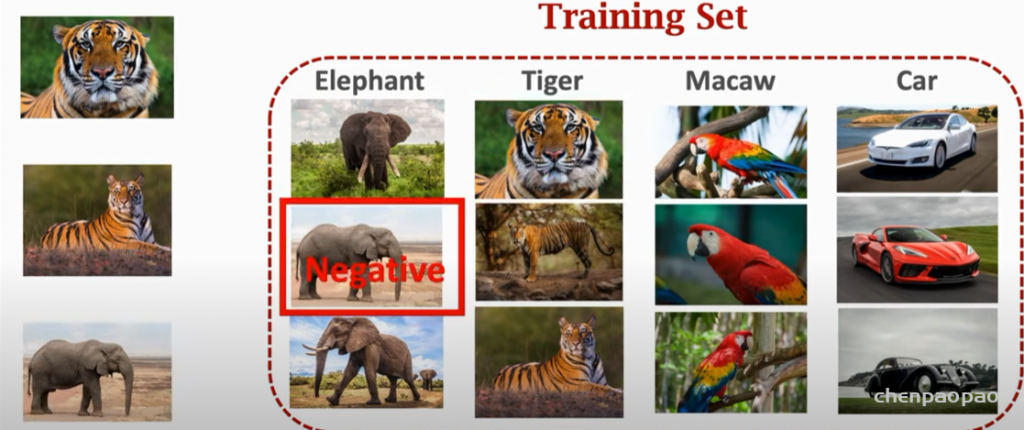

双目图像超分辨率挑战赛 (Stereo Image Super-Resolution Challenge)作为 NTIRE 研讨会的一部分与 CVPR 2022 一起举办,本次大赛的目的是从低分辨率(LR)双目图像重建高分辨率(HR)双目图像。

赛题简介

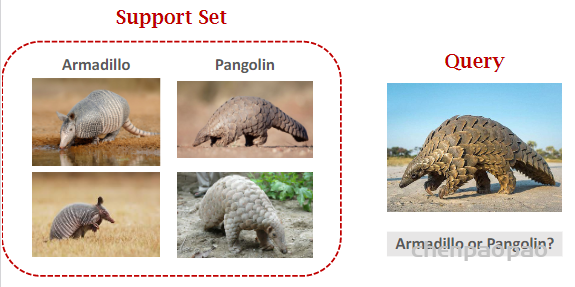

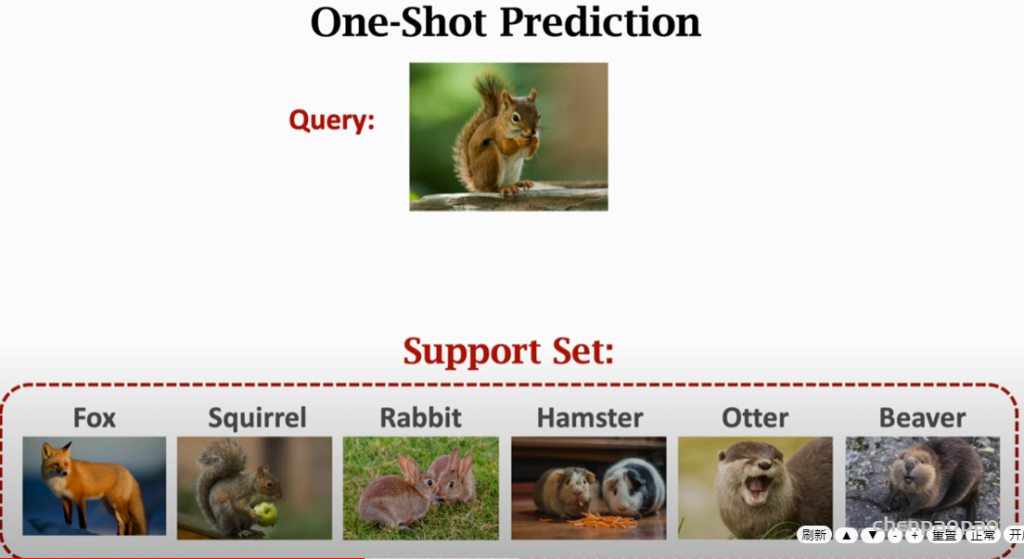

图像恢复(Image Restoration) 任务,旨在将降质的图像(如带噪声的,模糊的,低分辨率的…)恢复成清晰的图像。而本次的赛题,双目超分辨率任务,目标是用低分辨率的一对左右视角的立体图像来重建高分辨率的立体图像。与单张图像的超分辨率任务不同,双目超分辨率可以利用场景的左右两个视角提供的互补信息,从而提升图像恢复质量。

旷视夺冠算法介绍

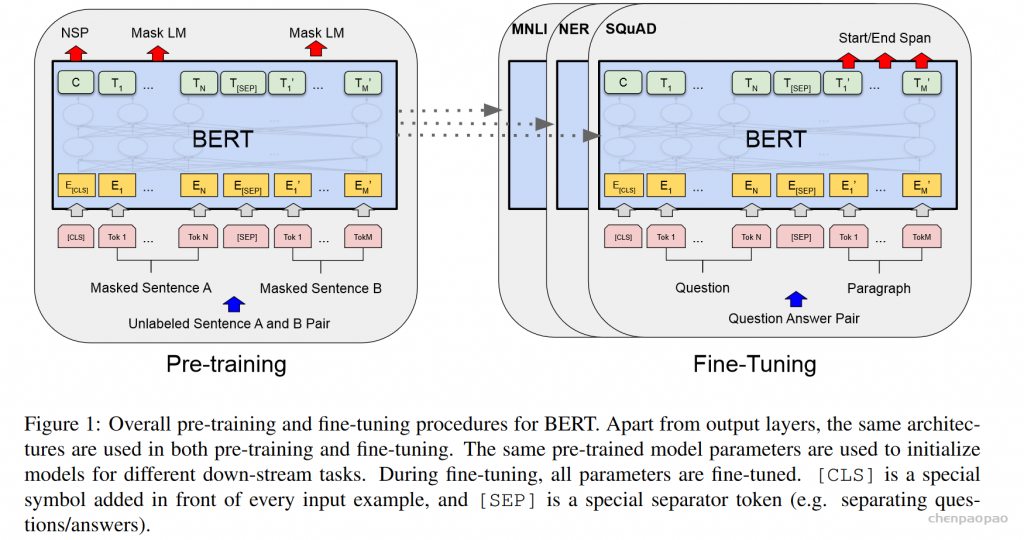

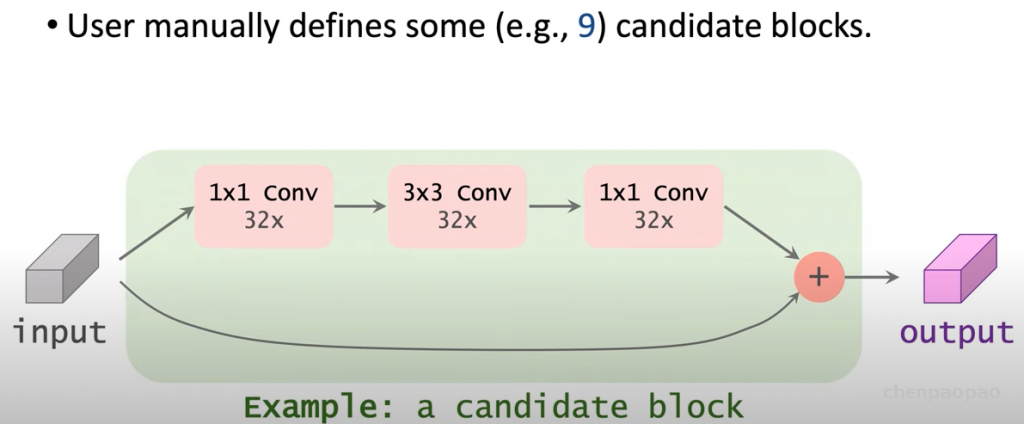

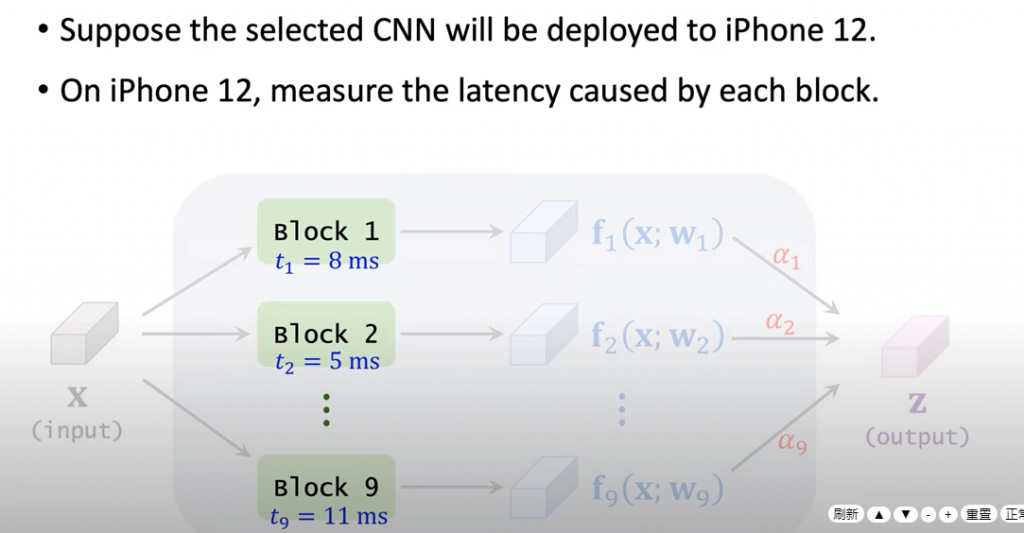

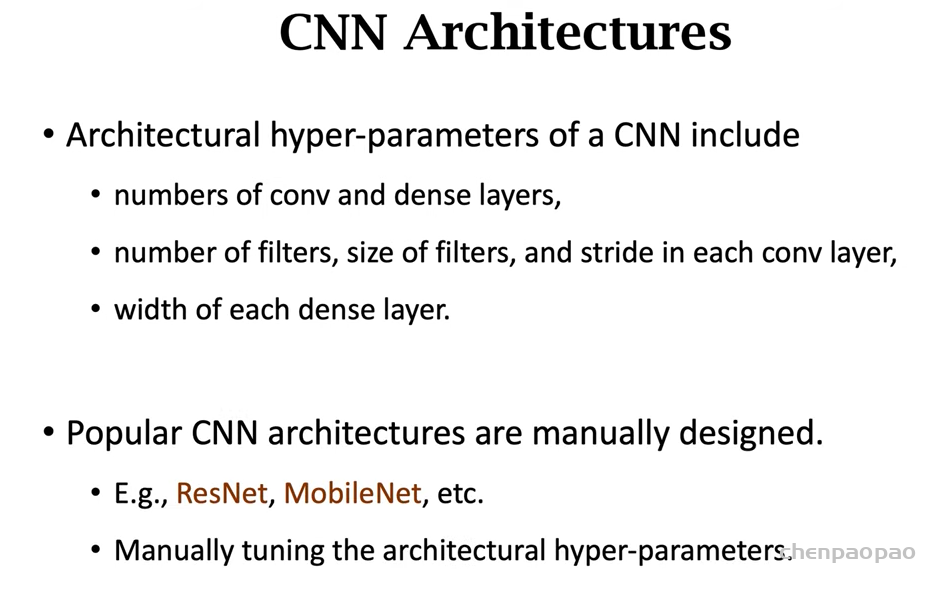

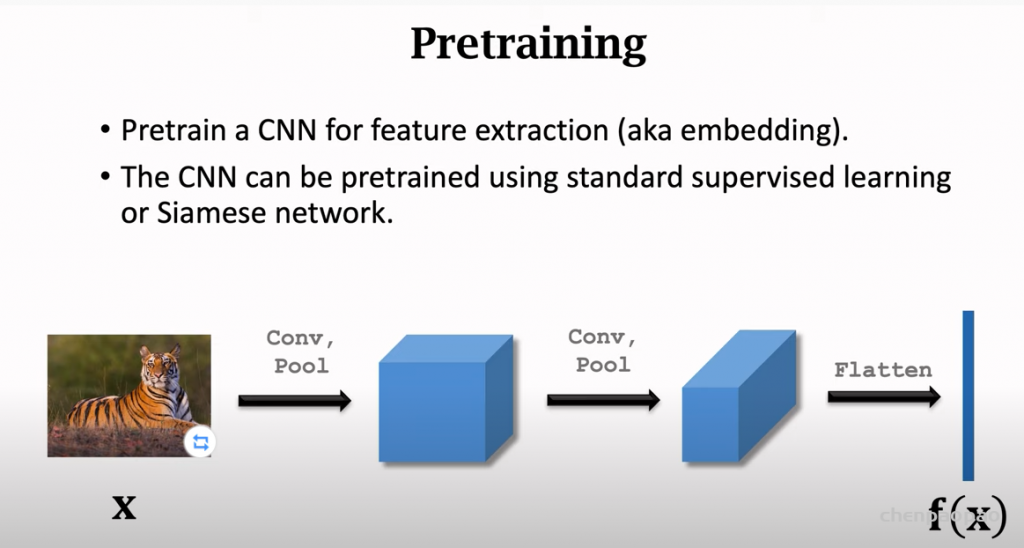

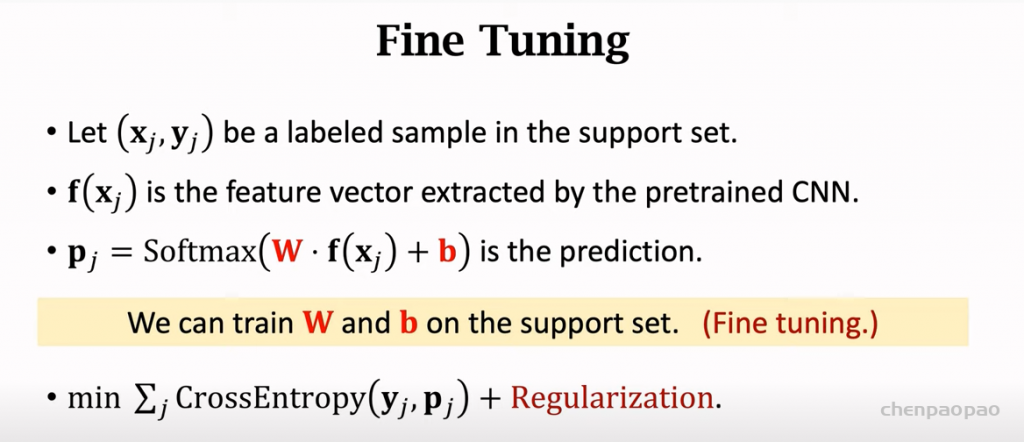

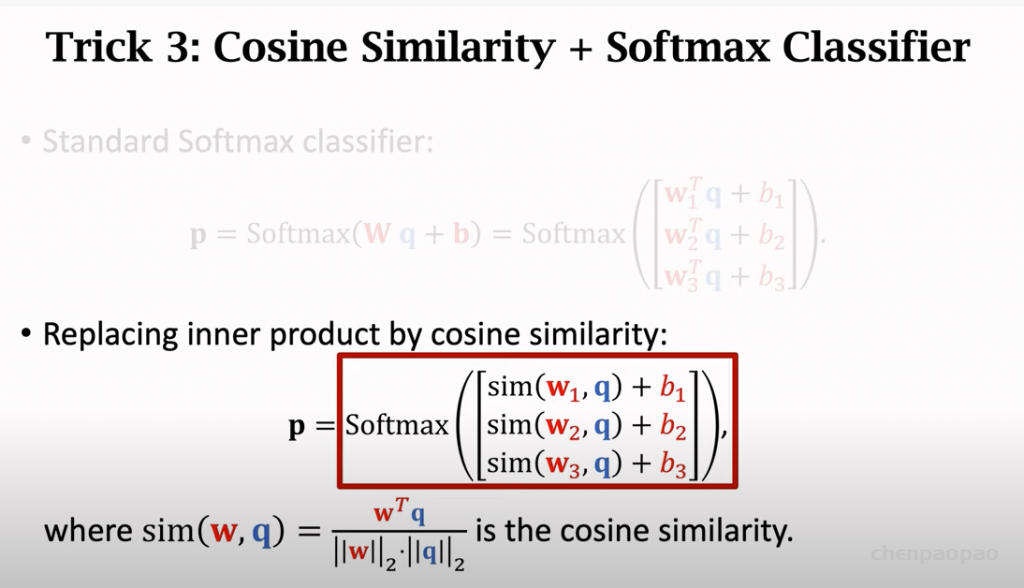

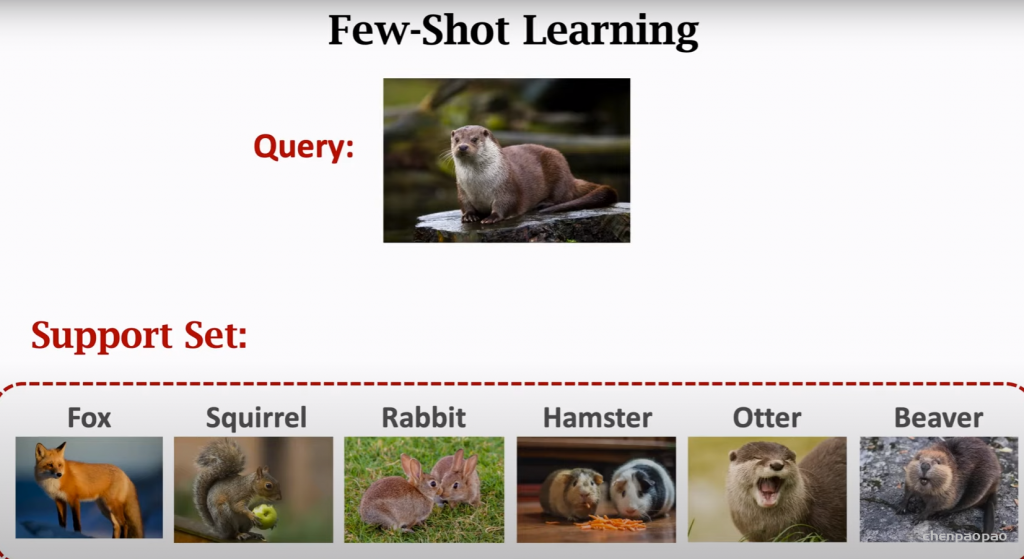

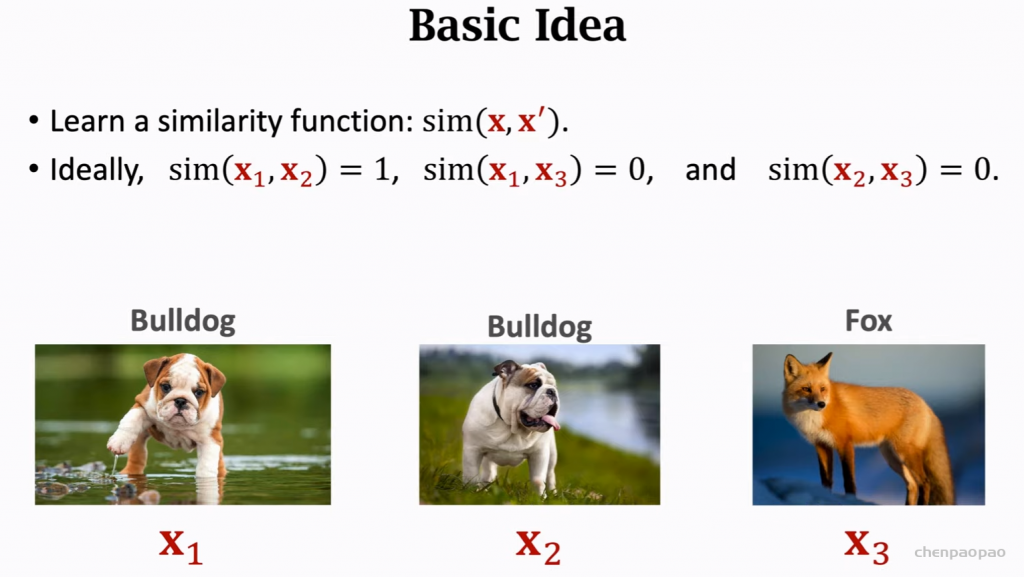

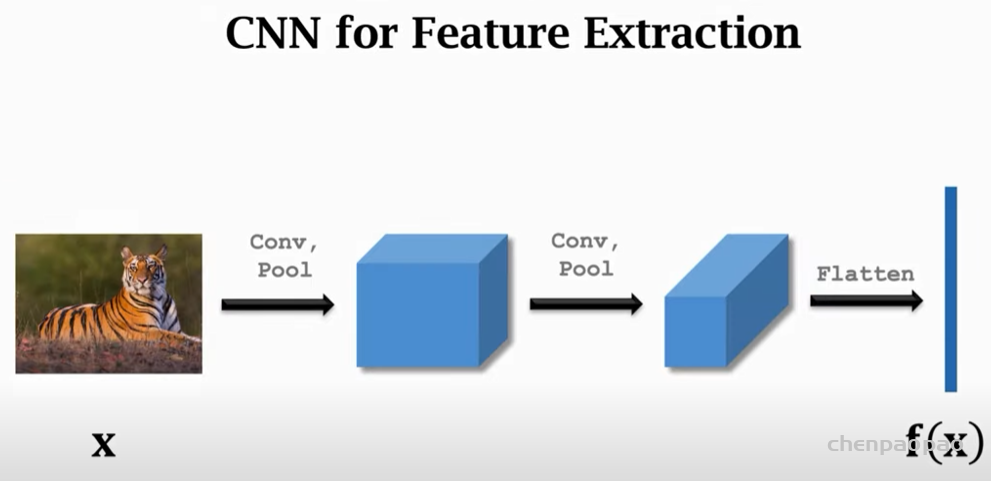

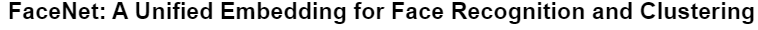

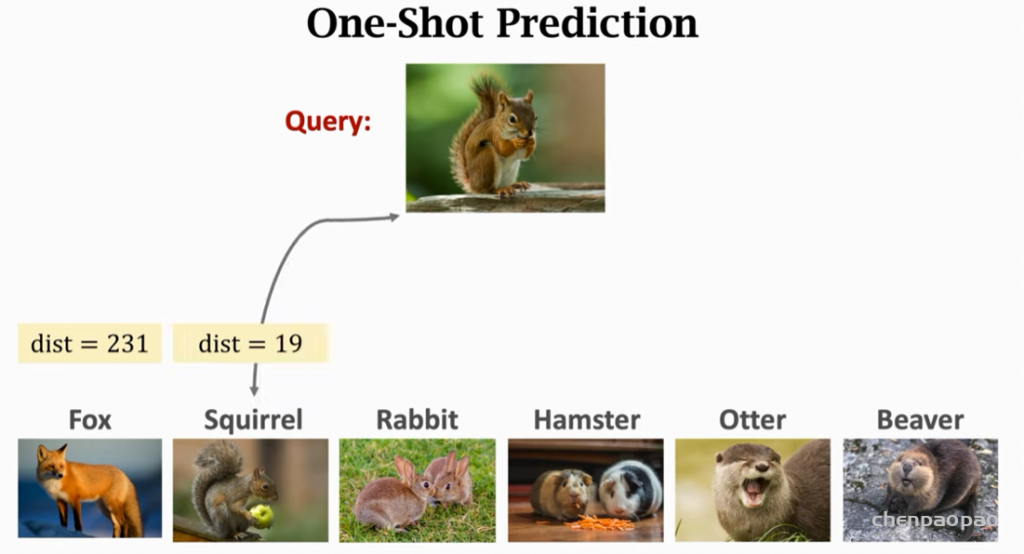

对于双目超分辨率任务,最直接的想法是将左右视角的两张图片独立的恢复成清晰图像,互不影响。而我们的工作,Nonlinear Activation Free Network for Image Restoration [2] (以下简称:NAFNet)在单张图像恢复领域提供了一个简单且强有力的基线。其效果如下图所示:

图1. NAFNet 的降噪/去模糊效果

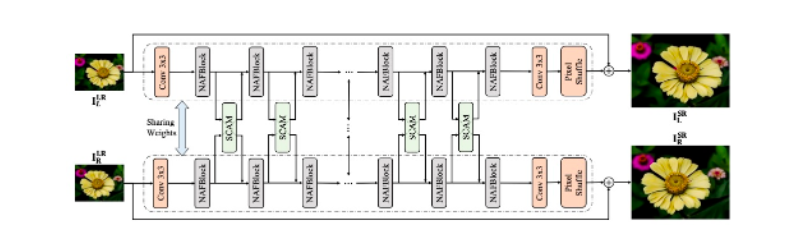

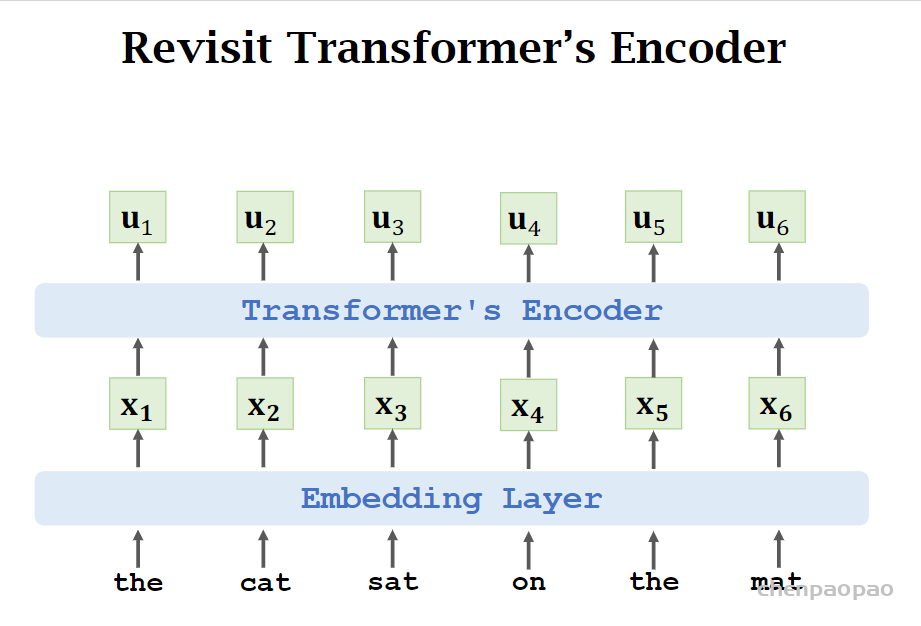

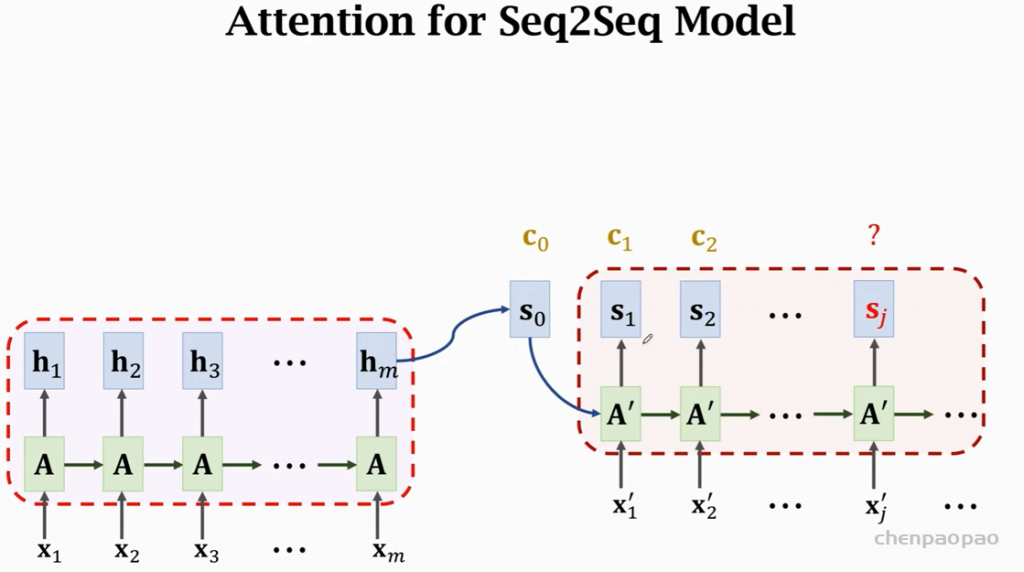

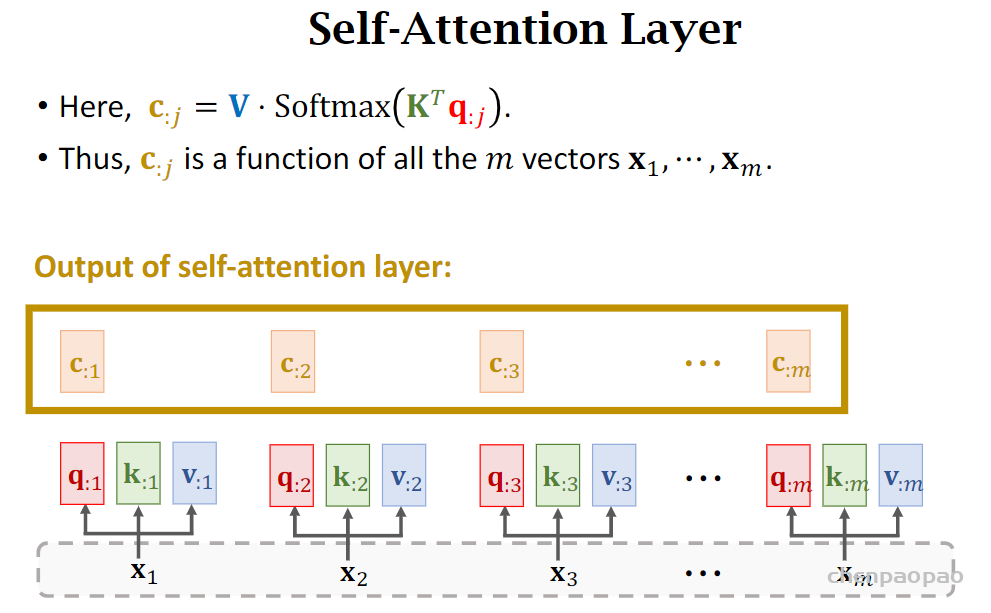

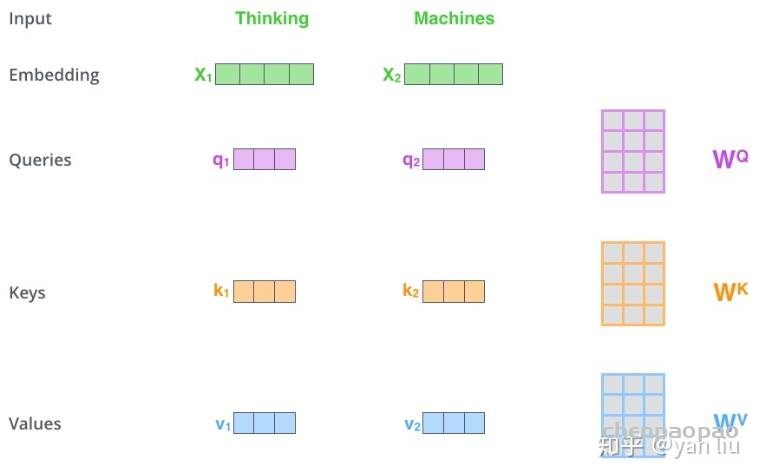

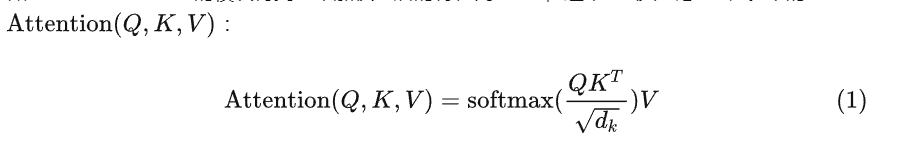

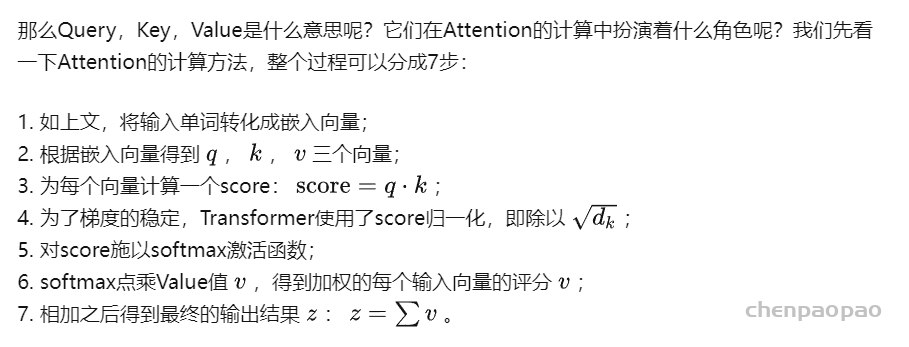

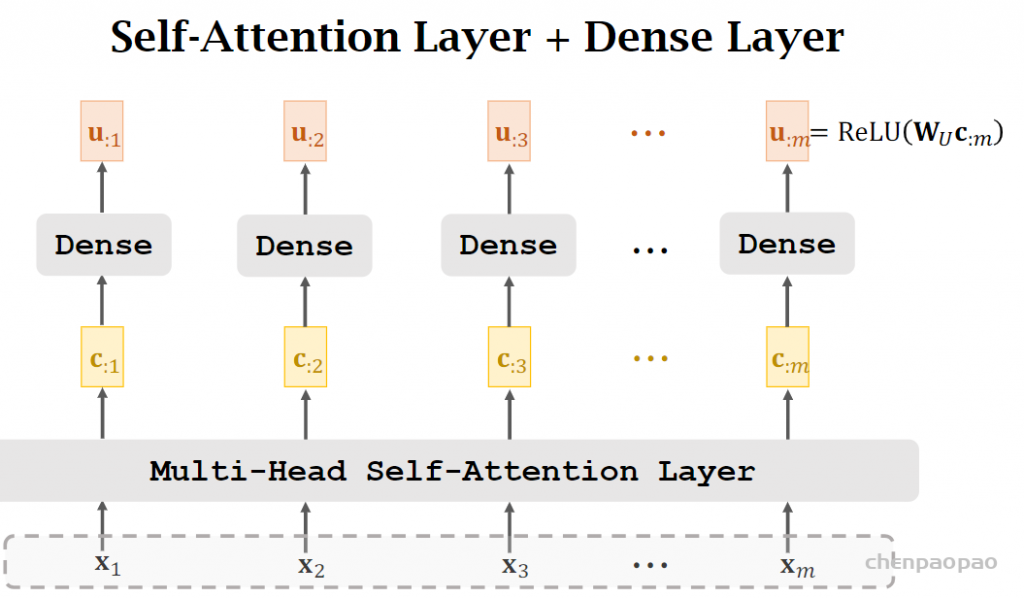

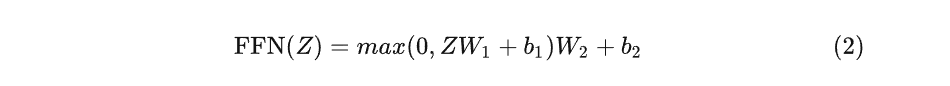

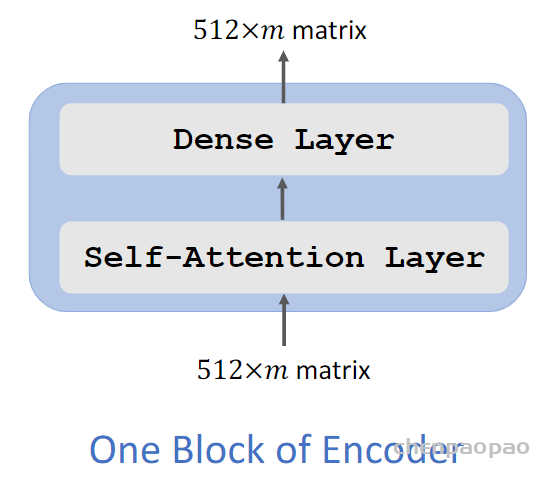

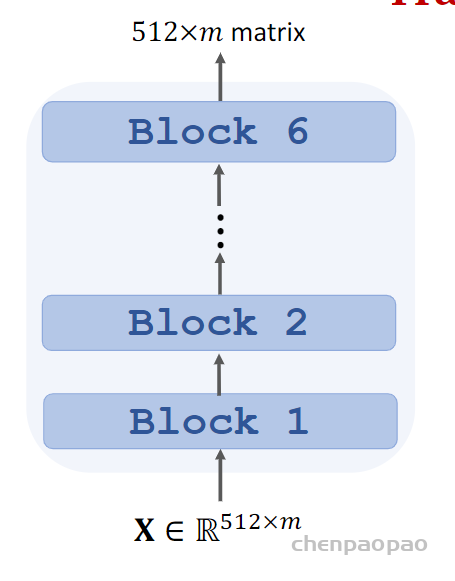

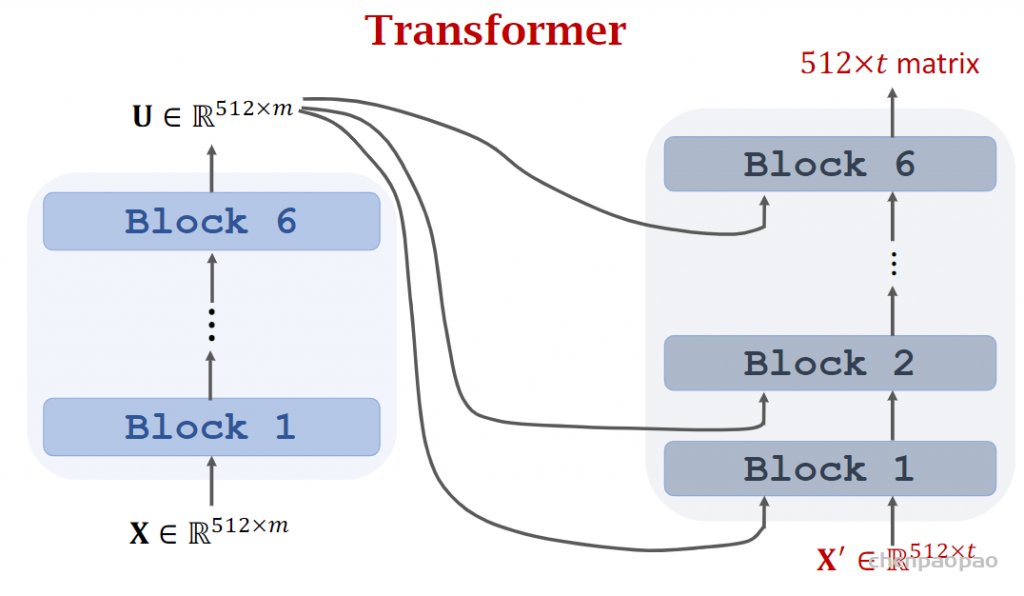

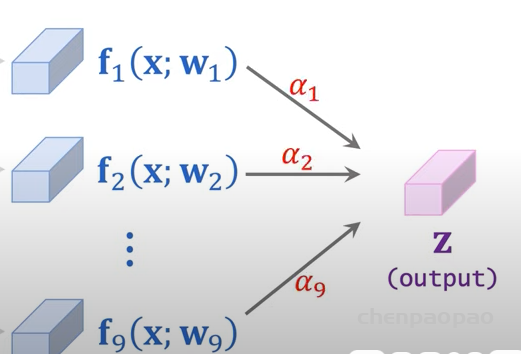

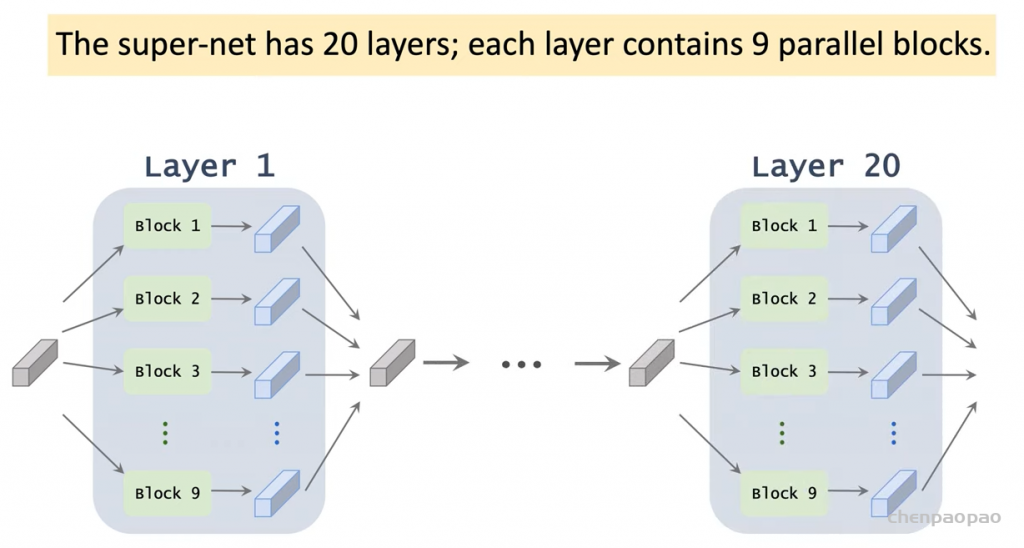

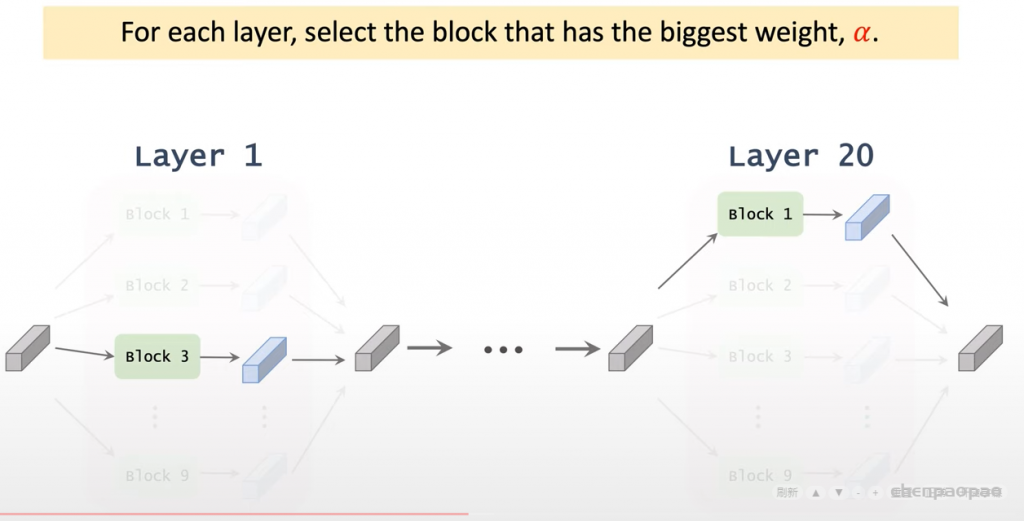

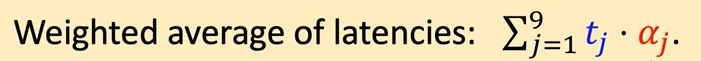

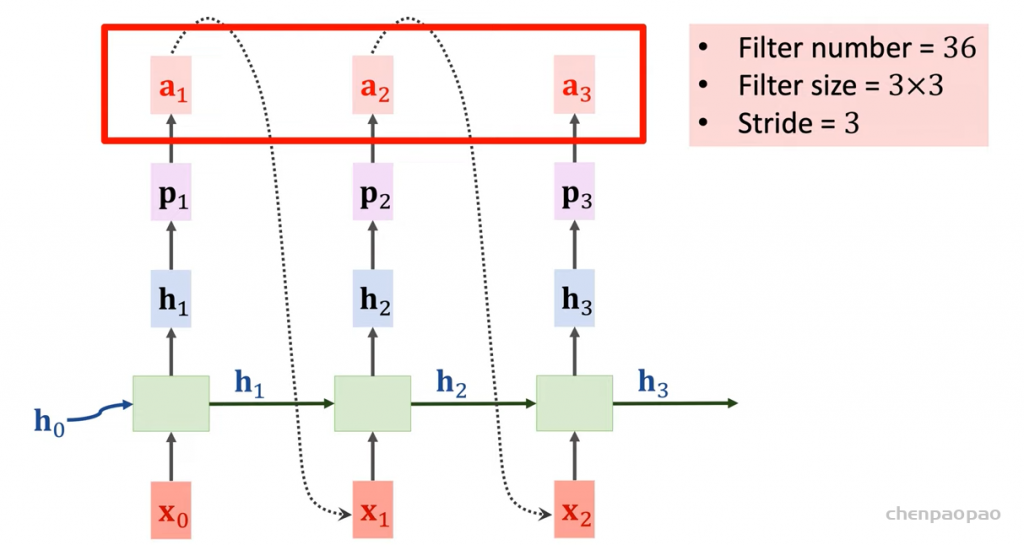

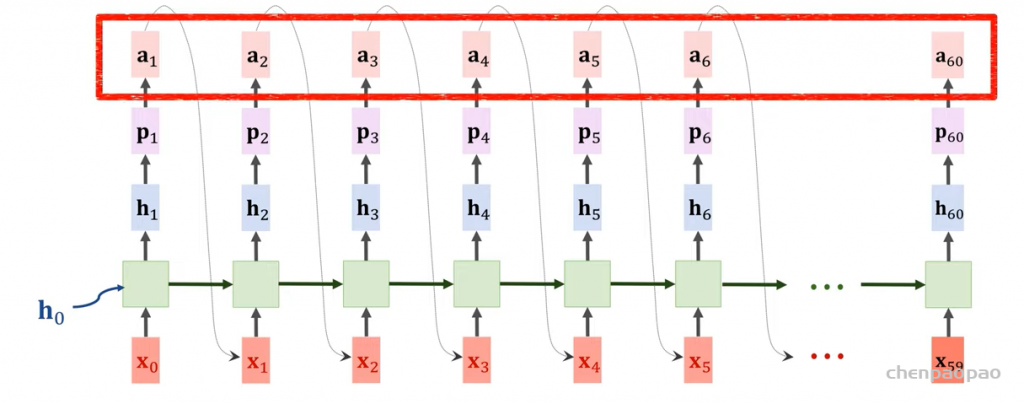

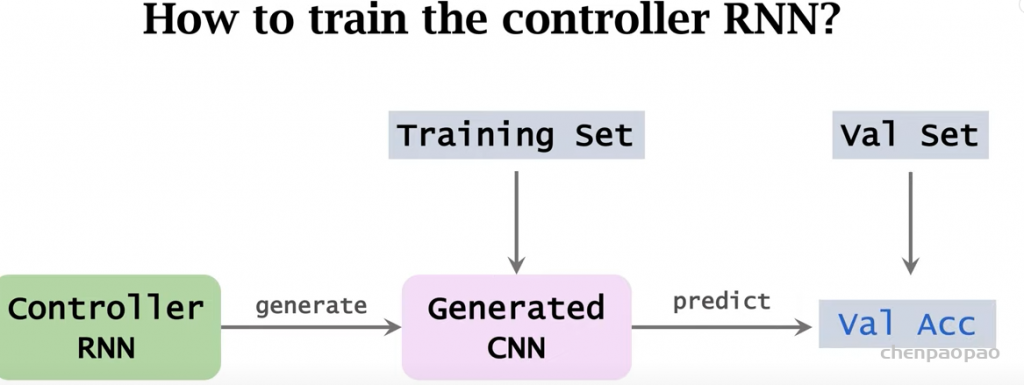

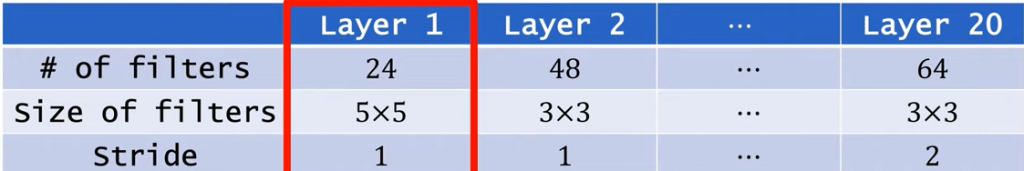

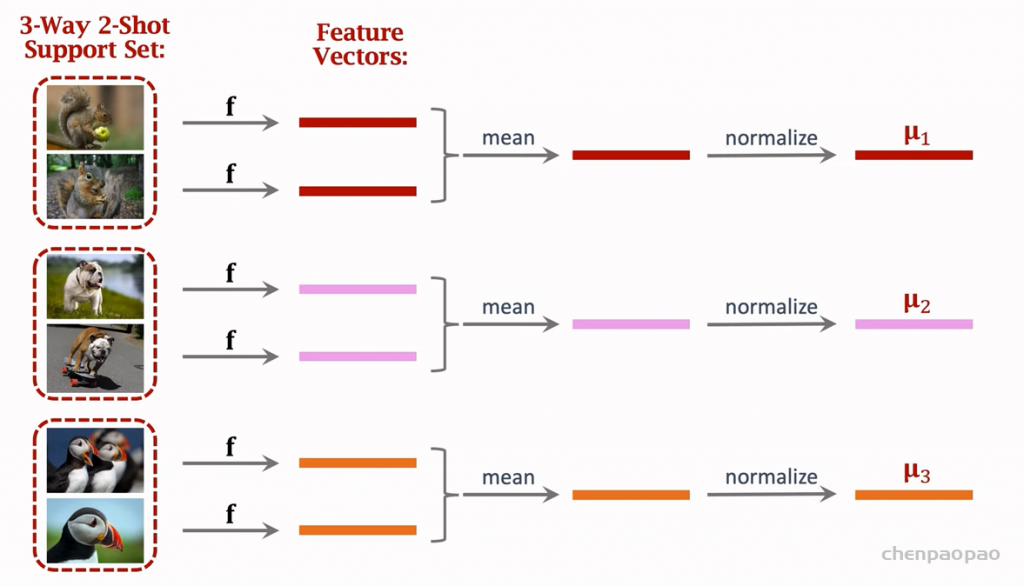

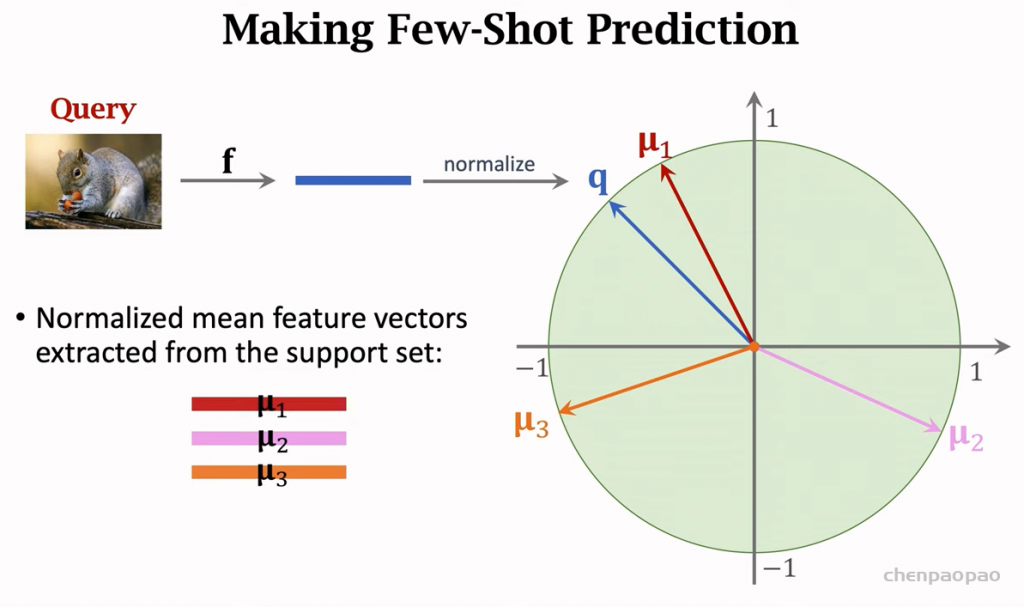

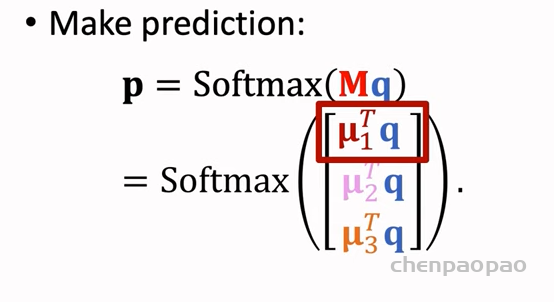

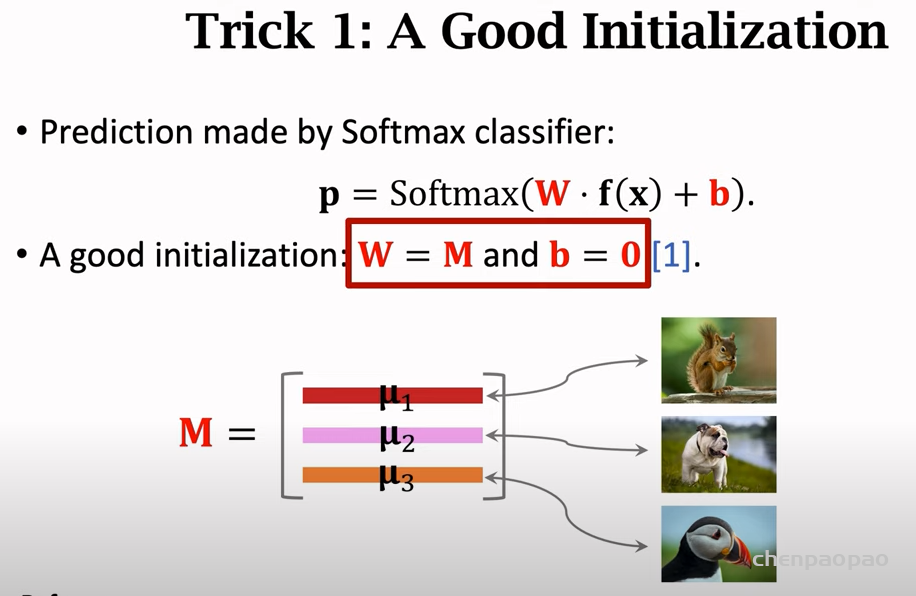

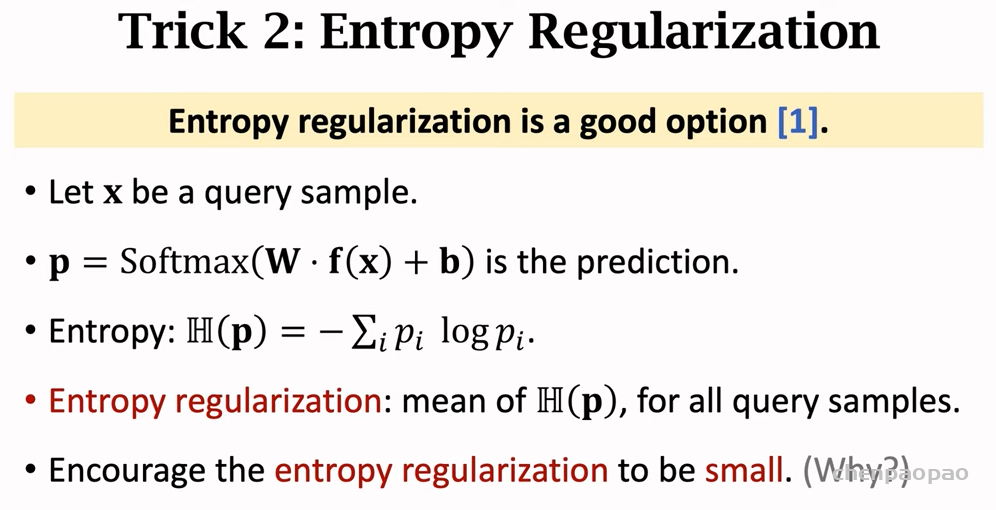

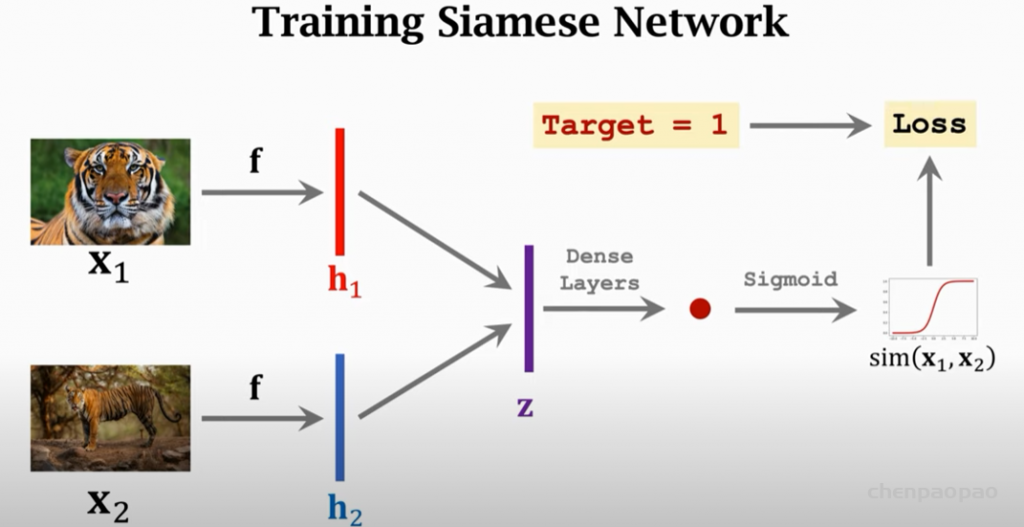

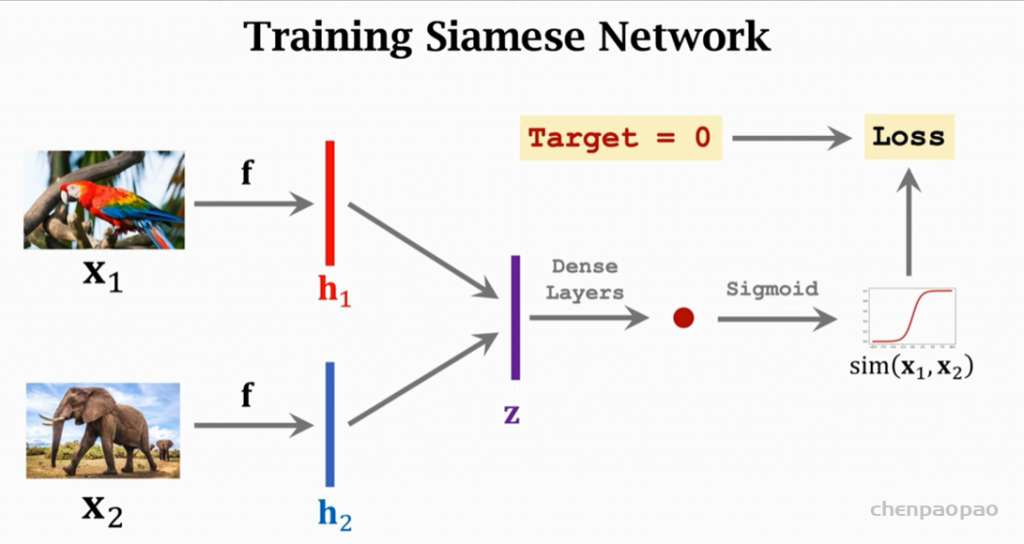

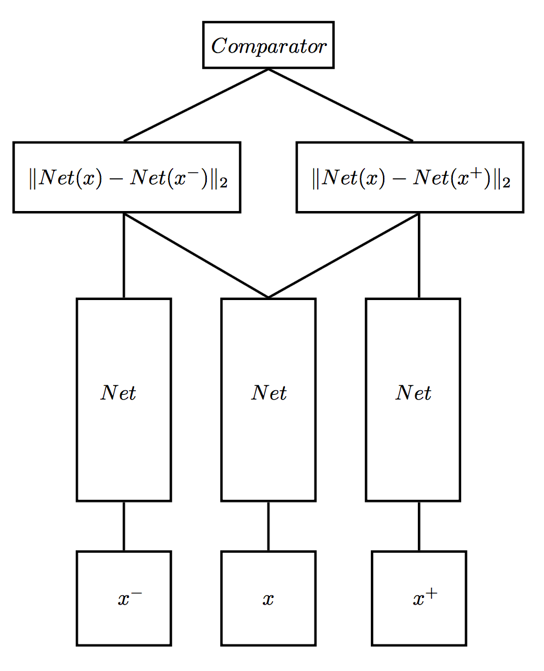

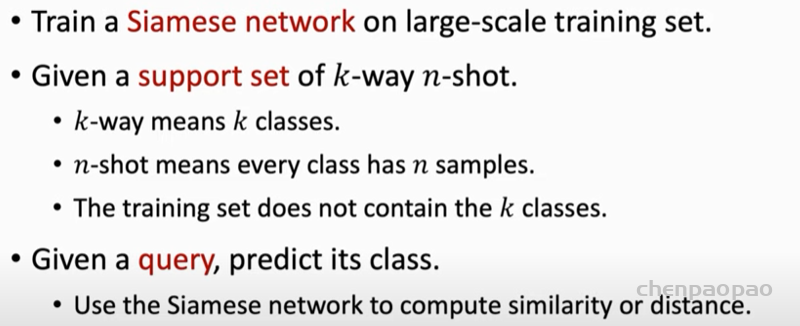

受此启发,我们直接利用 NAFNet 进行单张图像的超分辨率重建。虽然已经能取得不错的性能,但是这样的做法忽略了双目任务的特殊性:没有充分利用两个视角提供的互补信息。为此,我们在使用 NAFNet 分别提取左右两个视角的单图像特征之外,引入了立体交叉注意力模块(Stereo Cross Attention Module, 以下简称: SCAM)来融合左右视角的图像特征。我们称该方法为 NAFSSR: Stereo Image Super-Resolution Using NAFNet (以下简称:NAFSSR),其总体结构如下图所示:

图2. NAFSSR 总体结构

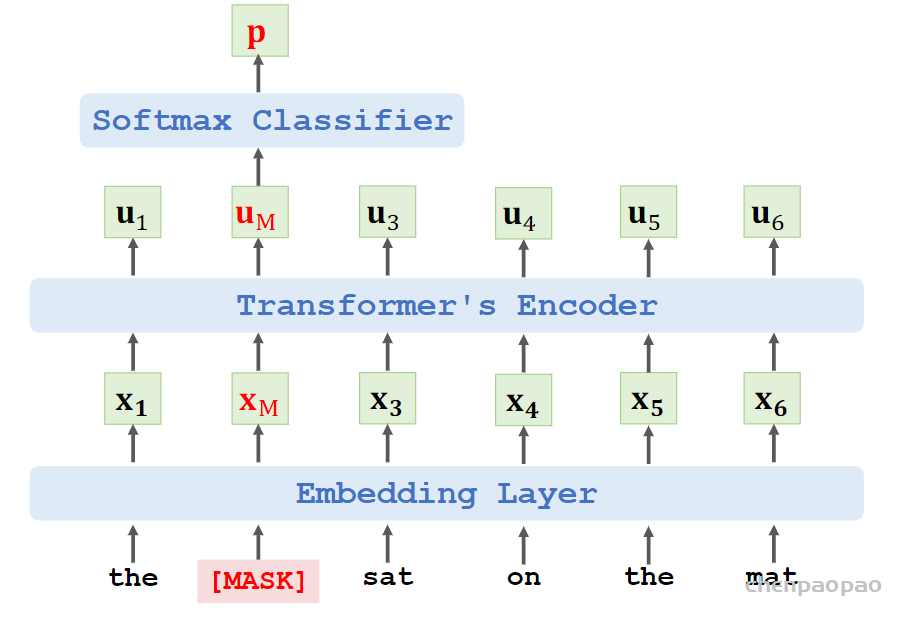

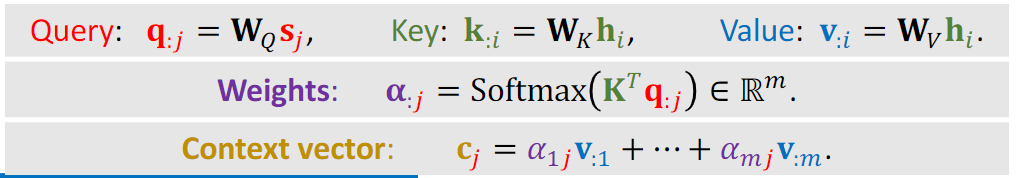

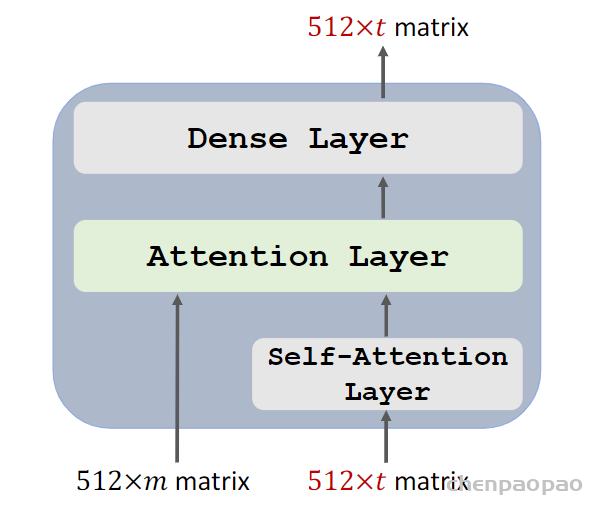

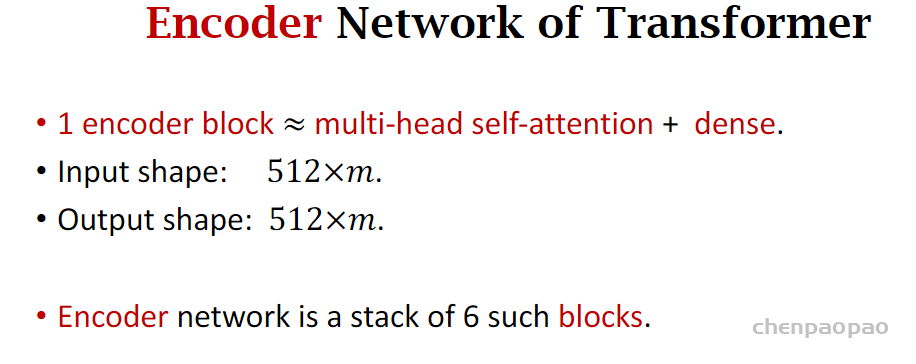

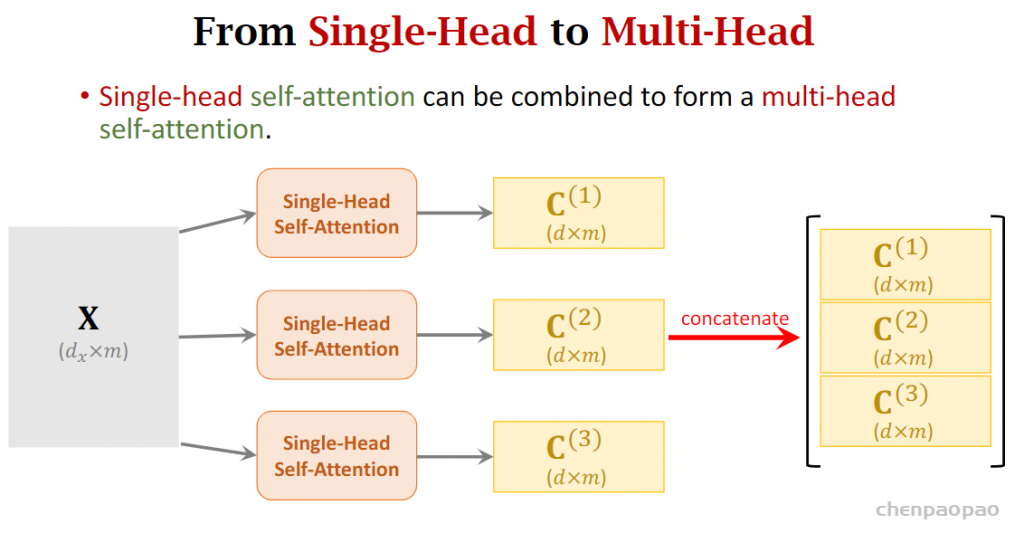

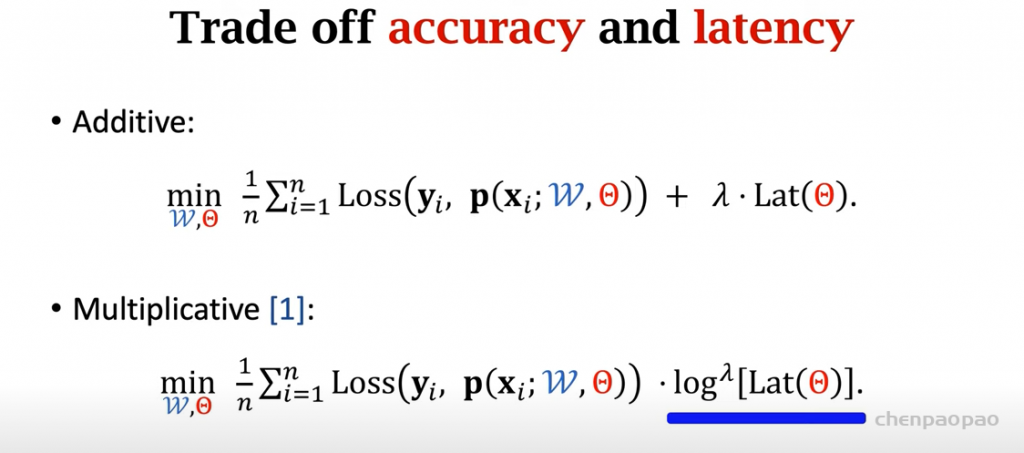

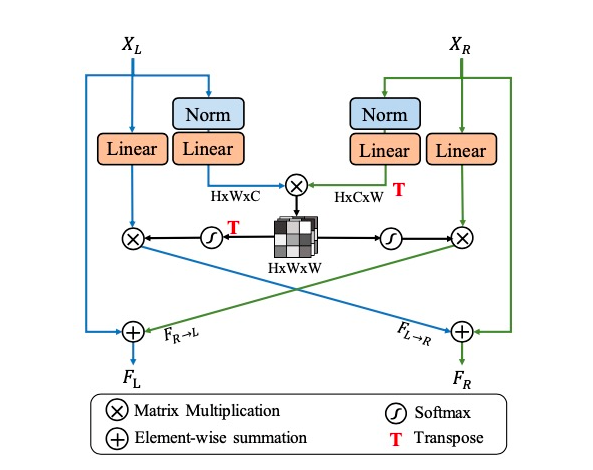

其中 NAFBlock 直接采用了 NAFNet 的模块,而 SCAM 细节如下图所示:

图3. SCAM

它用于融合 NAFNet 提取到的左右视图特征。

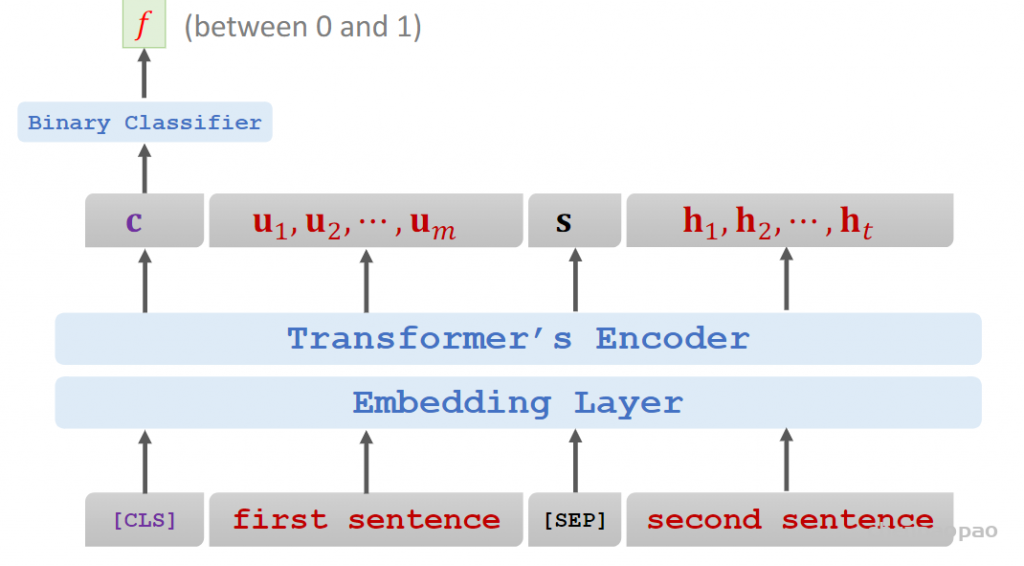

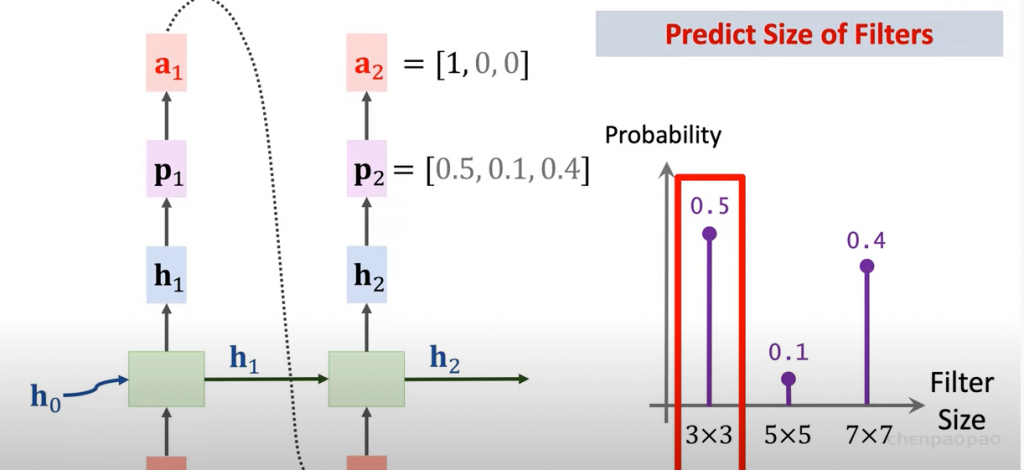

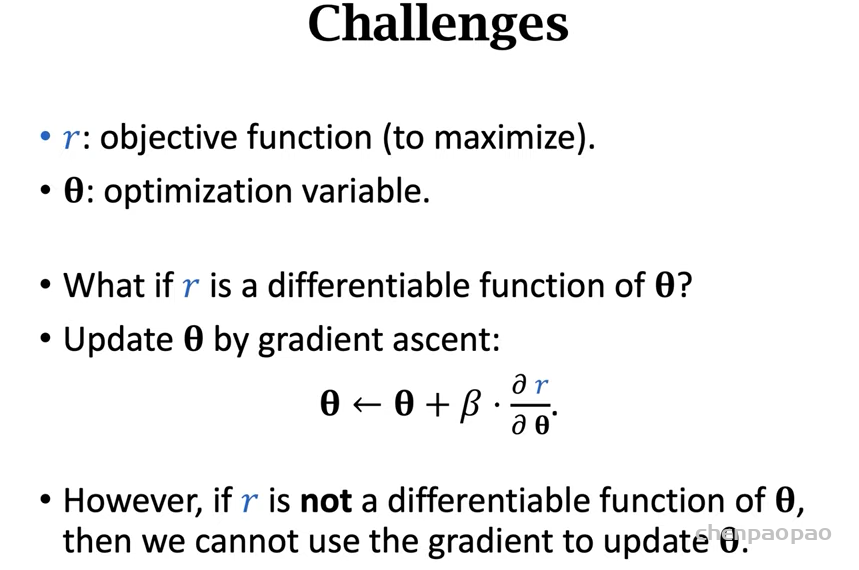

在模型设计之外,我们发现训练/测试时的统计值分布不一致问题(对于该问题,可以参考我们的另外一项工作,TLSC [3])在双目超分辨率任务中依然存在,会降低图像恢复的质量,所以我们采用了 TLSC 以缓解该不一致问题。

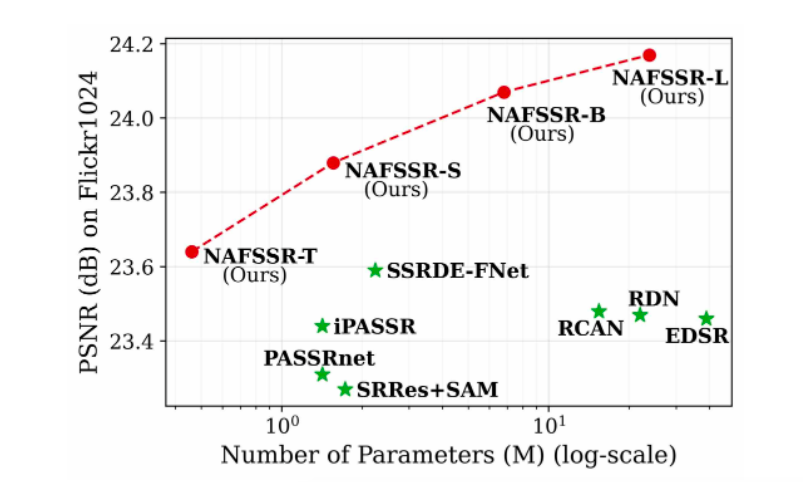

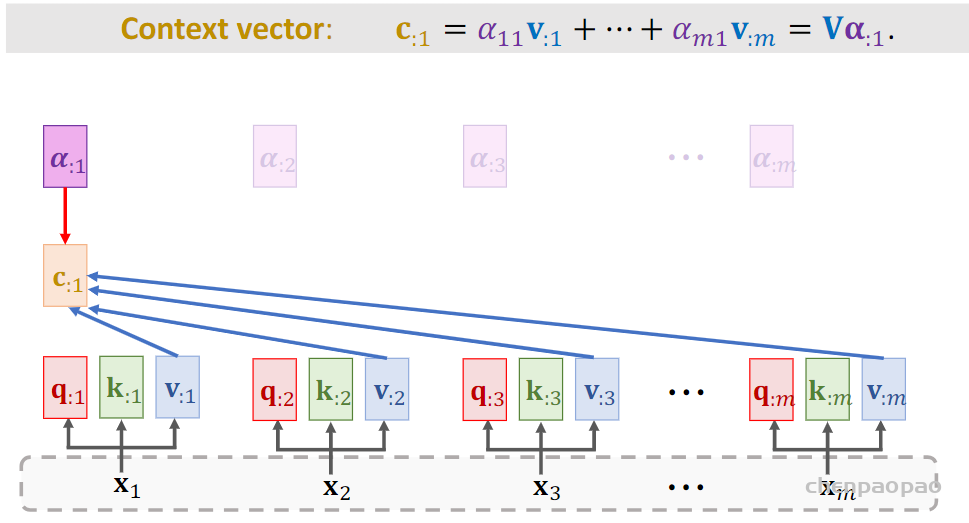

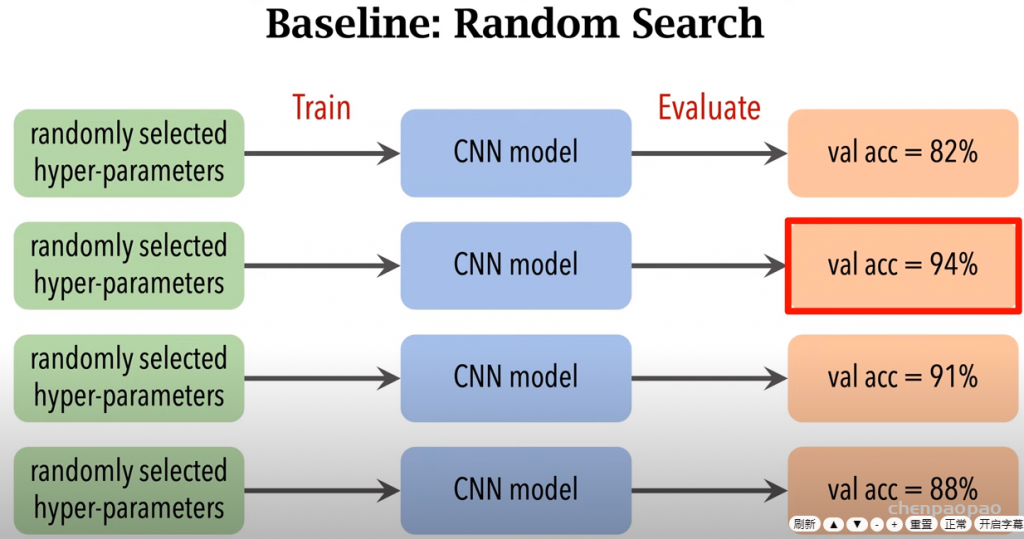

结合模型设计与训练/测试时的策略,我们在 Flicker1024 测试集上的性能如下图所示:

图4. NAFSSR 的在客观指标上和现有先进方法的对比

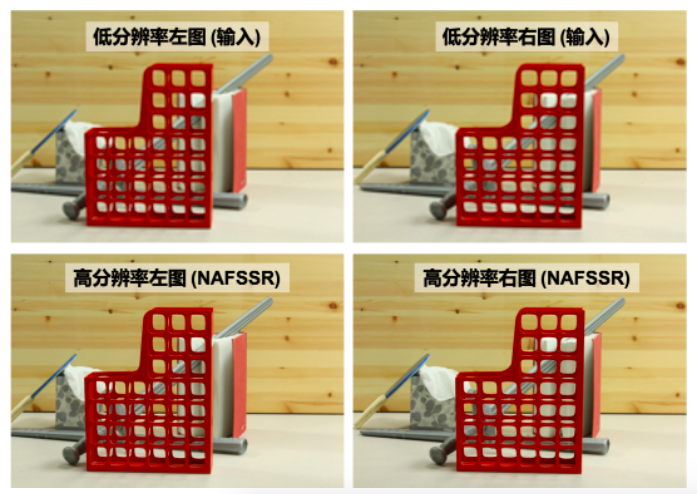

可视化结果如下图所示:

更多可视化结果,方法细节,可以参考我们的论文:

[1] NAFSSR: Stereo Image Super-Resolution Using NAFNet

[2] Simple Baselines for Image Restoration

[3] Revisiting Global Statistics Aggregation for Improving Image Restoration

来源:旷视研究院

作者:旷视研究院